ąØą░ čüą░ą╣č鹥 c 24.06.2014

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 4563

| ąÉčģ, ą┤ą░. ą×čéą▒ąŠą╣ ą┐ąŠ x2 ą▓ D5 ąĀąĄąĮą┤ąĄčĆąĄ. ą×ąĮąĖ ąĮą░ ąĮąŠą▓čŗčģ čüą╗ą░ą╣ą┤ą░čģ ą┤ąŠą┐ąĖčüą░ą╗ąĖ ą┐ąŠą┤ čüč鹊ą╗ą▒ąĖą║ą░ą╝ąĖ - DLSS4. ąÉ ąĮą░ čüčéą░čĆčŗčģ čüą╗ą░ą╣ą┤ą░čģ ąĮąĄ ą▒čŗą╗ąŠ čŹč鹊ą│ąŠ 'ąĮčÄą░ąĮčüą░'┬Ā ąĢčēąĄ čÅ ąĮąĄ čāą┤ąĖą▓ąĖą╗čüčÅ čćč鹊 ąŠąĮąĖ čüčĆą░ą▓ąĮąĖą▓ą░ą╗ąĖ 4090 ąĖ 5090 ą▓ Flux.Dev, ąĮčā ą║ą░ąĮąĄčł...┬Āąōą┤ąĄ čüą░ą╝ ą┤ąĖčäčäčāąĘąĄčĆ ą▓ąĄčüąĖčé 23.5ą│ą▒ ąÜ ąĮąĄą╝čā ąĄčēąĄ ąĮą░ą┤ąŠ ą┤ąŠą║ą░čćąĖą▓ą░čéčī VAE ąĖ CLIP ąĮą░ 10ą│ą▒. ąś ą▓čüąĄ čŹč鹊 ą▓čŗąČąĖčĆą░ąĄčé ą▓ ąĮąŠą╗čī 24ą│ą▒ ą▓ąĖą┤ąĄąŠą┐ą░ą╝čÅčéąĖ ąĖ 40ą│ą▒ ąŠą┐ąĄčĆą░čéąĖą▓ą║ąĖ. ąĪąĖą┤ąĖčłčī ą┐ąŠč鹊ą╝ čéčŗčēčā ą╗ąĄčé (1-2 ą╝ąĖąĮčāčéčŗ) ąČą┤ąĄčłčī ą┐ąŠą║ą░ ąŠąĮąŠ ąŠą┤ąĮčā ą║ą░čĆčéąĖąĮą║čā ą▓čŗčĆąĖčüąŠą▓čŗą▓ą░ąĄčé ą▓ą╝ąĄčüč鹊 10-15 čüąĄą║čāąĮą┤ ąĮą░ ą┤čĆčāą│ąĖčģ ą╝ąŠą┤ąĄą╗čÅčģ.┬ĀąÜ č鹊ą╝čā ąČąĄ ą░ą▓č鹊čĆčŗ - ą┤ąĄą╝ąŠąĮčŗ, ąĘą░ą┐čĆąĄčéąĖą╗ąĖ čüąĖčüčīą║ąĖ čĆąĖčüąŠą▓ą░čéčī ą▓ Flux.Dev, ąĖą╝ čÅą▓ąĮąŠ ą┤ąŠčĆąŠą│ą░ ą▓ ą░ą┤ ąĘą░ čéą░ą║ąŠąĄ ))) ąźąŠčéčÅ ą╝ąŠąČąĄčé čü čüąĖčüčīą║ą░ą╝ąĖ ą┤ąĖčäčäčāąĘąĄčĆ-ą╝ąŠą┤ąĄą╗čī ą▓ąĄčüąĖą╗ą░ ą▒čŗ 32ą│ą▒ ąĖ čĆą░ą▒ąŠčéą░ą╗ą░ ą▒čŗ č鹊ą╗čīą║ąŠ ąĮą░ 5090, ąĮčā č鹊ą│ą┤ą░ ą▓ čüą░ą╝čŗą╣ čĆą░ąĘ ą▒čŗą╗ąŠ ą▒čŗ┬Ā

|

|

ąØą░ čüą░ą╣č鹥 c 11.06.2009

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 79

ąźčāčüčé ąŻą║čĆą░ąĖąĮą░

| ą¤ąŠčÅą▓ąĖą╗ąĖčüčī ą┐ąĄčĆą▓čŗąĄ č鹥čüčéčŗ ą▓ąĖą┤ąĄąŠą║ą░čĆčé RTX 50 ą▒ąĄąĘ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ DLSS. ą×ąĮąĖ ąŠą║ą░ąĘą░ą╗ąĖčüčī ąĮą░ 15ŌĆō20% ą▒čŗčüčéčĆąĄąĄ RTX 40: RTX 5090 vs RTX 4090 = +15% RTX 5080 vs RTX 4080 = +15% RTX 5070 Ti vs RTX 4070 Ti = +20% RTX 5070 vs RTX 4070 = +20% ąÉ čĆą░ąĘą│ąŠą▓ąŠčĆąŠą▓-č鹊 ą▒čŗą╗ąŠ |

|

ąØą░ čüą░ą╣č鹥 c 19.04.2019

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 558

| ą”ąĖčéą░čéą░ ElvisSuperStar: ą¤ąŠčÅą▓ąĖą╗ąĖčüčī ą┐ąĄčĆą▓čŗąĄ č鹥čüčéčŗ ą▓ąĖą┤ąĄąŠą║ą░čĆčé RTX 50 ą▒ąĄąĘ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ DLSS. ą×ąĮąĖ ąŠą║ą░ąĘą░ą╗ąĖčüčī ąĮą░ 15ŌĆō20% ą▒čŗčüčéčĆąĄąĄ RTX 40: RTX 5090 vs RTX 4090 = +15% RTX 5080 vs RTX 4080 = +15% RTX 5070 Ti vs RTX 4070 Ti = +20% RTX 5070 vs RTX 4070 = +20% ąÉ čĆą░ąĘą│ąŠą▓ąŠčĆąŠą▓-č鹊 ą▒čŗą╗ąŠ čéą░ą║ 4070čéąĖ čüčāą┐ąĄčĆ ą╗čāčćčłąĄ ą║čāą┐ąĖčéčī č湥ą╝ 5070čéąĖ? |

|

ąØą░ čüą░ą╣č鹥 c 11.06.2009

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 79

ąźčāčüčé ąŻą║čĆą░ąĖąĮą░

| ą”ąĖčéą░čéą░ shafxat: ą”ąĖčéą░čéą░ ElvisSuperStar: ą¤ąŠčÅą▓ąĖą╗ąĖčüčī ą┐ąĄčĆą▓čŗąĄ č鹥čüčéčŗ ą▓ąĖą┤ąĄąŠą║ą░čĆčé RTX 50 ą▒ąĄąĘ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ DLSS. ą×ąĮąĖ ąŠą║ą░ąĘą░ą╗ąĖčüčī ąĮą░ 15ŌĆō20% ą▒čŗčüčéčĆąĄąĄ RTX 40: RTX 5090 vs RTX 4090 = +15% RTX 5080 vs RTX 4080 = +15% RTX 5070 Ti vs RTX 4070 Ti = +20% RTX 5070 vs RTX 4070 = +20% ąÉ čĆą░ąĘą│ąŠą▓ąŠčĆąŠą▓-č鹊 ą▒čŗą╗ąŠ čéą░ą║ 4070čéąĖ čüčāą┐ąĄčĆ ą╗čāčćčłąĄ ą║čāą┐ąĖčéčī č湥ą╝ 5070čéąĖ? ąŚą░č湥ą╝ č鹥ą▒ąĄ 4070čéąĖ? ąĄčüą╗ąĖ ą▓čŗčłą╗ą░ ąĮąŠą▓ą░čÅ 5070čéąĖ? ąĄčüą╗ąĖ ą║ą░čĆč鹊čćą║ąĖ ąĮąĄčé č鹊 ą▒ąĄčĆąĖ ąĮąŠą▓čāčÄ, ąĄčüą╗ąĖ 4070 čéąĖ ąĄčüčéčī č鹊 ą╝ąŠąČąĮąŠ ą┐čĆąŠą┐čāčüą║ą░čéčī ą┐ąŠą║ąŠą╗ąĄąĮąĖąĄ |

|

ąØą░ čüą░ą╣č鹥 c 19.04.2019

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 558

| 4070čéąĖ čüčāą┐ąĄčĆ ą┐ąŠ ą╗čÄą▒ąŠą╝čā ą┤ąĄčłąĄą▓ą╗ąĄ 5070čéąĖ |

|

ąØą░ čüą░ą╣č鹥 c 11.06.2009

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 79

ąźčāčüčé ąŻą║čĆą░ąĖąĮą░

| ą”ąĖčéą░čéą░ shafxat: 4070čéąĖ čüčāą┐ąĄčĆ ą┐ąŠ ą╗čÄą▒ąŠą╝čā ą┤ąĄčłąĄą▓ą╗ąĄ 5070čéąĖ ąĮąĄ čüąŠą▓čüąĄą╝, 5000 čüąĄčĆąĖčÅ ą▓čŗčłą╗ą░ ą┤ąĄčłąĄą▓ą╗ąĄ┬Ā č湥ą╝ 4000, ąĮą░ą┤ąŠ čüą╝ąŠčéčĆąĄčéčī ą║ą░ą║ąĖąĄ ąĘą░ą║čāą┐ąŠčćąĮč¢ąĄ čåąĄąĮč¢ ą▒čŗą╗ąĖ čā ą┐čĆąŠą┤ą░ą▓čåąŠą▓, ąŠąĮ ąĮąĄ čüčéą░ąĮąĄčé č鹊čĆą│ąŠą▓ą░čéčī čüąĄą▒ąĄ ą▓ čāą▒čŗč鹊ą║, ą║ąŠą╝čā ąĮą░ą┤ąŠ ąŠąĮąĖ ą▓ą┐ą░čĆčÅčé 4070 ą┐ąŠ čåąĄąĮąĄ ą┤ąŠčĆąŠąČąĄ č湥ą╝ 5070, čćč鹊-ą▒čŗ ąŠčéą▒ąĖčéčī ąĘą░čéčĆą░čéčŗ |

|

ąØą░ čüą░ą╣č鹥 c 24.05.2009

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 10347

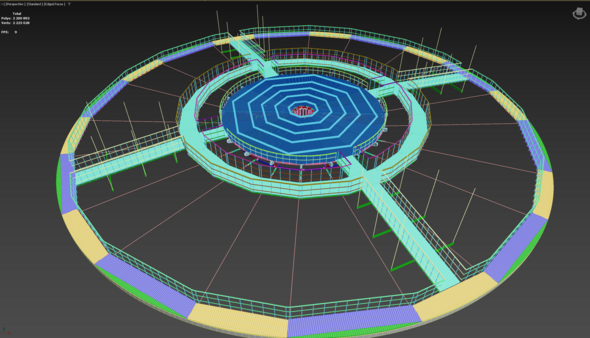

| ą”ąĖčéą░čéą░ ElvisSuperStar: ąĮąĄ čüąŠą▓čüąĄą╝, 5000 čüąĄčĆąĖčÅ ą▓čŗčłą╗ą░ ą┤ąĄčłąĄą▓ą╗ąĄ┬Ā č湥ą╝ 4000, ąĮą░ą┤ąŠ čüą╝ąŠčéčĆąĄčéčī ą║ą░ą║ąĖąĄ ąĘą░ą║čāą┐ąŠčćąĮč¢ąĄ čåąĄąĮč¢ ą▒čŗą╗ąĖ čā ą┐čĆąŠą┤ą░ą▓čåąŠą▓, ąŠąĮ ąĮąĄ čüčéą░ąĮąĄčé č鹊čĆą│ąŠą▓ą░čéčī čüąĄą▒ąĄ ą▓ čāą▒čŗč鹊ą║, ą║ąŠą╝čā ąĮą░ą┤ąŠ ąŠąĮąĖ ą▓ą┐ą░čĆčÅčé 4070 ą┐ąŠ čåąĄąĮąĄ ą┤ąŠčĆąŠąČąĄ č湥ą╝ 5070, čćč鹊-ą▒čŗ ąŠčéą▒ąĖčéčī ąĘą░čéčĆą░čéčŗ ą» čüą▓ąŠčÄ ASUS 4070 Duo ą▓ąĘčÅą╗ ąĘą░ 700$ ą║ąŠą│ą┤ą░ ąŠąĮą░ č鹊ą╗čīą║ąŠ ą▓čŗčłą╗ą░. ąĪąĄą╣čćą░čü MSRP čåąĄąĮą░ ąĮą░ 5070 - 550$ + ą▓ąĄąĮą┤ąŠčĆ ąĮą░ą║ąĖąĮąĄčé + ą┐ąŠčüčéą░ą▓čēąĖą║ ą▓ čüčĆąĄą┤ąĮąĄą╝ 25%. ąÜą░ą║ ą╝ąĖąĮąĖą╝čāą╝ ą▒čāą┤ąĄčé čéą░ą║ ąČąĄ 700$, ą░ č鹊 ąĖ ą┤ąŠčĆąŠąČąĄ, čāčćąĖčéčŗą▓ą░čÅ čćč鹊 ąĮą░ 4070 čåąĄąĮčŗ ąĮąĄ čüąĖą╗čīąĮąŠ ąĮąĖąČąĄ, č湥ą╝ ą┐čĆąĖ ą▓čŗčģąŠą┤ąĄ. ą”ąĖčéą░čéą░ ElvisSuperStar: čÅ ąĮą░ 4090 čåąĄą╗čŗą╣ čüčéą░ą┤ąĖąŠąĮ čģąŠą║ąĄą╣ąĮčŗą╣ čü ąĘą░ą░ąĮą╝ąĖčĆąŠą▓ą░ąĮąĮčŗą╝ąĖ ąĘčĆąĖč鹥ą╗čÅą╝ąĖ┬Ā ąĘą░ą▒ą░čåą░ą╗, ąĘą░ąĮčÅą╗ąŠ ą▓ąĖą┤ąĄąŠą┐ą░ą╝čÅčéąĖ č湥čé čéąĖą┐ą░ 14 ą│ąĖą│ +- https://www.behance.net/gallery/213506315/Hockey-arena

┬Ā ąŻ ąÆą░čü čüčåąĄąĮą░ ą▓ čĆą░ąĘčŗ ą╗ąĄą│č湥, ą║ą░ą║ ą┐ąŠ ą│ąĄąŠą╝ąĄčéčĆąĖąĖ čéą░ą║ ąĖ ą┐ąŠ č鹥ą║čüčéčāčĆą░ą╝. ąĢčēąĄ ąÆčŗ ąĮąĄ čāčćąĖčéčŗą▓ą░ąĄč鹥, čćč鹊 ą┐čĆąŠąĄą║čé ą┤ąĄą╗ą░ąĄčéčüčÅ ąĮą░ ą╗ąĄčéčā čü ą┤ąĖąĘą░ą╣ąĮąĄčĆąŠą╝. ą¤čĆąĖ čéą░ą║ąŠą╝ ą┐ąŠą┤čģąŠą┤ąĄ ą╝ąŠą│čāčé ą▓ąĖčüąĄčéčī ą╝čāčüąŠčĆąĮčŗąĄ ą╝ą░č鹥čĆąĖą░ą╗čŗ, ą╝ąŠąČąĄčé ą▒čŗčéčī čüą║čĆčŗčéą░čÅ ą│ąĄąŠą╝ąĄčéčĆąĖčÅ ąŠčé ą║ą░ą║ąŠą│ąŠ č鹊 ą▓ą░čĆąĖą░ąĮčéą░ ąĖ čé.ą┤. ąÜ ą┐čĆąĖą╝ąĄčĆčā, ą║čĆčāą┐ąĮčŗąĄ ą┐ą╗ą░ąĮčŗ ą║ąŠą╗ąŠčüąĮąĖą║ą░, ą║ąŠč鹊čĆčŗą╣ ąĮą░ čŹč鹊ą╝ čĆą░ą║čāčĆčüąĄ ąĮąĄ ąŠčüąŠą▒ąŠ ą▓ąĖą┤ąĄąĮ.

|

|

ąØą░ čüą░ą╣č鹥 c 04.06.2010

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 3828

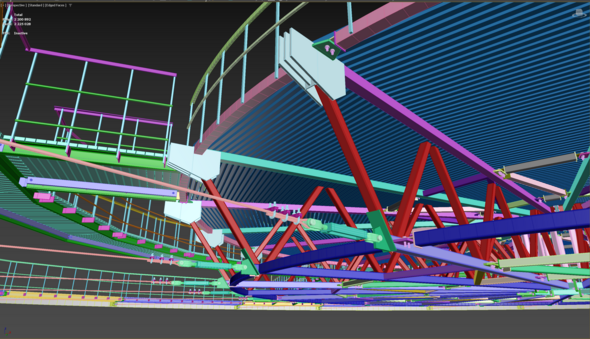

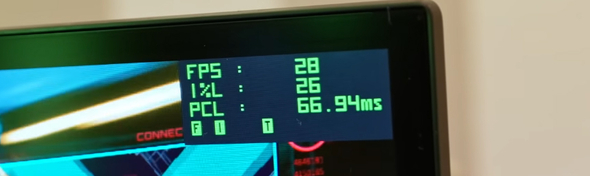

| ąóčāčé ą▓ąĖą┤ąĄąŠ 5090 ą▓┬ĀCyberpunk

(www.youtube.com/watch?v=lA8DphutMsY) ą▒ąĄąĘ DLSS ą▓ 4K ą┐ąŠą║ą░ąĘą░ą╗ąĖ┬ĀŌĆö 28 čäą┐čü. ąÆ č鹥čüčéą░čģ┬ĀGeekbench Vulkan

čéą░ą╝ čéą░ą║ą░čÅ ąČąĄ┬Ā čĆą░ąĘąĮąĖčåą░ čćč鹊 ąĖ ą┐čĆąĄą┤ą┐ąŠą╗ą░ą│ą░ą╗ąĖ čĆą░ąĮąĄąĄ┬Ā26ŌĆō37%. ą¤ąŠ ą▓ąĖąĘčā ą┐ąŠą║ą░ ąĮąĄ ą┐ąŠąĮčÅčéąĮąŠ. ą¤ąŠą╝ąĮčÄ ą┤ą░ą▓ąĮąŠ iray ą║ąŠą│ą┤ą░ ą▒čŗą╗, ąŠąĮ ąĮąĄ ą┐ąŠą┤ą┤ąĄčƹȹĖą▓ą░ą╗ ą┤ąŠą╗ą│ąŠ ą║ą░čĆčéčŗ 10-ąŠą╣ čüąĄčĆąĖąĖ Nvidia, ąĮčāąČąĮąŠ ą▒čŗą╗ąŠ ą║ą░ą║ąĖąĄ ą▒ąĖą╗ą┤čŗ čĆčāą║ąŠą┤ąĄą╗čīąĮčŗąĄ ą║ą░čćą░čéčī. ąØąŠ ą▓čĆąĄą╝čÅ čā ą┐čĆąŠą│ ąŠą▒ąĮąŠą▓ąĖčéčüčÅ ąĄčüčéčī. Nvidia ą╗ąĖą┤ąĄčĆ, ą║ą░čĆčéčŗ ąŠąĮą░ ą┐čĆąĄąĘąĄąĮčéčāąĄčé č鹥ą┐ąĄčĆčī čĆą░ąĘ ą▓ 2.5 ą│ąŠą┤ą░, ą╝ąŠąČąĄčé ąĮą░ 3-čģą╗ąĄčéą║čā ą┐ąĄčĆąĄą╣ą┤čæčé, čéą░ą║ čćč鹊 50-ą░čÅ čü ąĮą░ą╝ąĖ ąĮą░ą┤ąŠą╗ą│ąŠ. ąÜąŠą╝čā ąĮčāąČąĮą░ 40 čüąĄčĆąĖčÅ, č鹊 ą▒ąĄčĆąĖč鹥, ą┐ąŠč鹊ą╝ ąĮąĄ ą▒čāą┤ąĄčé, Nvidia ąĖąĘą▒ą░ą▓ą╗čÅąĄčéčüčÅ ąŠčé ąĘą░ą┐ą░čüąŠą▓ RTX 40, čĆą░čüą┐čĆąŠą┤ą░čÄčéčüčÅ ąŠčüčéą░čéą║ąĖ. ą”ąĄąĮą░ ąĮą░ 50 ą▒čāą┤ąĄčé ą▓čŗčłąĄ, čģąŠčéčÅ ą▒čŗ ąĖąĘ-ąĘą░ ąĮą░čćą░ą╗čīąĮąŠą│ąŠ ą┤ąĄčäąĖčåąĖčéą░.

|

|

ąØą░ čüą░ą╣č鹥 c 28.01.2020

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 109

| ą» ą║čüčéą░čéąĖ čüąŠą▓čüąĄą╝ ąĮąĄ ą┐ąŠąĮąĖą╝ą░čÄ čé菹╣ą║ąŠą▓ ą┐čĆąŠ č鹊, čćč鹊 ą┐čĆąĖ 4ą║ ąĮąĖąĘą║ąĖąĄ čäą┐čü čü čĆčéčģ ą╗čāčćą░ą╝ąĖ. ąĢčüčéčī ą▓ąŠąŠą▒čēąĄ ą┐ąŠąĮąĖą╝ą░ąĮąĖąĄ, čćč鹊 ą▓ čĆąĖą░ą╗čéą░ą╣ą╝ ąĖą┤ąĄčé ą┐čĆąŠčüč湥čé ąŠą│čĆąŠą╝ąĮčŗčģ čüčåąĄąĮ, čéą░ą║ ąĄčēąĄ ąĖ ą▓ 30čäą┐čü čü čéą░ą║ąĖą╝ ąŠą│čĆąŠą╝ąĮčŗą╝ čĆą░ąĘčĆąĄčłąĄąĮąĖąĄą╝. ąśą╗ąĖ ąĖąĘ-ąĘą░ ąĮčŗčéčīčÅ ąŠą│čĆąŠą╝ąĮąŠą│ąŠ ą║ąŠą╗-ą▓ą░ ą▒ą╗ąŠą│ąĄčĆąŠą▓, ą║ąŠč鹊čĆčŗąĄ čüą░ą╝ąĖ ąĮąĄ ąŠčüąŠą▒ąŠ č鹊 čĆą░ąĘą▒ąĖčĆą░čÄčéčüčÅ ą▓ č鹥ą╝ąĄ ąźčāą░ąĮą│ čéą░ą║ąŠą╣ "ą× ąĮąĄčé, ą×ą╗ąŠą╗ąŠčłąĖąĮ ąÆą░ąĮčÅ čüą┤ąĄą╗ą░ą╗ ą┐čĆąŠ ą╝ąĄąĮčÅ ą▓ąĖą┤ąŠčü, č鹥ą┐ąĄčĆčī ą▓ą╝ąĄčüč鹊 ą┐čĆąŠą║ą░čćą║ąĖ ą┤ą╗čüčü ą▒čāą┤čā čāą┐ąĖčĆą░čéčīčüčÅ ąĮą░ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī". ąŚą░čÄčł, ą┤ą░ą▓ąĮąŠ ą╗ąĖ ą┐ą░ą╗čīčåčŗ ą▓ąĄąĄčĆąŠą╝? |

|

ąØą░ čüą░ą╣č鹥 c 08.10.2011

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 746

Moscow

| ą”ąĖčéą░čéą░ Earanak: ąĢčēąĄ čÅ ąĮąĄ čāą┤ąĖą▓ąĖą╗čüčÅ čćč鹊 ąŠąĮąĖ čüčĆą░ą▓ąĮąĖą▓ą░ą╗ąĖ 4090 ąĖ 5090 ą▓ Flux.Dev, ąĮčā ą║ą░ąĮąĄčł...┬Āąōą┤ąĄ čüą░ą╝ ą┤ąĖčäčäčāąĘąĄčĆ ą▓ąĄčüąĖčé 23.5ą│ą▒ ąÜ ąĮąĄą╝čā ąĄčēąĄ ąĮą░ą┤ąŠ ą┤ąŠą║ą░čćąĖą▓ą░čéčī VAE ąĖ CLIP ąĮą░ 10ą│ą▒. ąś ą▓čüąĄ čŹč鹊 ą▓čŗąČąĖčĆą░ąĄčé ą▓ ąĮąŠą╗čī 24ą│ą▒ ą▓ąĖą┤ąĄąŠą┐ą░ą╝čÅčéąĖ ąĖ 40ą│ą▒ ąŠą┐ąĄčĆą░čéąĖą▓ą║ąĖ. ąĢčēčæ┬Āt5xxl_fp16 ą┐ą╗čÄčü 10ąōą▒. ąöą╗čÅ čéą░ą║ąŠą│ąŠ ą┤ąĄą╗ą░, ą▓ąĖą┤ąĖą╝ąŠ, ąĮčāąČąĮčŗ ą╝ąŠąĮčüčéčĆčŗ čéąĖą┐ą░ Tesla A100 ąĖą╗ąĖ H800. |

|

ąØą░ čüą░ą╣č鹥 c 24.06.2014

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 4563

| filatkin_m, ąĮčā ąĮą░ 4090 - Flux.Dev ą▓ ComfyUI - č鹥čĆą┐ąĖą╝ąŠ čĆą░ą▒ąŠčéą░ąĄčé. ąØčā ą┤ą░, ą╝ąĄą┤ą╗ąĄąĮąĮąĄą╣ čĆą░ąĘą░ 菹┤ą░ą║ ą▓ 2-3 č湥ą╝ SDXL ą╝ąŠą┤ąĄą╗ąĖ, ąĖ čüąČąĖčĆą░ąĄčé ą▓ 2.5-3 čĆą░ąĘą░ ą▒ąŠą╗čīčłąĄ čĆąĄčüčāčĆčüąŠą▓. ąØą░ą┐čĆąĖą╝ąĄčĆ ą┐ąŠą║ą░ ąŠąĮ čéą░ą╝ ą┐čŗčģčéąĖčé čü ą░ą┐čüą║ąĄą╣ą╗ąĖąĮą│ąŠą╝ č鹊 č乊ąĮąŠą╝ ążąŠč鹊賹Šą┐ ą┐ąŠą┤čéčāą┐ą╗ąĖą▓ą░ąĄčé, čā ą┤čĆčāą│ąĖčģ ą╝ąŠą┤ąĄą╗ąĄą╣ ą║ąŠč鹊čĆčŗąĄ ąĮą░ ą┐ąŠčĆčÅą┤ąŠą║ ą┐čĆąŠčēąĄ - čéą░ą║ąŠą│ąŠ ąĮąĄ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ą║ąŠąĮąĄčćąĮąŠ. |

|

ąØą░ čüą░ą╣č鹥 c 04.06.2010

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 3828

|

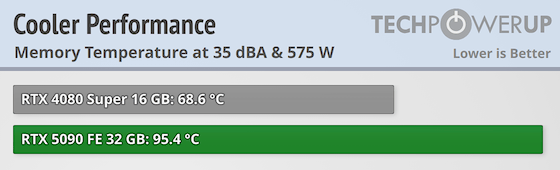

ąØąĄą║ąĖąĄ č鹥čüčéčŗ

ą▓┬ĀBlender, 34% ą▓ ą┐ąŠą╗čīąĘčā 5090. ąÆąŠ ą▓čüąĄčģ č鹥čüčéą░čģ ąĮčāąČąĮąŠ ą▒čāą┤ąĄčé ą┐ąŠčéčĆąĄą▒ą╗ąĄąĮąĖąĄ ą╝ąŠąĮąĖč鹊čĆąĖčéčī, čĆą░ąĘąĮąĖčåą░ 575 ąÆčé ą┐čĆąŠčéąĖą▓ 450 ąÆčé čā 4090.

|

|

ąØą░ čüą░ą╣č鹥 c 19.04.2019

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 558

| ą”ąĖčéą░čéą░ Rebate: ąØąĄą║ąĖąĄ č鹥čüčéčŗ

ą▓┬ĀBlender, 34% ą▓ ą┐ąŠą╗čīąĘčā 5090. ąÆąŠ ą▓čüąĄčģ č鹥čüčéą░čģ ąĮčāąČąĮąŠ ą▒čāą┤ąĄčé ą┐ąŠčéčĆąĄą▒ą╗ąĄąĮąĖąĄ ą╝ąŠąĮąĖč鹊čĆąĖčéčī, čĆą░ąĘąĮąĖčåą░ 575 ąÆčé ą┐čĆąŠčéąĖą▓ 450 ąÆčé čā 4090. ą▓ąŠčé č鹥ą╝ą░ ą╝ąŠčēąĮąŠčüčéąĖ čģąŠčéčī ą┐ąŠą┤ąĮčÅčéą░ . ąĮą░ 4080 ąĮčāąČąĮąŠ ą▒čŗą╗ąŠ ą▒ą╗ąŠą║ ą┐ąĖčéą░ąĮąĖčÅ 850 ą▓ą░čéčé . ą░ ąĮą░ 5080 č鹥ą┐ąĄčĆčī? ą║ąŠą│ą┤ą░ ą┐ąŠą╣ą┤čāčé ą┐čĆąŠą┤ą░ąČąĖ čāą▓ąĖą┤ąĖą╝ č鹥čüčéčŗ ąĖ ąŠą▒ąĘąŠčĆčŗ . ą░ ą┐ąŠą║ą░ čćč鹊 ą║ą░ą║ą░čÅ č鹊 ą╗ą░ąČą░ 5070 čüčĆą░ą▓ąĮąĖą▓ą░čÄčé čü 4070 . čģąŠčéčÅ ąĄčüčéčī ąĖ 4070 čüčāą┐ąĄčĆ ąĖ 4070 čéąĖ . 5070čéąĖ ą┐ąŠč湥ą╝čā č鹊 čü 4070čéąĖ čüčāą┐ąĄčĆ ąĮąĄ čüčĆą░ą▓ąĮąĖą▓ą░čÄčé . čģąŠčéčÅ ą┐ąŠ ąŠą▒čīąĄą╝čā ą┐ą░ą╝čÅčéąĖ ą╝ąŠąČąĮąŠ čüą║ą░ąĘą░čéčī čĆąŠą┤čüčéą▓ąĄąĮąĮąĖą║ąĖ |

|

ąØą░ čüą░ą╣č鹥 c 16.12.2010

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 1241

EU

| ą”ąĖčéą░čéą░ shafxat: ąĮą░ 4080 ąĮčāąČąĮąŠ ą▒čŗą╗ąŠ ą▒ą╗ąŠą║ ą┐ąĖčéą░ąĮąĖčÅ 850 ą▓ą░čéčé . ą░ ąĮą░ 5080 ą”ąĖčéą░čéą░ Rebate: 575 ąÆčé ąØąĄ ąĘąĮą░čÄ, ą║ą░ą║ čéą░ą╝ 5080, ąĮąŠ 5090 - ą║ąŠčĆąŠč湥, čü čāč湥č鹊ą╝ č鹊ą│ąŠ, čćč鹊 4080 ąČčĆąĄčé ą┤ąŠ 320 ąÆčé, ą┤ą╗čÅ 5090 ąĮčāąČąĮąŠ +250 ąĖąĖąĖ... čāčĆą░, ąĮą░čüčéą░ą╗ ą╝ąŠą╝ąĄąĮčé, ą║ąŠą│ą┤ą░ ą▓ ą║ąĖą╗ąŠą▓ą░čéčéąĮąĖą║ąĄ ąĮąĄ ą┐čĆąŠčüč鹊 ąĄčüčéčī čüą╝čŗčüą╗, ąĄą│ąŠ čģą▓ą░čéą░ąĄčé ą┐ąŠčćčéąĖ ą▓ą┐čĆąĖčéčŗą║ ┬Ā ┬Ā ąÜąĖą▒ąĄčĆčüąĄą║čüčāą░ą╗čŗ ąĖ ąČąĄą╗ąĄąĘąŠą╗ąŠąČčåčŗ čüčéčĆąŠąĄą╝ ą▒ąĄą│čāčé ąĘą░ 1500-2000 ąÆčé (čü ąĘą░ą┤ąĄą╗ąŠą╝ ąĮą░ ą▒čāą┤čāčēąĄąĄ, ą║ą░ą║ ąŠąĮąĖ ą╗čÄą▒čÅčé) 5080, ą▓ąĄčĆąŠčÅčéąĮąŠ, ą▒čāą┤ąĄčé ą║čāčłą×čéčī 400+. ąöą╗čÅ čüąĄą▒čÅ čĆą░čüčüą╝ą░čéčĆąĖą▓ą░čÄ ąĮąĄ ą▒ąŠą╗ąĄąĄ č湥ą╝ 5070 čéąĖčüčāą┐ąĄčĆ, ąĮąŠ ą▓čéą░ą╣ąĮąĄ ąČą┤čā čāą┤ą░čĆą░ ą▓ ą┐čüąĖąĮčā ą║čāčĆčéą║čā ąŠčé Intel┬Ā - B580 ąŠč湥ąĮčī, ąŠč湥ąĮčī čģąŠčĆąŠčłą░. ąĢčüą╗ąĖ čüą┤ąĄą╗ą░čÄčé ą▓ 2 čĆą░ąĘą░ ą▒čŗčüčéčĆąĄąĄ ąĘą░ ą▓ 2 čĆą░ąĘą░ ą▒ąŠą╗čīčłąĄ ą┤ąĄąĮąĄą│ - ą┐ąŠčĆą▓čāčé čĆčŗąĮąŠą║. |

|

ąØą░ čüą░ą╣č鹥 c 24.06.2014

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 4563

| ąØčā ąĖ č湥 ą▓čüąĄ ą╝ąŠą╗čćą░čé... ąæąĄą│ąĖč鹥 ą┤ą░ą▓ą░ą╣č鹥 čüą╝ąŠčéčĆąĖč鹥 ąĮą░ ąŠą▒ąĘąŠčĆčŗ 5090 )) https://videocardz.com/195043/nvidia-geforce-rtx-5090-blackwell-graphics-cards-review-roundup ┬Ā ąöą╗čÅ ą╝ąĄąĮčÅ ąĮąĖą║ą░ą║ąĖčģ ąŠčéą║čĆčŗčéąĖą╣ ąĮąĄ čüą▓ąĄčĆčłąĖą╗ąŠčüčī, ą▓čüąĄ ą║ą░ą║ ąĖ ą┐čĆąŠą│ąĮąŠąĘąĖčĆąŠą▓ą░ą╗ čü ą┐ąĄčĆą▓ąŠą│ąŠ ąČąĄ ą┤ąĮčÅ ąĮą░ CES. ąÉ ąĮąĄ... ąÆąŠ... ąÆąŠčé čćč鹊 čāą┤ąĖą▓ąĖą╗ąŠ )) ą¤ąŠą╝ąĮąĖč鹥 ąČąĄ čćč鹊 ą▒čŗą╗ąŠ čü RTX 3090 ąĖ GDDR6X ? ąØčā... ą¤ąŠč鹊ą╝ ą▓ąĄąĮą┤ąŠčĆčŗ čĆą░čüč湥čģą╗ąĖą╗ąĖčüčī ąĖ ąĮą░čāčćąĖą╗ąĖčüčī ąŠčģą╗ą░ąČą┤ą░čéčī ą▓ąĖą┤ąĄąŠą┐ą░ą╝čÅčéčī. ąØąŠ čéčāčé ąČąĄ GDDR7, ąĖ čłąĖąĮą░ ąČąĄčüčéą║ą░čÅ ąĖ ą¤ąĪą¤ čāą╗ąĄč鹥ą╗ąŠ ą▓ ąĮąĄą▒ąĄčüą░. ąöą░ ? ą¤ąŠą╗čāčćąĖč鹥, čĆą░čüą┐ąĖčłąĖč鹥čüčī :

ąĀą░ąĘčāą╝ąĄąĄčéčüčÅ čüč鹊ąĖčé ąŠčéą╝ąĄčéąĖčéčī č鹊 čćč鹊 GDDR6X ąĮą░ čüą░ą╝ąŠą╝ ą┤ąĄą╗ąĄ ąŠą║ą░ąĘą░ą╗ąŠčüčī ąÜąĀąÉąÖąØąĢ ą▓čŗąĮąŠčüą╗ąĖą▓ąŠą╣ ą┐ą░ą╝čÅčéčīčÄ ąĖ čéą░ čćč鹊 ą│čĆąĄą╗ą░čüčī ą┤ąŠ 95-105 ą│čĆą░ą┤čāčüąŠą▓ ąĮą░ RTX 3000 - ą┤ąŠ čüąĖčģ ą┐ąŠčĆ čüąĄą▒čÅ čćčāą▓čüčéą▓čāąĄčé ą×ąÜ ąĖ ąĮąĖą║ą░ą║ąĖčģ ąĮąĖą│ą┤ąĄ, ąĮąĖ ąĮą░ ą║ą░ą║ąĖčģ ą║ą░ąĮą░ą╗ą░čģ ąĪąĄčĆą▓ąĖčü ą”ąĄąĮčéčĆąŠą▓ čÅ ąĮąĄ ą▓ąĖą┤ąĄą╗ ąČą░ą╗ąŠą▒ ąĮą░ ąĮąĄąĄ. ąóą░ą║ čćč鹊 ą║ą░ą║ ą▒čŗ ą┤ą░... ąōąŠčĆčÅčćą░čÅ ą┤ąŠ ą▒ąĄąĘčāą╝ąĖčÅ, ąĮąŠ ą┐čĆąŠą▒ą╗ąĄą╝ ąĮąŠą╗čī. ąĢčüą╗ąĖ GDDR7 ą▓čŗą╣ą┤ąĄčé čéą░ą║ąŠą╣ ąČąĄ - ąŠą║. ą¢ą░ą╗čī čćč鹊 ą▓čüčÅ ą▓ąĖą┤čÅčģą░ čüčāčłąĖčéčīčüčÅ, ą┐čŗčģčéąĖčé ąĖ ą▓čŗą┤ąĄą╗čÅąĄčé č鹊ąĮąĮčā č鹥ą┐ą╗ą░ - ąĮąŠ čģąŠčéčÅ ą▒čŗ ąĮąĄ ą┤ąŠčģąĮąĄčé. |

|

ąØą░ čüą░ą╣č鹥 c 04.06.2010

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 3828

| ą”ąĖčéą░čéą░ Earanak: ąØčā ąĖ č湥 ą▓čüąĄ ą╝ąŠą╗čćą░čé... ą¤ąŠč鹊ą╝čā čćč鹊 ąĮąĄ ąĮčāąČąĮą░čÅ ą▓ąĄčēčī, čü ąĮąĄąĮčāąČąĮąŠą╣ čåąĄąĮąŠą╣ ąĮą░ čüčéą░čĆč鹥, ą▓čŗą┤ą░čÄčēą░čÅ ą┐ąĄčĆč乊ą╝ąĄąĮčü ą▓ ą▒ąŠą╗čīčłąĖąĮčüčéą▓ąĄ čüą╗čāčćą░ąĄą▓ ąĘą░ čüč湥čé ą┐čĆąŠą┐ąŠčĆčåąĖąŠąĮą░ą╗čīąĮąŠą│ąŠ čāą▓ąĄą╗ąĖč湥ąĮąĖčÅ ą╝ąŠčēąĮąŠčüčéąĖ, ąĖą╝ąĄčÄčēąĄąĄ ąĮąĖčłąĄą▓ąŠąĄ čāąĮąĖą║ą░ą╗čīąĮąŠąĄ ą┤ąŠčüč鹊ąĖąĮčüčéą▓ąŠ ą▓ 32 ąōą▒. |

|

ąØą░ čüą░ą╣č鹥 c 24.05.2009

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 10347

| ąÆ čüąĄčéąĖ ą┐ąŠčÅą▓ąĖą╗ąĖčüčī ą┤ą░ąĮąĮčŗąĄ ąŠ ąĮąŠą▓ąŠą╣ ą┐čĆąŠč乥čüčüąĖąŠąĮą░ą╗čīąĮąŠą╣ ą▓ąĖą┤ąĄąŠą║ą░čĆč鹥 Nvidia RTX 6000 Blackwell čü ą▓ą┐ąĄčćą░čéą╗čÅčÄčēąĖą╝ąĖ 96 ąōąæ ą┐ą░ą╝čÅčéąĖ GDDR7 ąĖ 512-ą▒ąĖčéąĮąŠą╣ čłąĖąĮąŠą╣. ą×ą┤ąĮą░ą║ąŠ ąĄčæ 菹ĮąĄčĆą│ąŠą┐ąŠčéčĆąĄą▒ą╗ąĄąĮąĖąĄ ąĖ čåąĄąĮą░ ą▓ąŠąĘą╝ąŠąČąĮąŠ čāą┤ąĖą▓čÅčé ą┤ą░ąČąĄ ą┐čĆąŠč乥čüčüąĖąŠąĮą░ą╗ąŠą▓. ąÜąŠą╝ą┐ą░ąĮąĖčÅ Nvidia, ąĘą░ą▓ąĄčĆčłą░čÅ čĆą░ą▒ąŠčéčā ąĮą░ą┤ ąĖą│čĆąŠą▓ąŠą╣ RTX 5090, čüąŠčüčĆąĄą┤ąŠč鹊čćąĖą╗ą░čüčī ąĮą░ ąĮąŠą▓ąŠą╝ čäą╗ą░ą│ą╝ą░ąĮąĄ ą┤ą╗čÅ ą┐čĆąŠč乥čüčüąĖąŠąĮą░ą╗ąŠą▓ ŌĆö RTX 6000 Blackwell. ąĪąŠą│ą╗ą░čüąĮąŠ ą┤ą░ąĮąĮčŗą╝ Tom's Hardware, ą║ą░čĆčéą░ ą┐ąŠą╗čāčćąĖčé 96 ąōą▒ą░ą╣čé ą┐ą░ą╝čÅčéąĖ GDDR7 čü 512-ą▒ąĖčéąĮąŠą╣ čłąĖąĮąŠą╣. ąĀąĄčłąĄąĮąĖąĄ ąŠčĆąĖąĄąĮčéąĖčĆąŠą▓ą░ąĮąŠ ąĮą░ ąĘą░ą┤ą░čćąĖ ą▓ąĖąĘčāą░ą╗ąĖąĘą░čåąĖąĖ, 3D-ą╝ąŠą┤ąĄą╗ąĖčĆąŠą▓ą░ąĮąĖąĄ ąĖ ┬½ą╗čæą│ą║ąĖą╣┬╗ ąśąś. ą×ąČąĖą┤ą░ąĄčéčüčÅ, čćč鹊 Blackwell čüčéą░ąĮąĄčé ą║ą╗čÄč湥ą▓čŗą╝ ąĖąĮčüčéčĆčāą╝ąĄąĮč鹊ą╝ ą┤ą╗čÅ ąĖąĮą┤čāčüčéčĆąĖąĖ ą┤ąĖąĘą░ą╣ąĮą░ ąĖ čĆą░ąĘčĆą░ą▒ąŠčéą║ąĖ.┬Ā ąÆ ą┤ąĄą║ą░ą▒čĆąĄ ąŠą┤ąĖąĮ ąĖąĘ 菹║čüą┐ąŠčĆčéčæčĆąŠą▓ ąŠčéą┐čĆą░ą▓ąĖą╗ ą▓ ąśąĮą┤ąĖčÄ č湥čéčŗčĆąĄ č鹥čüč鹊ą▓čŗčģ ąŠą▒čĆą░ąĘčåą░ čü ą╝ą░čĆą║ąĖčĆąŠą▓ą║ąŠą╣ PG153, čćč鹊 ą▓ čåąĄą╗ąŠą╝ čģą░čĆą░ą║č鹥čĆąĮąŠ ą┤ą╗čÅ Nvidia. ą¤ąŠą╗čāčćą░č鹥ą╗ąĄą╝ ą▓čŗčüčéčāą┐ąĖą╗ą░ ą┤ąŠč湥čĆąĮčÅčÅ ą║ąŠą╝ą┐ą░ąĮąĖčÅ Nvidia Graphics Private Limited. ąŁč鹊 ą┐ąŠą┤čéą▓ąĄčƹȹ┤ą░ąĄčé, čćč鹊 ą║ąŠą╝ą┐ą░ąĮąĖčÅ, ąŠč湥ą▓ąĖą┤ąĮąŠ, ąĮą░ą╝ąĄčĆąĄąĮą░ ą┐čĆąŠč鹥čüčéąĖčĆąŠą▓ą░čéčī ąĮąŠą▓ąĖąĮą║čā ą┐ąĄčĆąĄą┤ čĆąĄą╗ąĖąĘąŠą╝. ą¤ąŠą║ą░ ąŠčäąĖčåąĖą░ą╗čīąĮąŠąĄ ąĮą░ąĘą▓ą░ąĮąĖąĄ ą║ą░čĆčéčŗ ąĮąĄ čĆą░čüą║čĆčŗą▓ą░ąĄčéčüčÅ, ąĮąŠ ąĖčüč鹊čćąĮąĖą║ąĖ čüą▓čÅąĘčŗą▓ą░čÄčé ąĄčæ čü ą╗ąĖąĮąĄą╣ą║ąŠą╣ RTX 6000 Blackwell Generation. ąöą╗čÅ ą┤ąŠčüčéąĖąČąĄąĮąĖčÅ 96 ąōą▒ą░ą╣čé ą┐ą░ą╝čÅčéąĖ Nvidia ąĖčüą┐ąŠą╗čīąĘčāąĄčé 32 ą╝ąĖą║čĆąŠčüčģąĄą╝čŗ GDDR7 ą┐ąŠ 24 ąōą▒ąĖčé ą║ą░ąČą┤ą░čÅ, čĆą░ąĘą╝ąĄčēčæąĮąĮčŗąĄ ą▓ čĆąĄąČąĖą╝ąĄ clamshell. ąŁč鹊 ą┐ąŠąĘą▓ąŠą╗čÅąĄčé čāą┤ą▓ąŠąĖčéčī ąŠą▒čŖčæą╝ ą▒ąĄąĘ ą┐ąŠč鹥čĆčī ą▓ ą┐čĆąŠą┐čāčüą║ąĮąŠą╣ čüą┐ąŠčüąŠą▒ąĮąŠčüčéąĖ, č鹊 ąĄčüčéčī ą┤ą▓ą░ čćąĖą┐ą░ ą▒čāą┤čāčé čĆą░ą▒ąŠčéą░čéčī č湥čĆąĄąĘ ąŠą┤ąĖąĮ 32-ą▒ąĖčéąĮčŗą╣ ą║ąŠąĮčéčĆąŠą╗ą╗ąĄčĆ, čĆą░ąĘą┤ąĄą╗čÅčÅ ą░ą┤čĆąĄčüąĮčāčÄ čłąĖąĮčā. ąóą░ą║ąĖą╝ ąŠą▒čĆą░ąĘąŠą╝, 512-ą▒ąĖčéąĮčŗą╣ ąĖąĮč鹥čĆč乥ą╣čü čüąŠčģčĆą░ąĮąĖčé čŹčäč乥ą║čéąĖą▓ąĮąŠčüčéčī, ąŠą▒ąĄčüą┐ąĄčćąĖą▓ ą▓čŗčüąŠą║čāčÄ čüą║ąŠčĆąŠčüčéčī ą┐ąĄčĆąĄą┤ą░čćąĖ ą┤ą░ąĮąĮčŗčģ. ą¦č鹊 ą║ą░čüą░ąĄčéčüčÅ ą╝ąŠčēąĮąŠčüčéąĖ ąĖ ąŠčģą╗ą░ąČą┤ąĄąĮąĖčÅ, č鹊 č鹊čćąĮčŗąĄ čģą░čĆą░ą║č鹥čĆąĖčüčéąĖą║ąĖ GPU Blackwell ąĮąĄ čĆą░čüą║čĆčŗčéčŗ, ąŠą┤ąĮą░ą║ąŠ ą░ąĮą░ą╗ąĖčéąĖą║ąĖ ą┐čĆąĄą┤ą┐ąŠą╗ą░ą│ą░čÄčé, čćč鹊 ą▓ąĖą┤ąĄąŠą║ą░čĆčéą░ ą┐čĆąĄą▓ąĘąŠą╣ą┤čæčé ąĖą│čĆąŠą▓ąŠą╣ GB202 ą▓ RTX 5090. ą×ąČąĖą┤ą░ąĄčéčüčÅ ą┤ąŠ 24 576 CUDA-čÅą┤ąĄčĆ (ą┐čĆąŠčéąĖą▓ 21 760 čā GeForce) ąĖ 192 ą╝čāą╗čīčéąĖą┐čĆąŠčåąĄčüčüąŠčĆąŠą▓. ą¤ąŠčéčĆąĄą▒ą╗ąĄąĮąĖąĄ 菹ĮąĄčĆą│ąĖąĖ ą┐čĆąĄą▓čŗčüąĖčé 300 ąÆčé, ą║ą░ą║ čā RTX 6000 Ada, čćč鹊, ą▓ąĄčĆąŠčÅčéąĮąŠ, ą┐ąŠčéčĆąĄą▒čāąĄčé čāčüąĖą╗ąĄąĮąĮąŠą╣ čüąĖčüč鹥ą╝čŗ ąŠčģą╗ą░ąČą┤ąĄąĮąĖčÅ. ąĪč鹊ąĖčé čüą║ą░ąĘą░čéčī, čćč鹊 96 ąōą▒ą░ą╣čé ą┐ą░ą╝čÅčéąĖ ąĖąĘą▒čŗč鹊čćąĮčŗ ą┤ą╗čÅ ą║ą╗ą░čüčüąĖč湥čüą║ąŠą│ąŠ CAD ąĖą╗ąĖ čĆąĄąĮą┤ąĄčĆąĖąĮą│ą░, ąĮąŠ ą║čĆąĖčéąĖčćąĮčŗ ą┤ą╗čÅ ąśąś-ąĘą░ą┤ą░čć. ą¤ąŠčŹč鹊ą╝čā Nvidia, ą▓ąĄčĆąŠčÅčéąĮąŠ, ą▓čŗą┐čāčüčéąĖčé ąŠčéą┤ąĄą╗čīąĮčāčÄ ą▓ąĄčĆčüąĖčÄ ą║ą░čĆčéčŗ ą┤ą╗čÅ ą╝ą░čłąĖąĮąĮąŠą│ąŠ ąŠą▒čāč湥ąĮąĖčÅ. ą×ąČąĖą┤ą░ąĄčéčüčÅ, čćč鹊 ą░ąĮąŠąĮčü čüąŠčüč鹊ąĖčéčüčÅ ąĮą░ Game Developers Conference (GDC) ą▓ ą╝ą░čĆč鹥 ą▓ ąĪą░ąĮ-ąźąŠčüąĄ ąĖą╗ąĖ ąĮą░ čüąŠą▒čüčéą▓ąĄąĮąĮąŠą╝ ą╝ąĄčĆąŠą┐čĆąĖčÅčéąĖąĖ GTC 2025 (17ŌĆō21 ą╝ą░čĆčéą░, ąĪą░ąĮ-ążčĆą░ąĮčåąĖčüą║ąŠ). https://overclockers.ru/blog/worldnews/show/204750/Nvidia-gotovit-moschnejshuju-videokartu-RTX-6000-Blackwell-s-96-GB-GDDR7 ----------------- ąĪ čéą░ą║ąŠą╣ čłčéčāą║ąŠą╣ ąĖ ą▓ ąōą¤ąŻ čĆąĄąĮą┤ąĄčĆ ą╝ąŠąČąĮąŠ čāčģąŠą┤ąĖčéčī. ąóąŠą╗čīą║ąŠ ą▓ąŠą┐čĆąŠčü čåąĄąĮčŗ. ąÆą┐ąŠą╗ąĮąĄ ą▓ąŠąĘą╝ąŠąČąĮąŠ ąĘą░ ąĄąĄ čüč鹊ąĖą╝ąŠčüčéčī ą╝ąŠąČąĮąŠ ą▒čāą┤ąĄčé čüč鹥ą║ ąĮąŠą┤ čüąŠą▒čĆą░čéčī ąĖ ą┐ąŠą╗čāčćąĖčéčī čéą░ą║čāčÄ ąČąĄ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī. ąÉ ą▓ąŠčé ą┤ą╗čÅ ą░ąĮčĆąĖą╗ą░ ą▓ąĄčüčīą╝ą░ ąĖąĮč鹥čĆąĄčüąĮąŠ. |

|

ąØą░ čüą░ą╣č鹥 c 09.12.2016

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 33

ąÜą░ąĘą░čģčüčéą░ąĮ ą│.ąŻčĆą░ą╗čīčüą║

|

ąĪč鹊ąĖčéčī ąŠąĮą░ (RTX 6000)ą▒čāą┤ąĄčé ą║ą░ą║ ą║čĆčŗą╗ąŠ ąŠčé ą▒ąŠąĖąĮą│ą░..ąØą░ą▓ąĄčĆąĮąŠ 10 ą╗ąĄčé ą┐čĆąĖą┤ąĄčéčüčÅ čĆąĄąĮą┤ąĄčĆąĖčéčī,čćč鹊ą▒čŗ ąŠą║čāą┐ąĖčéčī čüąĄą╣ čćčāą┤ąŠ.

|

|

ąØą░ čüą░ą╣č鹥 c 24.06.2014

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 4563

|

ąØčā ąĮą░ čüčéą░čĆč鹥 ą┐čĆąŠą┤ą░ąČ ąÉ6000 ąÉą╝ą┐ąĄčĆ, A6000 ąÉą┤ą░ čüč鹊ąĖą╗ąĖ ą┐ąŠ 10-12ą║ ą▒ą░ą║čüąŠą▓. ąóčāčé čüčéą░čĆčŗą╣ č鹥čģą┐čĆąŠčåąĄčüčü ąĖ čćąĖą┐ ąĮąĄ čüąĖą╗čīąĮąŠ č鹊ą╗čēąĄ 5090, ąĮčā 96ą│ą▒ ą┐ą░ą╝čÅčéąĖ... ą¤ąŠ ąĖą┤ąĄąĄ ąĮąĄ ą┤ąŠą╗ąČąĮą░ ą▒ąŠą╗čīčłąĄ 15ą║ ą▒ą░ą║čüąŠą▓ čüč鹊ąĖčéčī, čéą░ą║ čćč鹊 ąŠą║čāą┐ąĖčéčī ą┐ąŠ ąĖą┤ąĄąĄ ąĮąĄ ą┐čĆąŠą▒ą╗ąĄą╝ą░.

|

|

ąØą░ čüą░ą╣č鹥 c 24.05.2009

ąĪąŠąŠą▒čēąĄąĮąĖą╣: 10347

| Ivaner, čéą░ą║ ą▒ąĄčĆčāčé ąČąĄ ąĄąĄ ą┤ą╗čÅ ą┐čĆąŠąĄą║č鹊ą▓ ą│ą┤ąĄ ą┐ą╗ą░čéčÅčé ą║ą░ą║ ąĘą░ čåąĄą╗čŗą╣ ą▒ąŠąĖąĮą│. ą£ąĄąĮčÅ ą▒ąŠą╗čīčłčāčÄ ąĮą░ą┤ąĄąČą┤čā ą▓čüąĄą╗čÅąĄčé ą┐ąŠčÅą▓ą╗ąĄąĮąĖąĄ čéą░ą║ąĖčģ ą┐čĆąŠą┤čāą║č鹊ą▓ ąĮą░ ą┐ąŠčéčĆąĄą▒ąĖč鹥ą╗čīčüą║ąĖą╣ čĆčŗąĮąŠą║. ąöą░ ą┤ąŠčĆąŠą│ąŠ, ą┤ą░ čéą░ą║čāčÄ čüą╗ąŠąČąĮąŠ ą▒čāą┤ąĄčé ą║čāą┐ąĖčéčī, ąĮąŠ čüčāą│čāą▒ąŠ ą▓ č鹥ąŠčĆąĖąĖ, ą▓ąŠąĘą╝ąŠąČąĮąŠ ą┐ąŠčÅą▓ąĖčéčüčÅ ąĖąĮčüčéčĆčāą╝ąĄąĮčé ą┤ą╗čÅ čĆąĄčłąĄąĮąĖčÅ čéčÅąČąĄą╗čŗčģ ąĘą░ą┤ą░čć. ąÆąĄą┤čī čüąĄą╣čćą░čü ąĮą░ ą”ą¤ąŻ ą┐ąŠčüčćąĖčéą░čéčī ą╝ąŠąČąĮąŠ ą╗čÄą▒ąŠą╣ ą┐čĆąŠąĄą║čé. ąöą░ąČąĄ, ąĄčüą╗ąĖ ą┤ąĄą╗ą░čéčī ąĮąŠą│ą░ą╝ąĖ ąĖą╗ąĖ čĆąĄąĮą┤ąĄčĆąĖčéčī ą│ąŠčĆąŠą┤ ą▓ ąŠą┤ąĮąŠą╣ čüčåąĄąĮąĄ, ąĄčüčéčī čéčĆąĄą┤čĆąĖą┐ą┐ąĄčĆ ą┐čĆąŠ ą║čāą┤ą░ ą┤ą▓ą░ č鹥čĆą░ą▒ą░ą╣čéą░ ą×ąŚąŻ ą▓ąŠčéą║ąĮčāčéčī ą╝ąŠąČąĮąŠ. ąØąĄ čģą▓ą░čéą░ąĄčé čüą║ąŠčĆąŠčüčéąĖ, čĆąĄąĮą┤ąĄčĆ-č乥čĆą╝ą░ ąĖą╗ąĖ ą┤ąŠą╝ą░ čüč鹥ą║ ąĮąŠą┤. ąÉ čĆąĄąĮą┤ąĄčĆ ąĮą░ ąōą¤ąŻ č湥? 24 ąĮą░ ą│ąĄą╣ą╝ąĄčĆčüą║ąŠą╣ ąĖ 48 ąĮą░ ą┐čĆąŠ ą║ą░čĆč鹥, ą╝ą░ą╗ąŠ. |

|