–°–æ–∑–¥–∞–Ω–∏–µ 3–î –º–æ–¥–µ–ª–µ–π –ø—Ä–∏ –ø–æ–º–æ—â–∏ –Ω–µ–π—Ä–æ—Å–µ—Ç–µ–π. 3Ds Max + tydiffusion

–í —Å—Ç–∞—Ç—å–µ —Ä–∞—Å—Å–∫–∞–∑–∞–Ω–æ –∫–∞–∫ –ø–æ–ª—É—á–∏—Ç—å —Ç–∞–∫–∏–µ –º–æ–¥–µ–ª–∏ –ø—Ä–∏ –ø–æ–º–æ—â–∏ –Ω–µ–π—Ä–æ—Å–µ—Ç–µ–π:

–°—Ç–∞—Ç—å—è —è–≤–ª—è–µ—Ç—Å—è —Ä–µ–∑—É–ª—å—Ç–∞—Ç–æ–º –ª–∏—á–Ω—ã—Ö —ç–∫—Å–ø–µ—Ä–∏–º–µ–Ω—Ç–æ–≤, –∏ –ø–æ–º–æ—â–∏ 3–¥ —Å–æ–æ–±—â–µ—Å—Ç–≤–∞. –û–≥—Ä–æ–º–Ω–æ–µ —Å–ø–∞—Å–∏–±–æ –≤—Å–µ–º –ø—Ä–∏—á–∞—Å—Ç–Ω—ã–º.

–£–≤–µ–ª–∏—á–µ–Ω–∏–µ –∏–Ω—Ç–µ—Ä–µ—Å–∞ –∫ –≥–µ–Ω–µ—Ä–∞—Ü–∏–∏ –∫–æ–Ω—Ç—Ä–æ–ª–∏—Ä—É–µ–º–æ–≥–æ 3–¥ —É–≤–µ–ª–∏—á–∏–ª–æ—Å—å —Å–≤—è–∑–∏ —Å –≤—ã—Ö–æ–¥–æ–º tydiffusion - —Ä–∞—Å—à–∏—Ä–µ–Ω–∏—è –¥–ª—è 3ds max, –ø–æ–∑–≤–æ–ª—è—é—â–µ–µ –ø—Ä–æ—Å—Ç–æ –∏—Å–ø–æ–ª—å–∑–æ–≤–∞—Ç—å –Ω–µ–π—Ä–æ—Å–µ—Ç—å stable diffusion –≤–Ω—É—Ç—Ä–∏ –ø—Ä–æ–≥—Ä–∞–º–º—ã, –∏ —Å –≤–º–µ–Ω—è–µ–º—ã–º –∏–Ω—Ç–µ—Ä—Ñ–µ–π—Å–æ–º. –≠—Ç–æ –∫–ª—é—á–µ–≤–æ–π —Ñ–∞–∫—Ç–æ—Ä. –í—Å—ë, —á—Ç–æ —Å–ª–æ–∂–Ω–µ–µ 2 –º–∏–Ω—É—Ç –Ω–∞ –æ—Å–≤–æ–µ–Ω–∏–µ - –Ω–µ —É—Å–≤–∞–∏–≤–∞–µ—Ç—Å—è –ª—é–±–∏—Ç–µ–ª—è–º–∏, –∏ –ø—Ä–æ–¥–æ–ª–∂–∞—é—â–∏–º–∏.

–Ø –ø—Ä–æ–≤–µ–ª —Å–µ—Ä–∏—é —ç–∫—Å–ø–µ—Ä–∏–º–µ–Ω—Ç–æ–≤, –¥–ª—è –ø–æ–Ω–∏–º–∞–Ω–∏—è, –∫–∞–∫ —ç—Ç–æ —Ä–µ—à–µ–Ω–∏–µ –º–æ–∂–µ—Ç –±—ã—Ç—å –∏—Å–ø–æ–ª—å–∑–æ–≤–∞–Ω–æ –≤ —Ä–µ–∞–ª—å–Ω—ã—Ö –∑–∞–¥–∞—á–∞—Ö. –ú–µ–Ω—è, –≤ –ø–µ—Ä–≤—É—é –æ—á–µ—Ä–µ–¥—å, –∏–Ω—Ç–µ—Ä–µ—Å—É–µ—Ç –≥–µ–Ω–µ—Ä–∞—Ü–∏—è –º–æ–¥–µ–ª–µ–π –≤ –ø–æ–ª—É–∞–≤—Ç–æ–º–∞—Ç–∏—á–µ—Å–∫–æ–º —Ä–µ–∂–∏–º–µ. –≠—Ç–æ –ø–æ–∑–≤–æ–ª–∏—Ç –±—ã—Å—Ç—Ä–æ –≥–µ–Ω–µ—Ä–∏—Ä–æ–≤–∞—Ç—å –¥–µ–∫–æ—Ä/–¥–µ—Ç–∞–ª–∏ –≤ –∏–Ω—Ç–µ—Ä—å–µ—Ä–Ω—ã—Ö –∑–∞–¥–∞—á–∞—Ö, –¥—Ä–∞—Ñ—Ç –º–æ–¥–µ–ª–∏ –¥–ª—è –∫–æ–º–ø–æ–∑–∏—Ü–∏–π –≤ –º–µ–¥–∏–∞ –ø—Ä–æ–µ–∫—Ç–∞—Ö, –∏ "3–¥ –∑–∞–¥–Ω–∏–∫–∏" –¥–ª—è –ø—Ä–æ–¥—É–∫—Ç–æ–≤—ã—Ö –∑–∞–¥–∞—á (–º–∞—Ä–∫–µ—Ç–ø–ª–µ–π—Å—ã, –ø—Ä–æ–∏–∑–≤–æ–¥—Å—Ç–≤–µ–Ω–Ω–∏–∫–∏)

–°–æ—Ñ—Ç –∫–æ—Ç–æ—Ä—ã–π –Ω–µ–æ–±—Ö–æ–¥–∏–º –¥–ª—è —Ä–∞–±–æ—Ç—ã —Å –¥–∞–Ω–Ω—ã–º —Ä–µ—à–µ–Ω–∏–µ–º: 3ds max (2019-2025) –∏ –±–µ—Å–ø–ª–∞—Ç–Ω—ã–π –ø–ª–∞–≥–∏–Ω tydiffusion (—Å—É—â–µ—Å—Ç–≤—É–µ—Ç –∏ –ø–ª–∞—Ç–Ω–∞—è –≤–µ—Ä—Å–∏—è, –Ω–æ –¥–ª—è –ª–∏—á–Ω–æ–≥–æ –ø–æ–ª—å–∑–æ–≤–∞–Ω–∏—è –∑–∞ –≥–ª–∞–∑–∞ –∏ –±–µ—Å–ø–ª–∞—Ç–Ω–æ–π).

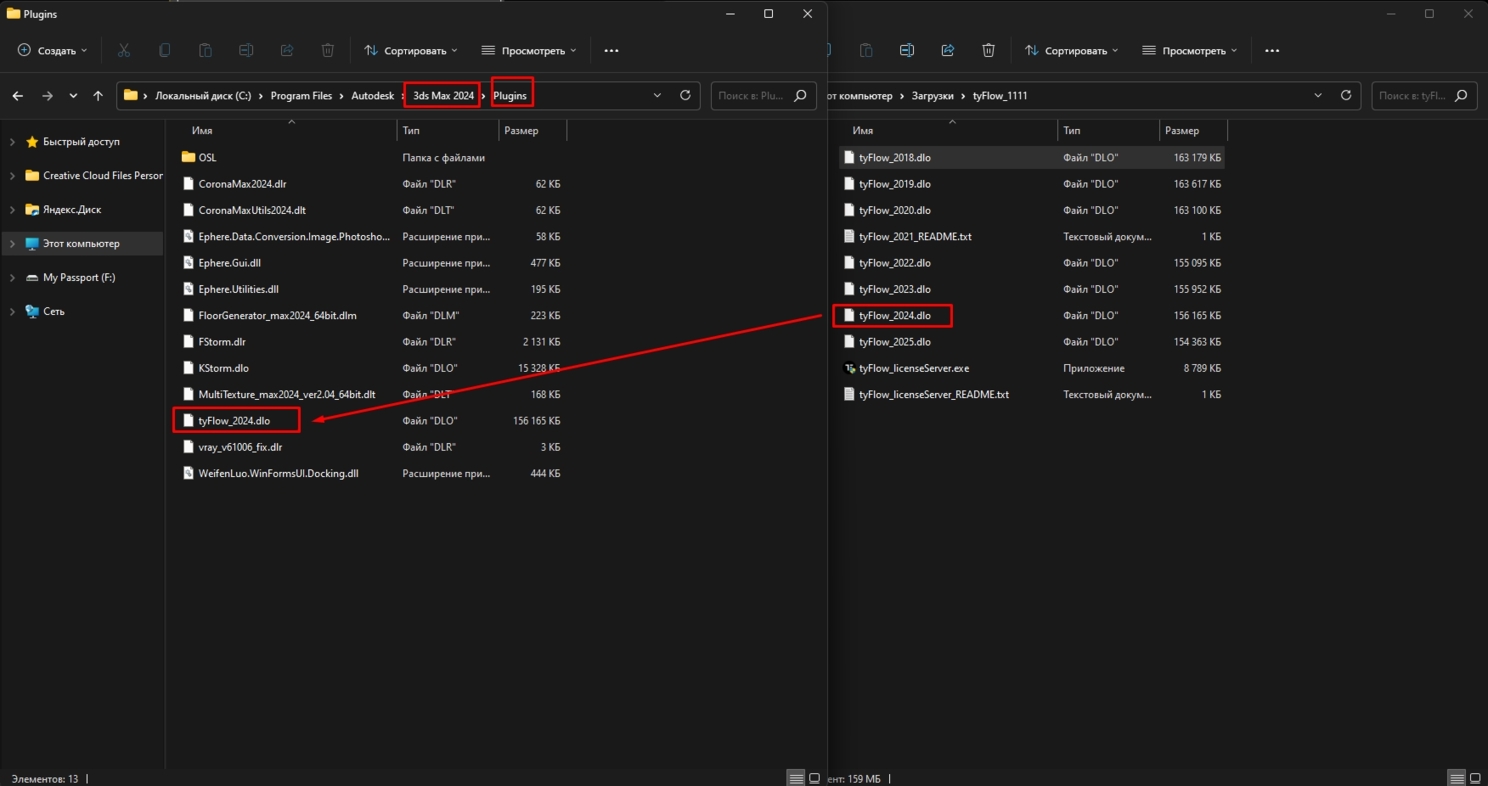

–£—Å—Ç–∞–Ω–æ–≤–∫–∞ tydiffusion –ø—Ä–æ–∏–∑–≤–æ–¥–∏—Ç—Å—è –ø—É—Ç–µ–º –ø–µ—Ä–µ—Ç–∞—Å–∫–∏–≤–∞–Ω–∏—è –≤–∞—à–µ–π –≤–µ—Ä—Å–∏–∏ –ø–ª–∞–≥–∏–Ω–∞ –≤ –ø–∞–ø–∫—É plugins –≤ 3ds max:

–ü—Ä–∏ –ø–µ—Ä–≤–æ–º –∑–∞–ø—É—Å–∫–µ –Ω–µ–æ–±—Ö–æ–¥–∏–º–æ —É—Å—Ç–∞–Ω–æ–≤–∏—Ç—å –≤—Å–µ –Ω–µ–æ–±—Ö–æ–¥–∏–º—ã–µ –∫–æ–º–ø–æ–Ω–µ–Ω—Ç—ã –¥–ª—è —Ä–∞–±–æ—Ç—ã –ø–ª–∞–≥–∏–Ω–∞. –í–Ω–∏–º–∞–Ω–∏–µ! –ö–æ–º–ø–æ–Ω–µ–Ω—Ç—ã –ª–µ–≥–∫–æ –º–æ–≥—É—Ç –∑–∞–Ω–∏–º–∞—Ç—å 20-30 –ì–± (–∏ –¥–æ–∫–∞—á–∏–≤–∞—Ç—å—Å—è –≤ –ø—Ä–æ—Ü–µ—Å—Å–µ –æ—Å–≤–æ–µ–Ω–∏—è), —Ç–∞–∫ —á—Ç–æ –≤—ã–±–µ—Ä–∏—Ç–µ –¥–∏—Å–∫ —Å –Ω—É–∂–Ω—ã–º –∫–æ–ª–∏—á–µ—Å—Ç–≤–æ–º –º–µ—Å—Ç–∞. –£—Å—Ç–∞–Ω–æ–≤–∫–∞, –∏ –µ–µ –æ–ø—Ü–∏–∏ –¥–æ—Å—Ç—É–ø–Ω—ã –≤ –ª–µ–≤–æ–π –≤–∫–ª–∞–¥–∫–µ –≤–Ω—É—Ç—Ä–∏ –ø–ª–∞–≥–∏–Ω–∞:

–í–Ω–∏–º–∞–Ω–∏–µ. –£–¥–æ—Å—Ç–æ–≤–µ—Ä—å—Ç–µ—Å—å —á—Ç–æ –¥–ª—è —Å–∫–∞—á–∏–≤–∞–Ω–∏—è –¥–æ–ø. –º–æ–¥—É–ª–µ–π (–ú–æ–¥–µ–ª–∏, LoRA, CtrlNet) –≤—ã–±—Ä–∞–Ω—ã –¥–∏—Å–∫–∏ —Å –¥–æ—Å—Ç–∞—Ç–æ—á–Ω—ã–º –∫–æ–ª–∏—á–µ—Å—Ç–≤–æ–º –º–µ—Å—Ç–∞. –¢–∞–º 2,5,8 –ì–± –∑–∞ —ç–ª–µ–º–µ–Ω—Ç —ç—Ç–æ –Ω–æ—Ä–º–∞.

–ü—Ä–æ—Ü–µ—Å—Å —É—Å—Ç–∞–Ω–æ–≤–∫–∏ –ª–µ–≥–∫–æ –º–æ–∂–µ—Ç –∑–∞–Ω—è—Ç—å —á–∞—Å—ã (–≤ –æ—Å–Ω–æ–≤–Ω–æ–º —ç—Ç–æ —Å–∫–∞—á–∏–≤–∞–Ω–∏–µ –¥–∞–Ω–Ω—ã—Ö), —Ç–∞–∫ —á—Ç–æ –∑–∞–ø–∞—Å–∏—Ç–µ—Å—å —Ç–µ—Ä–ø–µ–Ω–∏–µ–º.

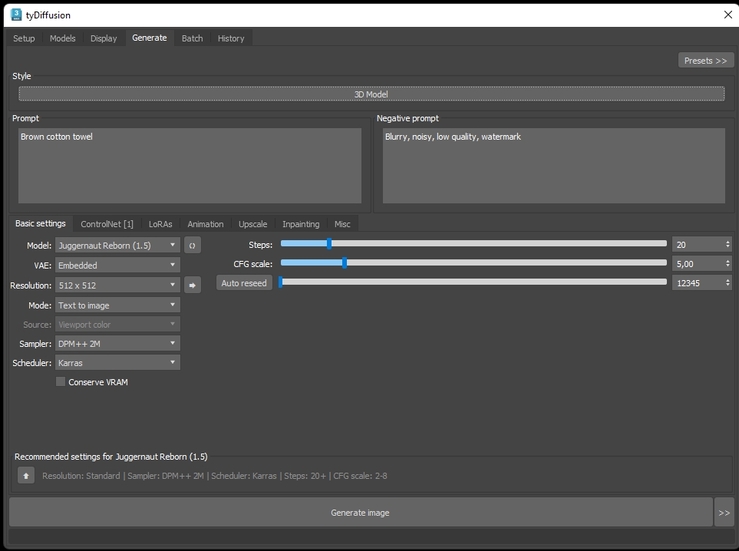

–í —ç—Ç–æ–π —Å—Ç–∞—Ç—å–µ —è –Ω–µ –≤–∏–∂—É —Å–º—ã—Å–ª–∞ —Ä–∞—Å–ø–∏—Å—ã–≤–∞—Ç—å –≤—Å–µ –≤–∫–ª–∞–¥–∫–∏ –∏ –≤–æ–∑–º–æ–∂–Ω–æ—Å—Ç–∏ tydiffusion. –ú–æ—è —Ü–µ–ª—å –ø–æ–∫–∞–∑–∞—Ç—å –∏–º–µ–Ω–Ω–æ –≥–µ–Ω–µ—Ä–∞—Ü–∏—é –∫–æ–Ω—Ç—Ä–æ–ª–∏—Ä—É–µ–º–æ–≥–æ 3–¥. –ù–æ –µ—Å–ª–∏ –∫–æ—Ä–æ—Ç–∫–æ - tydiffusion –ø–æ–∑–≤–æ–ª—è–µ—Ç –æ–±—Ä–∞—â–∞—Ç—å—Å—è –∫ –≤–æ–∑–º–æ–∂–Ω–æ—Å—Ç—è–º stable diffusion –Ω–µ–ø–æ—Å—Ä–µ–¥—Å—Ç–≤–µ–Ω–Ω–æ –∏–∑ —Å—Ä–µ–¥—ã 3ds max. –î–æ—Å—Ç—É–ø–µ–Ω –≤–µ—Å—å —Ñ—É–Ω–∫—Ü–∏–æ–Ω–∞–ª –¥–∞–Ω–Ω–æ–π –Ω–µ–π—Ä–æ—Å–µ—Ç–∏, –∏ –¥–æ–ø. –º–æ–¥—É–ª–µ–π.

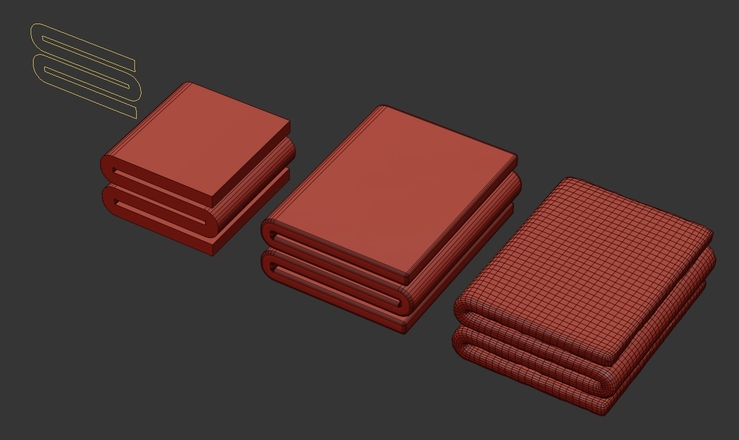

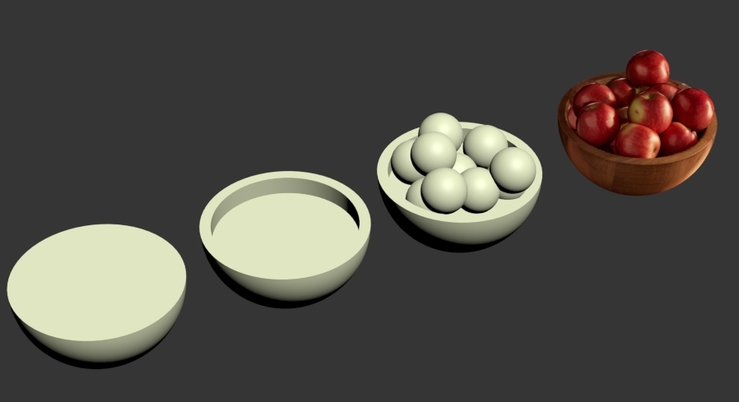

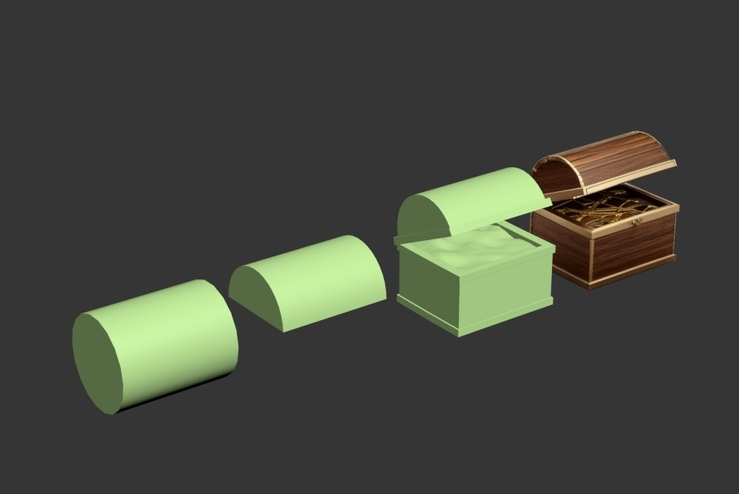

–ò—Ç–∞–∫, –º–æ—è —Ü–µ–ª—å —ç—Ç–æ –ø–æ–ª—É—á–µ–Ω–∏–µ –º–æ–¥–µ–ª–µ–π, —Å–¥–µ–ª–∞–Ω–Ω—ã—Ö –Ω–æ–≥–∞–º–∏, –∑–∞ —Ç—Ä–∏ –º–∏–Ω—É—Ç—ã, –±–µ–∑ –Ω–∞–≤—ã–∫–æ–≤.

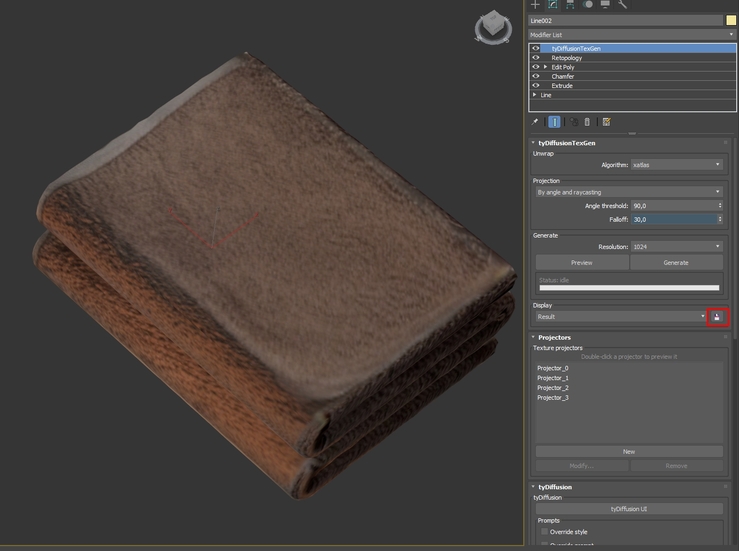

–ü–µ—Ä–≤—ã–π –ø—Ä–∏–º–µ—Ä - —Å–ª–æ–∂–µ–Ω–Ω–æ–µ –ø–æ–ª–æ—Ç–µ–Ω—Ü–µ. –î–µ–ª–∞–µ–º –≥–µ–æ–º–µ—Ç—Ä–∏—é:

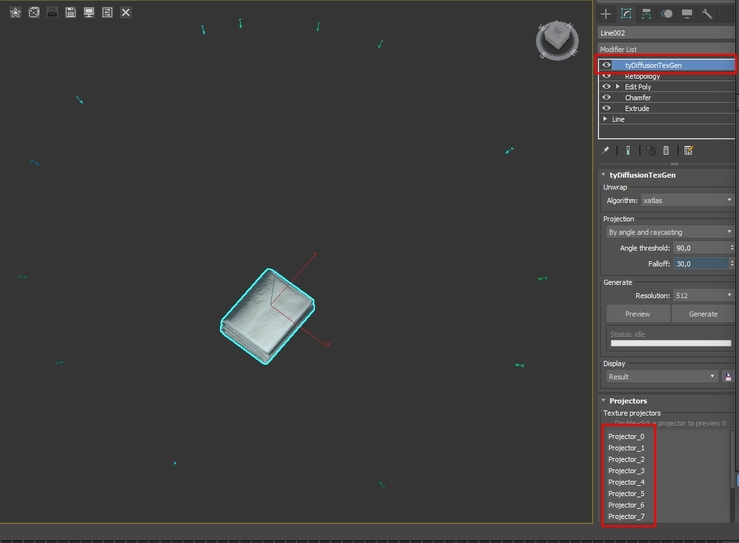

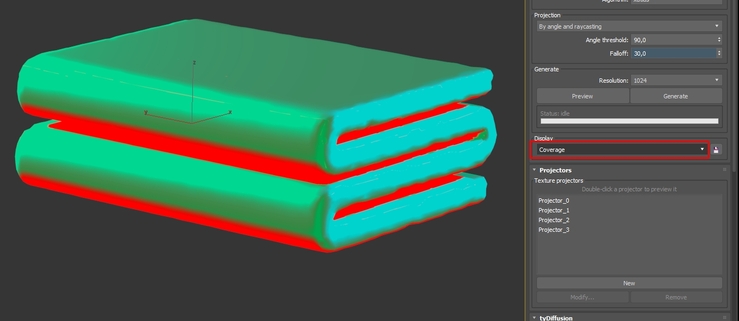

–ó–∞—Ç–µ–º –ø—Ä–∏–º–µ–Ω—è–µ–º –∫ –≥–µ–æ–º–µ—Ç—Ä–∏–∏ –º–æ–¥–∏—Ñ–∏–∫–∞—Ç–æ—Ä tydiffusiontexgen - —ç—Ç–æ —Å–∞–º–∞—è –≤–∞–∂–Ω–∞—è —á–∞—Å—Ç—å –ø—Ä–æ—Ü–µ—Å—Å–∞.

–ï—Å–ª–∏ –≥—Ä—É–±–æ, —Ç–æ –ø—Ä–æ—Ü–µ—Å—Å –æ—á–µ–Ω—å —Å—Ö–æ–∂ —Å –ø—Ä–æ—Ü–µ—Å—Å–æ–º 3–¥ —Å–∫–∞–Ω–∞ –ø–æ —Ñ–æ—Ç–æ, —Ç–æ–ª—å–∫–æ –≤–º–µ—Å—Ç–æ —Ñ–æ—Ç–æ –≤—ã—Å—Ç—É–ø–∞–µ—Ç —Å–µ—Ä–∏—è –≥–µ–Ω–µ—Ä–∞—Ü–∏–π –∏–∑–æ–±—Ä–∞–∂–µ–Ω–∏–π, —Å —É—á–∏—Ç—ã–≤–∞–Ω–∏–µ–º —Ç–æ–≥–æ, —á—Ç–æ —Å–≥–µ–Ω–µ—Ä–∏—Ä–æ–≤–∞–Ω–æ –≤ —Å–æ—Å–µ–¥–Ω–∏—Ö —Ç–æ—á–∫–∞—Ö. –ê —ç—Ç–æ, –∫–∞–∫ –ø–æ–¥—Ö–æ–¥, –¥–∞–µ—Ç –≤–æ–∑–º–æ–∂–Ω–æ—Å—Ç—å –ø–æ–ª—É—á–∞—Ç—å –Ω–µ –ø—Ä–æ—Ç–∏–≤–æ—Ä–µ—á–∞—â–∏–π –¥—Ä—É–≥-–¥—Ä—É–≥—É –∫–æ–Ω—Ç–µ–Ω—Ç –≤ —Ä–∞–º–∫–∞—Ö –º–æ–¥–µ–ª–∏/–ø—Ä–æ—Å—Ç—Ä–∞–Ω—Å—Ç–≤–∞.

–í–Ω—É—Ç—Ä–∏ –º–æ–¥–∏—Ñ–∏–∫–∞—Ç–æ—Ä–∞ –Ω–∞–º –¥–æ—Å—Ç—É–ø–Ω—ã –Ω–µ—Å–∫–æ–ª—å–∫–æ –≤–∏–¥–æ–≤ —Ä–∞–∑–≤–µ—Ä—Ç–∫–∏ –æ–±—ä–µ–∫—Ç–∞ (–ú–æ–∂–Ω–æ —Ç–∞–∫ –∂–µ –∏—Å–ø–æ–ª—å–∑–æ–≤–∞—Ç—å –∏ —Å–≤–æ—é —Ä–∞–∑–≤–µ—Ä—Ç–∫—É, —á—Ç–æ –ø–æ–∑–≤–æ–ª–∏—Ç –∫–æ–Ω—Ç—Ä–æ–ª–∏—Ä–æ–≤–∞—Ç—å —à–≤—ã –ø—Ä–∏ —Å–ª–æ–∂–Ω—ã—Ö –≥–µ–Ω–µ—Ä–∞—Ü–∏—è—Ö)

–ü—Ä–∏ –ø–æ–º–æ—â–∏ –∫–Ω–æ–ø–æ–∫ —Å–æ–∑–¥–∞–Ω–∏—è —Ç–æ—á–µ–∫ –¥–ª—è –ø—Ä–æ–µ—Ü–∏—Ä–æ–≤–∞–Ω–∏—è, –º—ã —Å–æ–∑–¥–∞–µ–º –Ω–µ—Å–∫–æ–ª—å–∫–æ —Ç–∞–∫–∏—Ö —Ç–æ—á–µ–∫, –∂–µ–ª–∞—Ç–µ–ª—å–Ω–æ —Å –≤–∑–∞–∏–º–Ω—ã–º –ø–µ—Ä–µ–∫—Ä—ã—Ç–∏–µ–º –ø—Ä–æ—Ü–µ–Ω—Ç–æ–≤ –Ω–∞ 30% (–æ–±—ã—á–Ω–æ —ç—Ç–æ 6-8 —Ç–æ—á–µ–∫ –ø–æ —Ä–∞–¥–∏—É—Å—É –≤–æ–∫—Ä—É–≥ –æ–±—ä–µ–∫—Ç–∞).¬Ý

–û—Ç —Å–µ–±—è –∑–∞–º–µ—á—É —á—Ç–æ –¥–ª—è —Ç–æ—á–µ–∫ –ø—Ä–æ–µ—Ü–∏—Ä–æ–≤–∞–Ω–∏—è –ª—É—á—à–µ –≤—ã–±–∏—Ä–∞—Ç—å "—Ö–∞—Ä–∞–∫—Ç–µ—Ä–Ω—ã–µ" —Ä–∞–∫—É—Ä—Å—ã, –≥–¥–µ —á–∏—Ç–∞–µ—Ç—Å—è —Ñ–æ—Ä–º–∞ –æ–±—ä–µ–∫—Ç–∞, —Ç–∞–∫ –∫–∞–∫ –ø–æ —É–º–æ–ª—á–∞–Ω–∏—é –∫–æ–Ω—Ç—Ä–æ–ª–∏—Ä—É—é—â–∏–º –º–æ–¥—É–ª–µ–º –¥–ª—è –≥–µ–Ω–µ—Ä–∞—Ü–∏–∏ —è–≤–ª—è–µ—Ç—Å—è –≥–µ–æ–º–µ—Ç—Ä–∏—è –æ–±—ä–µ–∫—Ç–∞, —Å—á–∏—Ç–∞–π –∫–∞—Ä—Ç–∞ –≥–ª—É–±–∏–Ω—ã. –ò –µ—Å–ª–∏ —Ç–æ—á–∫–∞ –±—É–¥–µ—Ç "–≤—è–ª–∞—è", —Ç–æ –Ω–µ–π—Ä–æ—Å–µ—Ç—å –Ω–∞—Ä–∏—Å—É–µ—Ç –Ω–∞ –Ω–µ–π –Ω–µ–≤–Ω—è—Ç–Ω–æ–µ –º—Ä–∞–∫–æ–±–µ—Å–∏–µ.

–ü–æ—Å–ª–µ —Å–æ–∑–¥–∞–Ω–∏—è —Ç–æ—á–µ–∫ –≤—ã –º–æ–∂–µ—Ç–µ —Å–≥–µ–Ω–µ—Ä–∏—Ä–æ–≤–∞—Ç—å –ø—Ä–µ–≤—å—é, –∏–ª–∏ —É–∂–µ —á–∏—Å—Ç–æ–≤–æ–π —Ä–µ–∑—É–ª—å—Ç–∞—Ç. –ü–ª–∞–≥–∏–Ω –ø–µ—Ä–µ–±–µ—Ä–µ—Ç –≤—Å–µ —Ç–æ—á–∫–∏, —Å–ø—Ä–æ–µ—Ü–∏—Ä—É–µ—Ç –Ω–∞ –Ω–∏—Ö —Ç–µ–∫—Å—Ç—É—Ä—É, –∏ —Å–æ–∑–¥–∞—Å—Ç –∏—Ç–æ–≥–æ–≤—ã–π —Ä–µ–∑—É–ª—å—Ç–∞—Ç, –∫–æ—Ç–æ—Ä—ã–π –±—É–¥–µ—Ç –ø–æ –≤–æ–∑–º–æ–∂–Ω–æ—Å—Ç–∏ —É—á–∏—Ç—ã–≤–∞—Ç—å –¥–∞–Ω–Ω—ã–µ —Å–æ –≤—Å–µ—Ö —Ä–∞–∫—É—Ä—Å–æ–≤. –ü—Ä–∏ —Å–æ–∑–¥–∞–Ω–∏–∏ –ø—Ä–µ–≤—å—é –≤—ã –º–æ–∂–µ—Ç–µ –≤—ã–±—Ä–∞—Ç—å —Ä–µ–∂–∏–º –æ—Ç–æ–±—Ä–∞–∂–µ–Ω–∏—è "–ø–æ–∫—Ä—ã—Ç–∏—è" –≥–¥–µ –≤–∞–º –ø–æ–¥—Å–≤–µ—Ç–∏—Ç —Ç–µ —É—á–∞—Å—Ç–∫–∏, –¥–ª—è –∫–æ—Ç–æ—Ä—ã—Ö –Ω–µ—Ç –¥–∞–Ω–Ω—ã—Ö –ø—Ä–∏ —Ç–µ–∫—É—â–∏—Ö —Ç–æ—á–∫–∞—Ö –ø—Ä–æ–µ—Ü–∏—Ä–æ–≤–∞–Ω–∏—è.

–ü—Ä–æ–º–ø—Ç. –í —Å–µ—Ä–∏–∏ —ç–∫—Å–ø–µ—Ä–∏–º–µ–Ω—Ç–æ–≤ —è –Ω–∞–º–µ—Ä–µ–Ω–Ω–æ –æ–ø–∏—Ä–∞–ª—Å—è —Ç–æ–ª—å–∫–æ –Ω–∞ –ø—Ä–∏–º–∏—Ç–∏–≤–Ω—ã–µ –ø—Ä–æ–º–ø—Ç—ã, —Ç–∫ –∑–∞–¥–∞—á–∞ —ç—Ç–æ –º–æ–ª–Ω–∏–µ–Ω–æ—Å–Ω–∞—è –≥–µ–Ω–µ—Ä–∞—Ü–∏—è –º–æ–¥–µ–ª–µ–π. –í–æ—Ç –ø—Ä–∏–º–µ—Ä –ø—Ä–æ–º–ø—Ç–∞ –¥–ª—è –ø–æ–ª–æ—Ç–µ–Ω—Ü–∞. –í–∞–∂–Ω–æ –ø–æ–Ω–∏–º–∞—Ç—å —á—Ç–æ –¥–ª—è –∫–∞–∂–¥–æ–π –º–æ–¥–µ–ª–∏ (–ò–ò) —Ä–µ–∑—É–ª—å—Ç–∞—Ç—ã –≥–µ–Ω–µ—Ä–∞—Ü–∏–∏ –±—É–¥—É—Ç —Å–≤–æ–∏, –Ω–æ —Å–º—ã—Å–ª–∞ —Ç—É—Ç –∏—Ö –æ–±—Å—É–∂–¥–∞—Ç—å —Å—á–∏—Ç–∞—é –±–µ—Å—Å–º—ã—Å–ª–µ–Ω–Ω—ã–º, —Ç–∞–∫ –∫–∞–∫ –æ–Ω–∏ –≤—Å–µ –≤—Ä–µ–º—è —Ä–∞–∑–≤–∏–≤–∞—é—Ç—Å—è –∏ –º–µ–Ω—è—é—Ç—Å—è. –ü—Ä–æ—Å—Ç–æ —É—á–∏—Ç—ã–≤–∞–π—Ç–µ —á—Ç–æ —Ä–∞–∑–Ω—ã–µ –º–æ–¥–µ–ª–∏ –Ω–∞—Ç–∞—Å–∫–∞–Ω—ã –Ω–∞ —Ä–∞–∑–Ω—ã–µ —Ç–∏–ø—ã –∏–∑–æ–±—Ä–∞–∂–µ–Ω–∏–π.

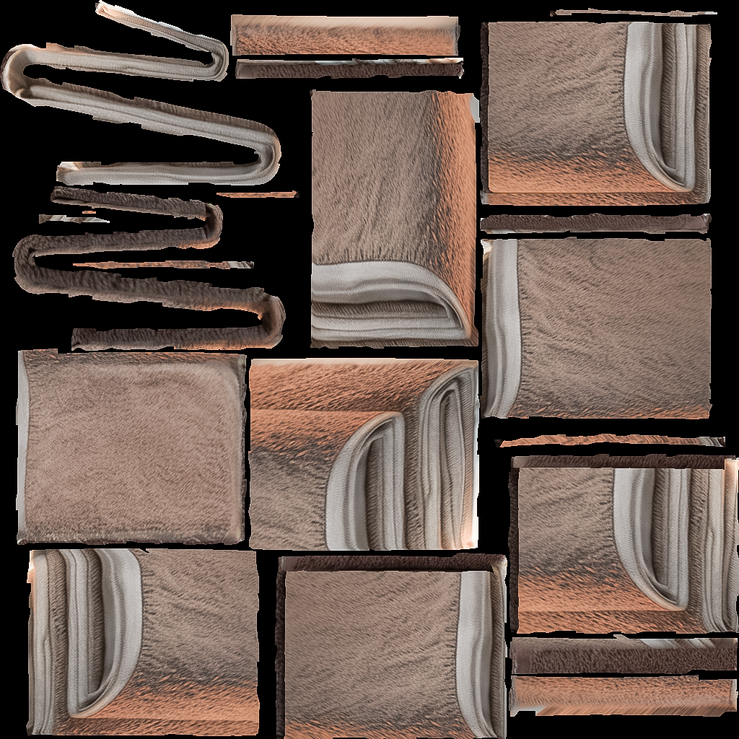

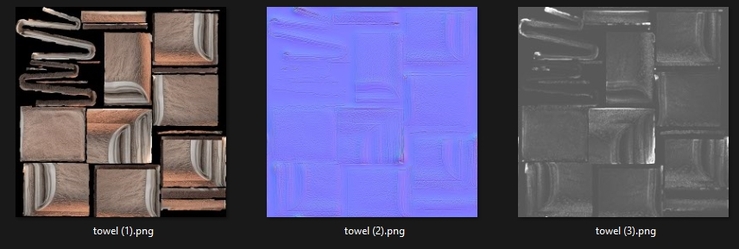

–ú–æ–¥–µ–ª—å –ø–æ—Å–ª–µ –≥–µ–Ω–µ—Ä–∞—Ü–∏–∏ —è –æ–±—ã—á–Ω–æ –∫–æ–ø–∏—Ä—É—é –ø—Ä–∏ –ø–æ–º–æ—â–∏ edit - snapshot. –ü–æ—Å–ª–µ —ç—Ç–æ–≥–æ –º–æ–¥–µ–ª—å –º–æ–∂–Ω–æ –∏—Å–ø–æ–ª—å–∑–æ–≤–∞—Ç—å —Ç–∞–∫, –∫–∞–∫ –≤–∞–º –Ω—É–∂–Ω–æ. –¢–µ–∫—Å—Ç—É—Ä—É, –ø–æ–ª—É—á–µ–Ω–Ω—É—é —Å–æ—Ö—Ä–∞–Ω–µ–Ω–∏–µ–º (—Å–º. –∫–∞—Ä—Ç–∏–Ω–∫—É –Ω–∏–∂–µ) –º–æ–∂–Ω–æ –∏—Å–ø–æ–ª—å–∑–æ–≤–∞—Ç—å –≤ –ª—é–±–æ–º —É–¥–æ–±–Ω–æ–º –¥–≤–∏–∂–∫–µ, —Å –º–∞—Ç–µ—Ä–∏–∞–ª–∞–º–∏ –∫–æ—Ç–æ—Ä—ã–µ –≤–∞–º –ø—Ä–∏–≤—ã—á–Ω—ã.

–°–∞–º–∏ —Ç–µ–∫—Å—Ç—É—Ä—ã –≤—ã–∑—ã–≤–∞—é—Ç –≤–æ–ø—Ä–æ—Å–∏–∫–∏, –Ω–æ –µ—Å–ª–∏ –≤—ã –±—É–¥–µ—Ç–µ –∏—Å–ø–æ–ª—å–∑–æ–≤–∞—Ç—å —Å–≤–æ—é —Ä–∞–∑–≤–µ—Ä—Ç–∫—É –ø—Ä–∏ –ø—Ä–æ–µ—Ü–∏—Ä–æ–≤–∞–Ω–∏–∏, —Ç–æ –º–æ–∂–Ω–æ –¥–∞–∂–µ –≥–æ–≤–æ—Ä–∏—Ç—å –æ –≤–æ–∑–º–æ–∂–Ω–æ—Å—Ç–∏ —Ä–µ–¥–∞–∫—Ç–∏—Ä–æ–≤–∞–Ω–∏—è —Ç–µ–∫—Å—Ç—É—Ä. –î–ª—è —Ç–æ–π —á–∞—Å—Ç–∏ –º–æ–¥–µ–ª–∏ —á—Ç–æ –Ω–µ –±—ã–ª–∞ "–ø–æ–∫—Ä—ã—Ç–∞" –ø—Ä–∏ –ø—Ä–æ–µ—Ü–∏—Ä–æ–≤–∞–Ω–∏–∏, —Ç–µ–∫—Å—Ç—É—Ä—ã –±—É–¥—É—Ç –Ω–∞–ª–æ–∂–µ–Ω—ã –º–∞–∫—Å–∏–º–∞–ª—å–Ω–æ –∫—Ä–∏–≤–æ.

–ü–æ–Ω—è—Ç–Ω–æ, —á—Ç–æ –¥–ª—è —É–ª—É—á—à–µ–Ω–∏—è —Ä–µ–∑—É–ª—å—Ç–∞—Ç–æ–≤ –Ω—É–∂–Ω–æ –≥–µ–Ω–µ—Ä–∏—Ä–æ–≤–∞—Ç—å –ø–∞–∫–µ—Ç –≤—Å–ø–æ–º–æ–≥–∞—Ç–µ–ª—å–Ω—ã—Ö —Ç–µ–∫—Å—Ç—É—Ä, –Ω–∞–ø—Ä–∏–º–µ—Ä, —á–µ—Ä–µ–∑ pixplant

–ß—Ç–æ –∏–º–µ–µ–º –≤ —Å—É—Ö–æ–º –æ—Å—Ç–∞—Ç–∫–µ? –í–æ–∑–º–æ–∂–Ω–æ—Å—Ç—å –ø–æ–ª—É—á–µ–Ω–∏—è 3–¥ –º–æ–¥–µ–ª–µ–π –¥–ª—è —Å—Ä–µ–¥–Ω–∏—Ö –∏ –¥–∞–ª—å–Ω–∏—Ö –ø–ª–∞–Ω–æ–≤, –¥–µ–∫–æ—Ä–∞, –¥–µ—Ç–∞–ª–µ–π –∏ –ø—Ä–æ—á. –ì–µ–Ω–µ—Ä–∞—Ü–∏—è —Ä–µ–∞–ª—å–Ω–æ –∑–∞–Ω–∏–º–∞–µ—Ç —Å–µ–∫—É–Ω–¥—ã –≤ —Ä–∞–∑—Ä–µ—à–µ–Ω–∏–∏ 512/1024, –∞ —ç—Ç–æ–≥–æ –≤–ø–æ–ª–Ω–µ —Ö–≤–∞—Ç–∏—Ç –¥–ª—è —Ä—É—Ç–∏–Ω—ã.

–ë–µ–∑—É—Å–ª–æ–≤–Ω–æ, —Å–ø–æ—Å–æ–± –∏–º–µ–µ—Ç –º–Ω–æ–≥–æ –æ–≥—Ä–∞–Ω–∏—á–µ–Ω–∏–π –∏ –Ω—é–∞–Ω—Å–æ–≤. –ù–æ —ç—Ç–æ —É–∂–µ –ø–æ–ª–Ω–æ—Ü–µ–Ω–Ω—ã–π –ø–æ–¥—Ö–æ–¥ –¥–ª—è –ø–æ—Ç–æ—á–Ω–æ–≥–æ –ø—Ä–æ–∏–∑–≤–æ–¥—Å—Ç–≤–∞ –º–æ–¥–µ–ª–µ–π, –∏–ª–∏, –µ–≥–æ —É—Å–∫–æ—Ä–µ–Ω–∏—è. –õ–∏—á–Ω–æ –¥–ª—è —Å–µ–±—è —è –≤–∏–∂—É –æ–≥—Ä–æ–º–Ω—ã–µ –≥–æ—Ä–∏–∑–æ–Ω—Ç—ã –≤ —Å–≤—è–∑–∫–µ —Å –ª–µ–ø–∫–æ–π –≤ zbrush, –∏–ª–∏ –¥–æ—Ä–∏—Å–æ–≤—ã–≤–∞–Ω–∏—è –≤ Substance painter.

–ù–æ –∏ –±–µ–∑ —ç—Ç–æ–≥–æ, –¥–ª—è —Ç–µ—Ö —É –∫–æ–≥–æ —Å–æ–≤—Å–µ–º —Ç—É–≥–æ —Å –º–æ–¥–µ–ª–ª–∏–Ω–≥–æ–º –∏ –º–∞—Ç–µ—Ä–∏–∞–ª–∞–º–∏, –ø–æ–ª—É—á–∞—Ç—å –ø–æ–¥–æ–±–Ω—ã–µ –º–æ–¥–µ–ª–∏ - –ø–æ–¥–∞—Ä–æ–∫. –û—Å–æ–±–µ–Ω–Ω–æ, –µ—Å–ª–∏ –º—ã –≥–æ–≤–æ—Ä–∏–º –æ –≥–µ–Ω–µ—Ä–∞—Ü–∏–∏ –ø–æ–¥ —Ä–∞–∫—É—Ä—Å, –≥–¥–µ –ø—Ä–æ–∂–µ–∫—Ç–æ—Ä–æ–≤ –º–æ–¥–µ—Ç –±—ã—Ç—å 2-3, —á–∏—Å—Ç–æ –ø–æ–¥ –ø–æ–ª–æ–≤–∏–Ω–∫—É –º–æ–¥–µ–ª–∏.¬Ý

–ù–∞–ø—Ä–∏–º–µ—Ä, —Å–¥–µ–ª–∞—Ç—å –Ω–∞ –∫—É—Ö–Ω—é –≤–∞–∑–æ—á–∫—É —Å —è–±–ª–æ–∫–∞–º–∏ –∑–∞–π–º–µ—Ç 2-3 –º–∏–Ω—É—Ç—ã.

–ò–ª–∏ –¥—Ä–∞—Ñ—Ç –∞—Å—Å–µ—Ç–∞, –¥–ª—è –ø–æ–Ω–∏–º–∞–Ω–∏—è —Ü–≤–µ—Ç–æ–≤ –∏–ª–∏ –∫–æ–º–ø–æ–∑–∏—Ü–∏–∏.¬Ý

–ü—Ä–∏—á–µ–º, —Å—Ç–∏–ª–µ–≤—ã–µ –∏–ª–∏ —Ü–≤–µ—Ç–æ–≤—ã–µ –≤–∞—Ä–∏–∞—Ü–∏–∏ –ø–æ–ª–Ω–æ—Å—Ç—å—é –ø–æ–¥ –≤–∞—à–∏–º –∫–æ–Ω—Ç—Ä–æ–ª–µ–º.

–ù–∞–¥–µ—é—Å—å –¥–∞–Ω–Ω–∞—è —Å—Ç–∞—Ç—å—è –ø–æ–º–æ–∂–µ—Ç –∫–æ–º—É-—Ç–æ —É–≤–∏–¥–µ—Ç—å –ø—Ä–∞–∫—Ç–∏—á–µ—Å–∫–æ–µ –ø—Ä–∏–º–µ–Ω–µ–Ω–∏–µ –Ω–µ–π—Ä–æ—Å–µ—Ç–µ–π –≤ —Å–≤–æ–µ–π —Ä–∞–±–æ—Ç–µ, –∞ –Ω–µ —Ç–æ–ª—å–∫–æ "–±–∞–ª–æ–≤—Å—Ç–≤–∞" –±–µ–∑ —Ä–µ–∑—É–ª—å—Ç–∞—Ç–∞.

–í—Å–µ–º –±–ª–∞–≥.