ąŻą╗čāčćčłą░ąĄą╝ 3D ą╗čÄą┤ąĄą╣ ąĮą░ čĆąĄąĮą┤ąĄčĆąĄ čü ą┐ąŠą╝ąŠčēčīčÄ ąĮąĄą╣čĆąŠčüąĄčéąĖ

ąźąŠčćčā ą┐ąŠą║ą░ąĘą░čéčī čüą┐ąŠčüąŠą▒, ą║ą░ą║ ąĖąĘ ąĮąĄą║čĆą░čüąĖą▓čŗčģ 3ą┤ ą╗čÄą┤ąĄą╣ ąĮą░ čĆąĄąĮą┤ąĄčĆąĄ čüą┤ąĄą╗ą░čéčī č乊č鹊čĆąĄą░ą╗ąĖčüčéąĖčćąĮčŗčģ, ą▒čāą║ą▓ą░ą╗čīąĮąŠ ą▓ ąĮąĄčüą║ąŠą╗čīą║ąŠ ą║ą╗ąĖą║ąŠą▓. ąĀąĄčćčī ą┐ąŠą╣ą┤čæčé ąŠ ąĮąĄą╣čĆąŠčüąĄčéąĖ Stable Diffusion (SD).

ąŁą║čüą┐ąĄčĆąĖą╝ąĄąĮčéąĖčĆąŠą▓ą░čéčī ą▒čāą┤ąĄą╝ ąĮą░ ą┐čĆąĖą╝ąĄčĆąĄ ąŠą┤ąĮąŠą╣ ąĖąĘ ą┐ąŠčüą╗ąĄą┤ąĮąĖčģ čĆą░ą▒ąŠčé ą▓ ą│ą░ą╗ąĄčĆąĄąĄ. ąØą░ ą╝ąŠą╝ąĄąĮčé ąĮą░ą┐ąĖčüą░ąĮąĖčÅ čüčéą░čéčīąĖ čĆą░ą▒ąŠčéą░ ąĘą░ąĮąĖą╝ą░ąĄčé ą│ąŠčĆčā 3ą┤ą┤ą┤, ąĮąŠ ąĖą╝ąĄąĄčé ą▒ąŠą╗čīčłąŠąĄ ą║ąŠą╗ąĖč湥čüčéą▓ąŠ ą║ąŠą╝ą╝ąĄąĮčéą░čĆąĖąĄą▓ ą║čĆąĖčéąĖą║čāčÄčēąĖčģ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą▓ ąĮąĄą╣ 3ą┤ ą╗čÄą┤ąĄą╣. ąÆčŗą│ą╗čÅą┤čÅčé ąŠąĮąĖ ąĖ ą┐čĆą░ą▓ą┤ą░ ąĮąĄ ąŠč湥ąĮčī čģąŠčĆąŠčłąŠ. ą¤ąŠą┐čĆąŠą▒čāąĄą╝ ąĖčüą┐čĆą░ą▓ąĖčéčī čŹč鹊čé ą╝ąŠą╝ąĄąĮčé.

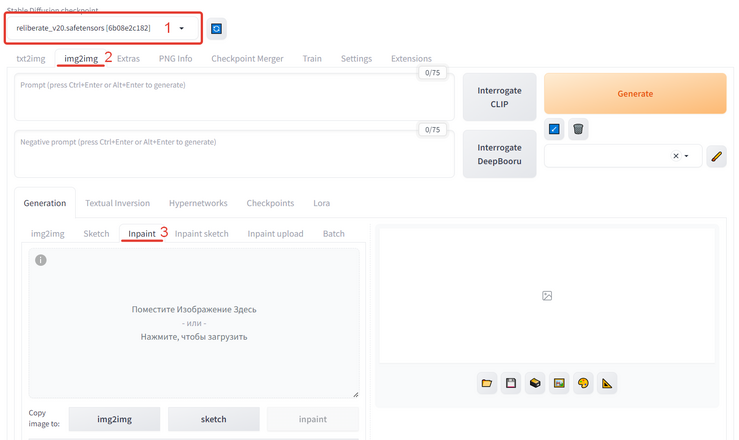

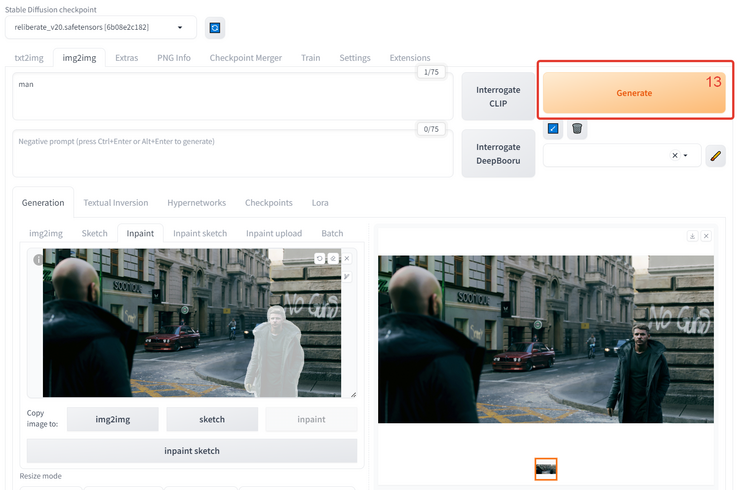

ą¤ąĄčĆą▓čŗą╝ ą┤ąĄą╗ąŠą╝ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ čāčüčéą░ąĮąŠą▓ąĖčéčī SD ąĮą░ čüą▓ąŠą╣ ą¤ąÜ. ą¤čĆąŠčåąĄčüčü čāčüčéą░ąĮąŠą▓ą║ąĖ ąŠą┐ąĖčüčŗą▓ą░čéčī ąĮąĄ ą▒čāą┤čā čé.ą║. ą▓ ąĖąĮč鹥čĆąĮąĄč鹥 ą┤ąŠčüčéą░č鹊čćąĮąŠ ą╝ąĮąŠą│ąŠ ąĖąĮč乊čĆą╝ą░čåąĖąĖ ąĮą░ čŹčéčā č鹥ą╝čā (ąĄčüą╗ąĖ ą▓čüčæ čéą░ą║ąĖ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ čüąŠąĘą┤ą░čéčī ąĖąĮčüčéčĆčāą║čåąĖčÄ ą┐ąŠ čāčüčéą░ąĮąŠą▓ą║ąĄ - ą┐ąĖčłąĖč鹥, ąĄčüą╗ąĖ ą╝ąĮąŠą│ąĖą╝ ą▒čāą┤ąĄčé ą┐ąŠą╗ąĄąĘąĮąŠ č鹊 ą┐ąŠčüčéą░čĆą░čÄčüčī čüą┤ąĄą╗ą░čéčī). ąöą╗čÅ ą│ąĄąĮąĄčĆą░čåąĖąĖ ą▒čāą┤ąĄą╝ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ą╝ąŠą┤ąĄą╗čī Reliberate 2.0 . ąĢčæ ąĮčāąČąĮąŠ čüąŠčģčĆą░ąĮąĖčéčī ą▓ ą┐ą░ą┐ą║ąĄ ":\Stable Diffusion\stable-diffusion-webui\models\Stable-diffusion". ąöą░ą╗ąĄąĄ ąĘą░ą┐čāčüą║ą░ąĄą╝ SD (ąŠčéą║čĆčŗą▓ą░ąĄčéčüčÅ ą▓ ą▒čĆą░čāąĘąĄčĆąĄ) ąĖ ą▓ąĖą┤ąĖą╝ ąĖąĮč鹥čĆč乥ą╣čü:

1. ąÆ ą▓ąĄčĆčģąĮąĄą╝ ą╗ąĄą▓ąŠą╝ čāą│ą╗čā ąĖąĘ ą▓čŗą┐ą░ą┤ą░čÄčēąĄą│ąŠ čüą┐ąĖčüą║ą░ ą▓čŗą▒ąĖčĆą░ąĄą╝ čüą║ą░čćą░ąĮąĮčāčÄ ą╝ąŠą┤ąĄą╗čī Reliberate_v2.0.

2. ą¤ąĄčĆąĄčģąŠą┤ąĖą╝ ąĮą░ ą▓ą║ą╗ą░ą┤ą║čā img2img.

3. ąØą░ ą▓ą║ą╗ą░ą┤ą║ąĄ Generation ą▓čŗą▒ąĖčĆą░ąĄą╝ čĆąĄąČąĖą╝ Inpaint. ąóą░ą║ ą╝čŗ čüą╝ąŠąČąĄą╝ ą▓čŗą▒čĆą░čéčī ą║ąŠąĮą║čĆąĄčéąĮąŠ čéčā ąŠą▒ą╗ą░čüčéčī, ą║ąŠč鹊čĆčāčÄ ą▒čāą┤ąĄą╝ ą│ąĄąĮąĄčĆąĖčĆąŠą▓ą░čéčī.

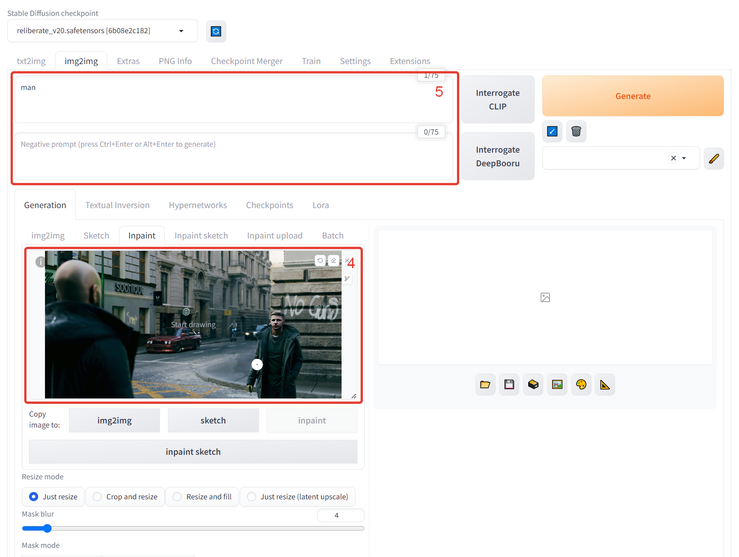

4. ąŚą░ą│čĆčāąČą░ąĄą╝ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖąĄ.

5. ą¤ąĖčłąĄą╝ ą┐ąŠą┤čüą║ą░ąĘą║čā ą┤ą╗čÅ ąĮąĄą╣čĆąŠąĮą║ąĖ (prompt). ąÆ ą▓ąĄčĆčģąĮąĄą╝ ąŠą║ąĮąĄ č鹊 čćč鹊 čģąŠčéąĖą╝ ą▓ąĖą┤ąĄčéčī, ą▓ ąĮąĖąČąĮąĄą╝ č鹊 čćč鹊 ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ ąĖčüą║ą╗čÄčćąĖčéčī. ą», ą║ą░ą║ ą▓ąĖą┤ąĖč鹥, čü ąŠą┐ąĖčüą░ąĮąĖąĄą╝ čüąĖą╗čīąĮąŠ ąĮąĄ ąĘą░ą╝ąŠčĆą░čćąĖą▓ą░ą╗čüčÅ.

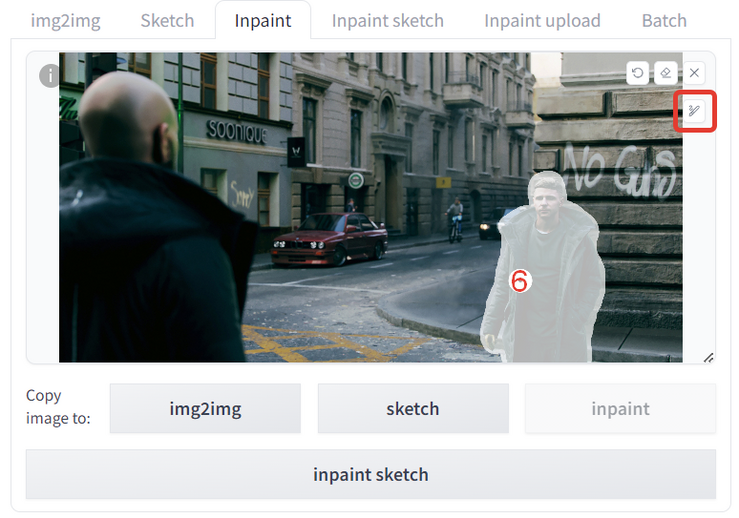

6. ąĪ ąĮąĄą▒ąŠą╗čīčłąĖą╝ ąĘą░ą┐ą░čüąŠą╝ ą▓čŗą┤ąĄą╗čÅąĄą╝ ą┐ąĄčĆąŠą╝ ąŠą▒ą╗ą░čüčéčī, ą║ąŠč鹊čĆčāčÄ čģąŠčéąĖą╝ čüą║ąŠčĆčĆąĄą║čéąĖčĆąŠą▓ą░čéčī.

ąĪą┐čāčüą║ą░ąĄą╝čüčÅ ą▓ ąĮą░čüčéčĆąŠą╣ą║ąĖ ąĮąĖąČąĄ.

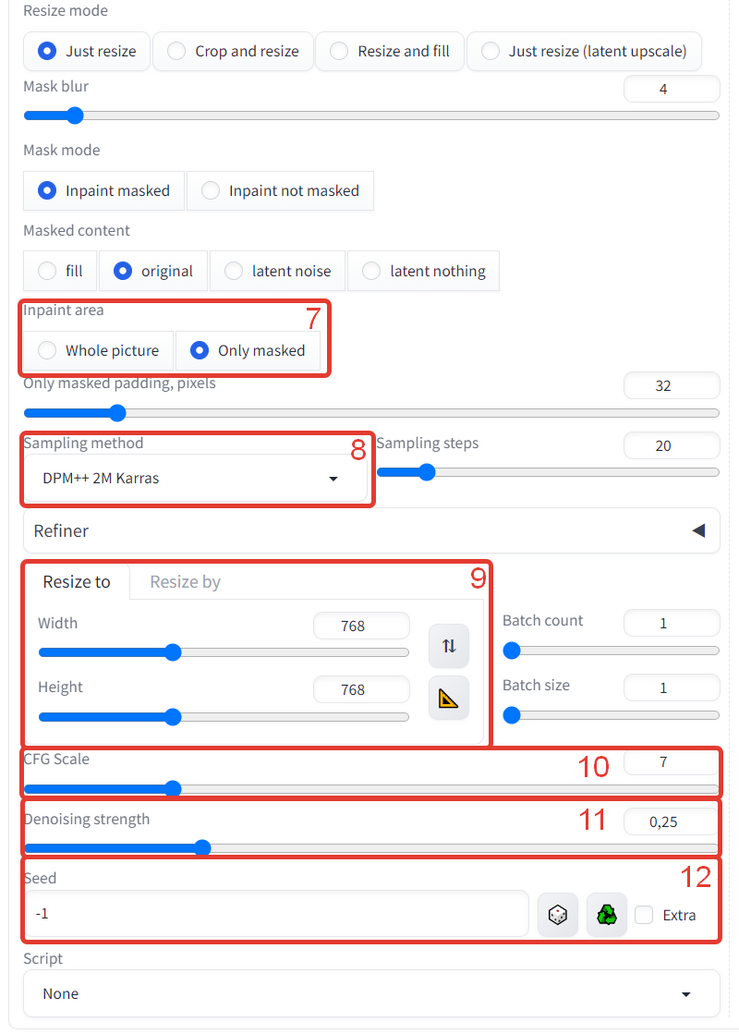

7. ąÆčŗą▒ąĖčĆą░ąĄą╝ ąŠą▒ą╗ą░čüčéčī ą│ąĄąĮąĄčĆą░čåąĖąĖ Only masked (č鹊ą╗čīą║ąŠ ą▓čŗą┤ąĄą╗ąĄąĮąĮąŠąĄ)

8. Sampling metod - DPM++ 2M Karras. ąÆčĆąŠą┤ąĄ ą║ą░ą║ čĆą░ą▒ąŠčéą░ąĄčé ą╗čāčćčłąĄ ą▓čüąĄą│ąŠ, čā ą╝ąĄąĮčÅ čüč鹊čÅą╗ ą┐ąŠ čāą╝ąŠą╗čćą░ąĮąĖčÄ.

9. ąŻčüčéą░ąĮą░ą▓ą╗ąĖą▓ą░ąĄą╝ čĆą░ąĘą╝ąĄčĆ ą│ąĄąĮąĄčĆąĖčĆčāąĄą╝ąŠą│ąŠ čĆąĄąĘčāą╗čīčéą░čéą░ 768 ąĮą░ 768 č鹊č湥ą║. ąŁč鹊 ą╝ą░ą║čüąĖą╝ą░ą╗čīąĮčŗą╣ čĆą░ąĘą╝ąĄčĆ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ čüąŠąĘą┤ą░ą▓ą░ąĄą╝ąŠą│ąŠ ą┤ą░ąĮąĮąŠą╣ ąĮąĄą╣čĆąŠąĮą║ąŠą╣, ą▓čüčæ čćč鹊 ą▒ąŠą╗čīčłąĄ ąŠąĮą░ čüą║ą╗ąĄąĖą▓ą░ąĄčé ąĖąĘ ą║čāčüąŠčćą║ąŠą▓. ą¢ąĄą╗ą░č鹥ą╗čīąĮąŠ čćč鹊ą▒čŗ ą▓čŗą┤ąĄą╗ąĄąĮąĮą░čÅ ąŠą▒ą╗ą░čüčéčī ąĮą░ ąĮą░čłąĄą╝ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖąĖ čüąĖą╗čīąĮąŠ ąĮąĄ ą┐čĆąĄą▓čŗčłą░ą╗ą░ čŹč鹊ą│ąŠ čĆą░ąĘą╝ąĄčĆą░. ąĢčüą╗ąĖ ąŠąĮą░ ą▒čāą┤ąĄčé ą▒ąŠą╗čīčłąĄ č鹊 čüą│ąĄąĮąĄčĆąĖčĆąŠą▓ą░ąĮąĮąŠąĄ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖąĄ 768*768 ą┐čĆąŠčüč鹊 ą▒čāą┤ąĄčé čĆą░čüčéčÅąĮčāč鹊, čćč鹊 ą╝ąŠąČąĄčé ą┐ąŠą▓ą╗ąĖčÅčéčī ąĮą░ ą║ą░č湥čüčéą▓ąŠ.

10. CFG Scale - čŹč鹊 ą▓ąĄą╗ąĖčćąĖąĮą░ čüąŠąŠčéą▓ąĄčéčüčéą▓ąĖčÅ č鹥ą║čüč鹊ą▓ąŠą╝čā ąĘą░ą┐čĆąŠčüčā. ą¦ąĄą╝ ą▓čŗčłąĄ, č鹥ą╝ ą▒ą╗ąĖąČąĄ ąĘą░ą┐čĆąŠčłąĄąĮąĮčŗą╣ čĆąĄąĘčāą╗čīčéą░čé, ąĮąŠ ą▓ą╝ąĄčüč鹥 čü č鹥ą╝ ąĖ ą▒ąŠą╗ąĄąĄ čłčāą╝ąĮčŗą╣. ą» ąŠčüčéą░ą▓ąĖą╗ čŹč鹊 ąĘąĮą░č湥ąĮąĖąĄ ą┐ąŠ čāą╝ąŠą╗čćą░ąĮąĖčÄ.

11. Denoising strenght - čüč鹥ą┐ąĄąĮčī ąŠčéą╗ąĖčćąĖčÅ ąĮąŠą▓ąŠą│ąŠ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ ąŠčé ąĖčüčģąŠą┤ąĮąŠą│ąŠ, ą│ą┤ąĄ 0 - ąŠčéčüčāčéčüčéą▓ąĖąĄ ąĖąĘą╝ąĄąĮąĄąĮąĖą╣, ą░ 1 - ą┐ąŠą╗ąĮąŠčüčéčīčÄ ąĮąŠą▓ą░čÅ ą║ą░čĆčéąĖąĮą║ą░. ąŻ ą╝ąĄąĮčÅ čüčĆąĄą┤ąĮąĖą╣ ą┤ąĖą░ą┐ą░ąĘąŠąĮ ą┤ą╗čÅ ą┐ąŠą┤ąŠą▒ąĮąŠą╣ ąĘą░ą┤ą░čćąĖ ąŠą▒čŗčćąĮąŠ čüąŠčüčéą░ą▓ą╗čÅąĄčé 0,2-0,45. ąĢčüą╗ąĖ ąŠčüčéą░ą▓ąĖčéčī 0,7 č鹊 ą╝ąŠąČąĄčé ą┐ąŠą╗čāčćąĖčéčīčüčÅ čéą░ą║ąŠą╣ čĆąĄąĘčāą╗čīčéą░čé:

ąØą░ą╝ ąČąĄ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠ ąŠčüčéą░čéčīčüčÅ čćčāčéčī ą▒ą╗ąĖąČąĄ ą║ ąĖčüčģąŠą┤ąĮąĖą║čā, ą┐ąŠčŹč鹊ą╝čā ą▓ąŠąĘčīą╝ąĄą╝ 0,4.

12. Seed - č鹊čćą║ą░ čüčéą░čĆčéą░ ą│ąĄąĮąĄčĆą░čåąĖąĖ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ. -1 - ą▓čüąĄą│ą┤ą░ čĆą░ąĮą┤ąŠą╝ąĮčŗą╣ čĆąĄąĘčāą╗čīčéą░čé. ąĢčüą╗ąĖ ą┐ąŠą┤čüčéą░ą▓ąĖčéčī ą╗čÄą▒ąŠąĄ ą┐ąŠą╗ąŠąČąĖč鹥ą╗čīąĮąŠąĄ čćąĖčüą╗ąŠ, č鹊 čĆąĄąĘčāą╗čīčéą░čéčŗ ą▒čāą┤čāčé ą┐ąŠčģąŠąČąĖą╝ąĖ. ą» ąŠčüčéą░ą▓ąĖą╗ -1 ąĖ ą│ąĄąĮąĄčĆąĖčĆąŠą▓ą░ą╗ ą┐ąŠą║ą░ ąĮąĄ ąĮą░čłčæą╗ ą┐ąŠą┤čģąŠą┤čÅčēąĖą╣.

13. ą¢ą╝ąĄą╝ ą║ąĮąŠą┐ą║čā Generate.

ąĪąŠą▒čüčéą▓ąĄąĮąĮąŠ ą▓ąŠčé ą┐ą░čĆą░ ą┐ąŠą╗čāč湥ąĮąĮčŗčģ ą▓ą░čĆąĖą░ąĮč鹊ą▓. ąØą░ ąŠą┤ąĮąŠą╝ čüąŠčģčĆą░ąĮąĖą╗ąĖčüčī č湥čĆčéčŗ ą╗ąĖčåą░ čü ąĖčüčģąŠą┤ąĮąŠą│ąŠ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ, ąĮą░ ą┤čĆčāą│ąŠą╝ ą┐ąĄčĆčüąŠąĮą░ąČ čüą╝ąŠčéčĆąĖčé ą┐čĆčÅą╝ ą▓ ą║ą░ą╝ąĄčĆčā ąĖ ą▓čŗą│ą╗čÅą┤ąĖčé ą▒čĆčāčéą░ą╗čīąĮąĄą╣ čćč鹊 ą╗ąĖ). ąØą░ ą╝ąŠą╣ ą▓ąĘą│ą╗čÅą┤ čĆąĄąĘčāą╗čīčéą░čé ąŠčéą╗ąĖčćąĮčŗą╣, ą┐čĆąĖ č鹊ą╝ čćč鹊 čÅ ą┐ąŠčéčĆą░čéąĖą╗ ąĮą░ ąĮąĄą│ąŠ ą▓čüąĄą│ąŠ ąĮąĄčüą║ąŠą╗čīą║ąŠ ą╝ąĖąĮčāčé.

ąÜč鹊 ą▒čŗ čćč鹊 ąĮąĖ ą│ąŠą▓ąŠčĆąĖą╗, ąĮąŠ ąĮąĄą╣čĆąŠčüąĄčéąĖ čŹč鹊 ą▒čāą┤čāčēąĄąĄ. ąś ą┤ą░, ą╝ąĮąĄ č鹊ąČąĄ ą┐ąŠčĆąŠą╣ čüčéčĆą░čłąĮąŠ ąŠčé č鹊ą│ąŠ čü ą║ą░ą║ąŠą╣ čüą║ąŠčĆąŠčüčéčīčÄ čĆą░ąĘą▓ąĖą▓ą░ąĄčéčüčÅ čŹčéą░ č鹥čģąĮąŠą╗ąŠą│ąĖčÅ. ąØąŠ ąĮąĄ ąĘą░ą╝ąĄčćą░čéčī ąĖ ąĮąĄ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ąĄčæ - ą┤ą╗čÅ ą╝ąĄąĮčÅ čŹč鹊 ąŠčüčéą░čéčīčüčÅ ąĮą░ ąŠą▒ąŠčćąĖąĮąĄ ąĖąĮą┤čāčüčéčĆąĖąĖ. ąØą░ą┤ąĄčÄčüčī čüą╝ąŠą│ ąŠčéą║čĆčŗčéčī ą┤ą╗čÅ ą║ąŠą│ąŠ-č鹊 ąĮąŠą▓čāčÄ ąŠą▒ą╗ą░čüčéčī ąĖ ą▒čŗą╗ąŠ čģąŠčéčī ąĮąĄą╝ąĮąŠą│ąŠ ą┐ąŠą╗ąĄąĘąĮąŠ. ąÆčüąĄą╝ čāčüą┐ąĄčģąŠą▓ ą▓ čéą▓ąŠčĆč湥čüčéą▓ąĄ!

ąöą╗čÅ ą┐čĆąĖą╝ąĄčĆą░ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ą╗ čĆą░ą▒ąŠčéčā fox2_87 . ąĪą┐ą░čüąĖą▒ąŠ č鹥ą▒ąĄ čćč鹊 čĆą░ąĘčĆąĄčłąĖą╗ ą▓čüčéą░ą▓ąĖčéčī ąĄčæ ą▓ čŹčéčā čüčéą░čéčīčÄ)