–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –ú–æ–∂–µ—Ç –ø—Ä–æ—Å—Ç–æ —Å–¥–µ–ª–∞—é—Ç PCB –Ω–∞ 2–º–º —Ç–æ–ª—â–µ –∞ –∫—Ä—ã—à–∫—É –Ω–∞ 2–º–º –º–µ–Ω—å—à–µ –∏ - –æ —á—É–¥–æ, 16-—Ç–∏ —è–¥–µ—Ä–Ω—ã–π –Ý–∞–π–∑–µ–Ω —Å—Ç–∞–Ω–µ—Ç –Ω–∞ 5-7 –≥—Ä–∞–¥—É—Å–æ–≤ –º–µ–Ω—å—à–µ –≥—Ä–µ—Ç—å—Å—è, –≤–∞—É... –ê –µ—â–µ –º–æ–∂–Ω–æ –¥–æ–π—Ç–∏ –¥–æ —à–ª–∏—Ñ–æ–≤–∫–∏ IHS –∫—Ä—ã—à–µ–∫ –Ω–∞ –∑–∞–≤–æ–¥–µ. –¢–æ–∂–µ —Å–Ω–∏–∑–∏—Ç –Ω–∞–≥—Ä–µ–≤ –Ω–∞ –Ω–µ—Å–∫–æ–ª—å–∫–æ –≥—Ä–∞–¥—É—Å–æ–≤. –ê –º–æ–∂–Ω–æ –ø—Ä–æ—Å—Ç–æ –≤ –æ–±–Ω–æ–≤–ª–µ–Ω–∏—è—Ö –ë–∏–æ—Å–∞ –ø–æ—Å–ª–µ–¥—É—é—â–∏—Ö —Ç–∏—Ö–æ–Ω—å–∫–æ —Å–º–µ—Å—Ç–∏—Ç—å –ª–∏–º–∏—Ç —á—É—Ç–∫–∞, –Ω—É –Ω–∞–ø—Ä–∏–º–µ—Ä –¥–æ 215–≤—Ç –≤–º–µ—Å—Ç–æ 230¬Ý ¬Ý–ú–æ–∂–Ω–æ –ø—Ä–æ—Å—Ç–æ —Å–ª–µ–¥—É—é—â–∏–º –ø—Ä–æ—Ü–∞–º –Ω–µ –º–µ–Ω—è—Ç—å —Ç–µ—Ö–ø—Ä–æ—Ü–µ—Å—Å –∏ –±–∏–±–ª–∏–æ—Ç–µ–∫–∏ –ª–∏—Ç–æ–≥—Ä–∞—Ñ–∏–∏ –∏ –ø—Ä–æ—Å—Ç–æ –≤—ã–∫–∞—Ç–∏—Ç—å –±–æ–ª–µ–µ –æ–±–∫–∞—Ç–∞–Ω–Ω—ã–π —Ä–µ–∑—É–ª—å—Ç–∞—Ç —Å –º–µ–Ω—å—à–∏–º–∏ —É—Ç–µ—á–∫–∞–º–∏ —Ç–æ–∫–∞. –ù—É –∞ —á—É—Ç—å —á—Ç–æ, —á—Ç–æ –±—ã –Ω–µ –±—É—Ö—Ç–µ–ª–∏ –º–æ–∂–Ω–æ –µ—â–µ –≤—Å–ø–æ–º–Ω–∏—Ç—å –æ–ø—ã—Ç –ø–µ—Ä–≤—ã—Ö –Ý–∞–π–∑–µ–Ω–æ–≤ –≥–¥–µ –¥–µ–ª–∞–ª–∏ –û—Ñ—Ñ—Å–µ—Ç –∑–∞–≤–æ–¥—Å–∫–æ–π –Ω–∞ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä–Ω—ã–µ –¥–∞—Ç—á–∏–∫–∏. –ù—É –∞ —á—ë... –≠—Ç–æ –∑–∞–ø–∞—Å–Ω–æ–π –ø–ª–∞–Ω )) –ü–æ–ª—å–∑–æ–≤–∞—Ç–µ–ª—å –≤–∏–¥–∏—Ç 75 –≥—Ä–∞–¥—É—Å–æ–≤ - —Ä–∞–¥—É–µ—Ç—Å—è, –Ω—É –∞ —Ç–æ —á—Ç–æ —Ç–∞–º 85-90, –Ω–∏—á–µ–≥–æ —Å—Ç—Ä–∞—à–Ω–æ–≥–æ –≤–µ–¥—å. ¬Ý–ú–æ–∂–Ω–æ –ø—Ä–æ—Å—Ç–æ —Å–ª–µ–¥—É—é—â–∏–º –ø—Ä–æ—Ü–∞–º –Ω–µ –º–µ–Ω—è—Ç—å —Ç–µ—Ö–ø—Ä–æ—Ü–µ—Å—Å –∏ –±–∏–±–ª–∏–æ—Ç–µ–∫–∏ –ª–∏—Ç–æ–≥—Ä–∞—Ñ–∏–∏ –∏ –ø—Ä–æ—Å—Ç–æ –≤—ã–∫–∞—Ç–∏—Ç—å –±–æ–ª–µ–µ –æ–±–∫–∞—Ç–∞–Ω–Ω—ã–π —Ä–µ–∑—É–ª—å—Ç–∞—Ç —Å –º–µ–Ω—å—à–∏–º–∏ —É—Ç–µ—á–∫–∞–º–∏ —Ç–æ–∫–∞. –ù—É –∞ —á—É—Ç—å —á—Ç–æ, —á—Ç–æ –±—ã –Ω–µ –±—É—Ö—Ç–µ–ª–∏ –º–æ–∂–Ω–æ –µ—â–µ –≤—Å–ø–æ–º–Ω–∏—Ç—å –æ–ø—ã—Ç –ø–µ—Ä–≤—ã—Ö –Ý–∞–π–∑–µ–Ω–æ–≤ –≥–¥–µ –¥–µ–ª–∞–ª–∏ –û—Ñ—Ñ—Å–µ—Ç –∑–∞–≤–æ–¥—Å–∫–æ–π –Ω–∞ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä–Ω—ã–µ –¥–∞—Ç—á–∏–∫–∏. –ù—É –∞ —á—ë... –≠—Ç–æ –∑–∞–ø–∞—Å–Ω–æ–π –ø–ª–∞–Ω )) –ü–æ–ª—å–∑–æ–≤–∞—Ç–µ–ª—å –≤–∏–¥–∏—Ç 75 –≥—Ä–∞–¥—É—Å–æ–≤ - —Ä–∞–¥—É–µ—Ç—Å—è, –Ω—É –∞ —Ç–æ —á—Ç–æ —Ç–∞–º 85-90, –Ω–∏—á–µ–≥–æ —Å—Ç—Ä–∞—à–Ω–æ–≥–æ –≤–µ–¥—å. –ê –≤–æ–æ–±—â–µ. –Ø –ø—Ä—è–º –≤–∏–∂—É –±—É–¥—É—â–µ–µ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä–æ–≤ - Direct Die –æ—Ö–ª–∞–¥. –ö–∞–∫ –Ω–∞ –Ω–æ—É—Ç–±—É–∫–∞—Ö –∏ –≤–∏–¥–µ–æ–∫–∞—Ä—Ç–∞—Ö. –ü—Ä–∞–≤–¥–∞ –ø—Ä–∏–¥–µ—Ç—Å—è –ø—Ä–∏–¥—É–º–∞—Ç—å –∏–¥–µ–∞–ª—å–Ω—ã–π –º–µ—Ö–∞–Ω–∏–∑–º –∫—Ä–µ–ø–ª–µ–Ω–∏—è. –ù–æ —ç—Ç–æ –≤–æ—Ç –ø—Ä—è–º —Å—Ä–∞–∑—É —Å—Ä–µ–∂–µ—Ç –ª–∏—Ö–æ –Ω–∞–≥—Ä–µ–≤ )) –ù—É –≤–æ–æ–±—â–µ —ç—Ç–æ –≤–ø–æ–ª–Ω–µ —Ä–µ–∞–ª—å–Ω–æ. –í–æ–æ–±—â–µ —ç—Ç–∞ —Ç–µ–º–∞ –Ω—ã–Ω—á–µ –ø–æ–ø—É–ª—è—Ä–Ω–∞. –í—Å–µ –µ–π —Å—Ç—Ä–∞–¥–∞—é—Ç –ø–æ–Ω–µ–º–Ω–æ–≥—É. https://youtu.be/mhlxysoNs68 https://youtu.be/Ze-nMPHO7bw ¬Ý https://youtu.be/uwKOIP0PUYI ¬Ý https://youtu.be/y_jaS_FZcjI –ò —Ç–∞–∫ –¥–∞–ª–µ–µ... |

|

–ù–∞ —Å–∞–π—Ç–µ c 16.10.2017

–°–æ–æ–±—â–µ–Ω–∏–π: 682

| –í –æ–±—â–µ–º, –∫—É–ø–∏–ª —è —ç—Ç–æ—Ç 13900–∫, –∏ –≤–æ–∑–Ω–∏–∫–ª–∞ –ø—Ä–æ–±–ª–µ–º–∞: –∞ –∫–∞–∫ —ç—Ç–æ —Ç–µ—Å—Ç–∏—Ä–æ–≤–∞—Ç—å –Ω–∞ —Å—Ç–∞–±–∏–ª—å–Ω–æ—Å—Ç—å, –æ—Å–æ–±–µ–Ω–Ω–æ –≤ –ø—Ä–æ—Ü–µ—Å—Å–µ —Ç—é–Ω–∏–Ω–≥–∞ –∏ –≤—Å—è–∫–æ–≥–æ —Ç–∞–∫–æ–≥–æ. –Ý–∞–Ω—å—à–µ —è –∫–∞–∫ –ø–æ—Å—Ç—É–ø–∞–ª: –ø—Ä–æ–≤–æ–¥–∏–ª —Å–µ—Ä–∏—é —Ç–µ—Å—Ç–æ–≤, –ø–æ –Ω–µ—Å–∫–æ–ª—å–∫–æ —á–∞—Å–æ–≤ –Ω–∞ –∫–∞–∂–¥—ã–π: 1) Prime95

2) LinX

3) TestMem5 –ù—É –∏ —É—Å–ª–æ–≤–Ω–æ, –µ—Å–ª–∏ –≤ —Ç–µ—á–µ–Ω–∏–∏ —Å–∫–∞–∂–µ–º —á–∞—Å–æ–≤ 8 —Ç–µ—Å—Ç–∞ —ç—Ç–∏–º–∏ —Å—Ä–µ–¥—Å—Ç–≤–∞–º–∏ –æ—à–∏–±–æ–∫ –Ω–µ –±—ã–ª–æ - –∑–Ω–∞—á–∏—Ç –∫–æ–Ω—Ñ–∏–≥ —Å—Ç–∞–±–∏–ª–µ–Ω. –¢—É—Ç –∂–µ, –∏–∑ –∫–æ—Ä–æ–±–∫–∏ –µ—Å–ª–∏ –∑–∞–ø—É—Å—Ç–∏—Ç—å Prime95 - —Ö—Ä—è—Å—å, –∏ 100 –≥—Ä–∞–¥—É—Å–æ–≤. –° LinX –ø–æ–ª—É—á—à–µ, –Ω–æ —Ç–æ–∂–µ –≤ –ø—Ä–µ–¥–µ–ª –ø–æ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä–µ —É–ø–∏—Ä–∞–µ—Ç—Å—è –±—ã—Å—Ç—Ä–æ. TestMem5 - —ç—Ç–æ—Ç –ø–∞–º—è—Ç—å —Ç–µ—Å—Ç–∏—Ä—É–µ—Ç, –ø–æ—ç—Ç–æ–º—É —Ç—É—Ç –æ–∫. –Ý–∞–∑–Ω—ã–µ —Ç–∞–º –°–∏–Ω–µ–±–µ–Ω—á–∏ –Ω–µ—Ç —Å–º—ã—Å–ª–∞ –∑–∞–ø—É—Å–∫–∞—Ç—å - —ç—Ç–æ –∏ –Ω–∞–≥—Ä—É–∑–∫–∞ —Å–ª–∞–±–∞—è, –∏ —á—Ç–æ —Ç–∞–º –≤–æ–æ–±—â–µ –æ—à–∏–±–∫–æ–π —Ç–æ –º–æ–∂–µ—Ç –±—ã—Ç—å? –í –±–∏—Ç–µ –æ—à–∏–±–∫–∞ - –Ω—É –ø—Ä–∏–≤–µ–¥–µ—Ç –∫ —á—É—Ç—å –¥—Ä—É–≥–æ–º—É –æ—Ç—Ç–µ–Ω–∫—É –ø–∏–∫—Å–µ–ª—è, –∫–∞–∫ —Ç–∞–º –æ—à–∏–±–∫—É –æ–ø—Ä–µ–¥–µ–ª–∏—Ç—å? –í –æ–±—â–µ–º, –ø–æ–∫–∞ —á—Ç–æ —Å—Ç—Ä–∞—Ç–µ–≥–∏—è —Ç–µ—Å—Ç–∏—Ä–æ–≤–∞–Ω–∏—è –¥–ª—è –º–µ–Ω—è –Ω–µ –ø–æ–Ω—è—Ç–Ω–∞—è. –î–µ–ª–∞—Ç—å –æ—Ñ—Å–µ—Ç—ã –µ—Å–ª–∏ - –∞ –∫–∞–∫ –ø–æ—Ç–æ–º –ø—Ä–æ–≤–µ—Ä–∏—Ç—å —Ç–æ –≤—Å–µ —ç—Ç–æ —Å —Ç–∞–∫–æ–π –≤–æ—Ç –¥–æ–ª–±–µ–∂–∫–æ–π –≤ —Å–æ—Ç–Ω—é –≥—Ä–∞–¥—É—Å–æ–≤? –¶–∏—Ç–∞—Ç–∞ Reiiishi: –¶–∏—Ç–∞—Ç–∞ Thunderbird: –ü–æ–∫–∞ —Å–∏–¥–∏–º –Ω–∞ 5950x –∏ –Ω–µ —Å—É–µ—Ç–∏–º—Å—è c –æ–¥–Ω–æ–π —Å—Ç–æ—Ä–æ–Ω—ã –¥–∞, –∞ —Å –¥—Ä—É–≥–æ–π —Å—Ç–æ—Ä–æ–Ω—ã –ø–µ—Ä–µ—Ö–æ–¥ —Å 5950x –Ω–∞ 13900–∫ - –Ω–∞ –≥–ª–∞–∑ –≤–µ—Å—å–º–∞ –∑–∞–º–µ—Ç–µ–Ω –ø–æ –ø—Ä–æ–∏–∑–≤–æ–¥–∏—Ç–µ–ª—å–Ω–æ—Å—Ç–∏, –¥–∞–∂–µ –≤ –ø–æ–≤—Å–µ–¥–Ω–µ–≤–Ω—ã—Ö –∑–∞–¥–∞—á–∞—Ö. –Ø –∞–ø–≥—Ä–µ–π–¥ —ç—Ç–æ—Ç –¥–µ–ª–∞–ª –Ω–µ –ø–æ—Ç–æ–º—É —á—Ç–æ –Ω–∞–¥–æ, –∞ —Ç–∞–∫, —Ä–∞–¥–∏ —Ä–∞–∑–≤–ª–µ—á–µ–Ω–∏—è - –∏ —Ä–µ–∑—É–ª—å—Ç–∞—Ç –≤ —Ü–µ–ª–æ–º –Ω–µ —Ä–∞–∑–æ—á–∞—Ä–æ–≤–∞–ª. |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –¶–∏—Ç–∞—Ç–∞ rainmangrizzli: –Ý–∞–∑–Ω—ã–µ —Ç–∞–º –°–∏–Ω–µ–±–µ–Ω—á–∏ –Ω–µ—Ç —Å–º—ã—Å–ª–∞ –∑–∞–ø—É—Å–∫–∞—Ç—å - —ç—Ç–æ –∏ –Ω–∞–≥—Ä—É–∑–∫–∞ —Å–ª–∞–±–∞—è, –∏ —á—Ç–æ —Ç–∞–º –≤–æ–æ–±—â–µ –æ—à–∏–±–∫–æ–π —Ç–æ –º–æ–∂–µ—Ç –±—ã—Ç—å? –í –±–∏—Ç–µ –æ—à–∏–±–∫–∞ - –Ω—É –ø—Ä–∏–≤–µ–¥–µ—Ç –∫ —á—É—Ç—å –¥—Ä—É–≥–æ–º—É –æ—Ç—Ç–µ–Ω–∫—É –ø–∏–∫—Å–µ–ª—è, –∫–∞–∫ —Ç–∞–º –æ—à–∏–±–∫—É –æ–ø—Ä–µ–¥–µ–ª–∏—Ç—å? –í –æ–±—â–µ–º, –ø–æ–∫–∞ —á—Ç–æ —Å—Ç—Ä–∞—Ç–µ–≥–∏—è —Ç–µ—Å—Ç–∏—Ä–æ–≤–∞–Ω–∏—è –¥–ª—è –º–µ–Ω—è –Ω–µ –ø–æ–Ω—è—Ç–Ω–∞—è. –î–µ–ª–∞—Ç—å –æ—Ñ—Å–µ—Ç—ã –µ—Å–ª–∏ - –∞ –∫–∞–∫ –ø–æ—Ç–æ–º –ø—Ä–æ–≤–µ—Ä–∏—Ç—å —Ç–æ –≤—Å–µ —ç—Ç–æ —Å —Ç–∞–∫–æ–π –≤–æ—Ç –¥–æ–ª–±–µ–∂–∫–æ–π –≤ —Å–æ—Ç–Ω—é –≥—Ä–∞–¥—É—Å–æ–≤? –ï—Å–ª–∏ –ø—Ä–æ—Ü –Ω–µ—Å—Ç–∞–±–∏–ª–µ–Ω –≤ CBR23 - –ª–∏–±–æ —Ä–µ–Ω–¥–µ—Ä –≤—ã–ª–µ—Ç–∏—Ç. –õ–∏–±–æ –∫–æ–º–ø –∑–∞–≤–∏—Å–Ω–µ—Ç. –õ–∏–±–æ —É–π–¥–µ—Ç –≤ —Ä–µ–±—É—Ç. –õ–∏–±–æ –≤—ã–ª–µ—Ç–∏—Ç –°–∏–Ω–∏–π —ç–∫—Ä–∞–Ω "clock_watchdog_timeout". CBR23 –≤ —Ä–µ–∂–∏–º–µ —Å—Ç—Ä–µ—Å—Å —Ç–µ—Å—Ç–∞ 30-–º–∏–Ω—É—Ç–Ω–æ–≥–æ - –±–æ–ª–µ–µ —á–µ–º –¥–æ—Å—Ç–∞—Ç–æ—á–Ω–æ –ø—Ä–∏ –∞–Ω–¥–µ—Ä–≤–æ–ª—å—Ç–µ. –°–Ω–∞—á–∞–ª–∞ –ø—Ä–æ–±—É–µ—Ç–µ -0.1V –∞–¥–∞–ø—Ç–∏–≤–Ω—ã–π –æ—Ñ—Ñ—Å–µ—Ç. –ò –Ω–∞—á–∏–Ω–∞–µ—Ç–µ —Å–ø—É—Å–∫–∞—Ç—å—Å—è –¥–æ –º–æ–º–µ–Ω—Ç–∞ –ø–æ–∫–∞ –Ω–µ –≤—ã–ª–µ—Ç–∏—Ç. –ó–∞—Ç–µ–º –ø—Ä–æ—Å—Ç–æ –Ω–∞ –¥–≤–∞ —à–∞–≥–∞ –æ–±—Ä–∞—Ç–Ω–æ –≤–æ–∑–≤—Ä–∞—â–∞–µ—Ç–µ—Å—å. –ù–∞–ø—Ä–∏–º–µ—Ä : -0.1V - –û–∫ -0.11V - –û–∫ -0.12V - –û–∫ -0.13V - –ö—Ä–∞—à. –ó–Ω–∞—á–∏—Ç –æ—Ç–∫–∞—Ç—ã–≤–∞–µ–º—Å—è –Ω–∞ -0.11V –∏ –ø—Ä–æ–≥–æ–Ω—è–µ–º –µ—â–µ —Ä–∞–∑ —Ç–µ—Å—Ç. –¢–µ—Å—Ç–∏—Ç—å –ü—Ä–∞–π–º–æ–º - —ç—Ç–æ –±—Ä–µ–¥. –¢–∞–∫–∏—Ö –Ω–∞–≥—Ä—É–∑–æ–∫ –≤ —Ä–µ–∞–ª—å–Ω–æ–π —Ä–∞–±–æ—Ç–µ –≤—ã –Ω–∏–≥–¥–µ –Ω–µ –Ω–∞–π–¥–µ—Ç–µ. –ï—Å–ª–∏ —Ä–µ—á—å –∏–¥–µ—Ç –ø—Ä–æ Smallest FFT –∏ Small FFT —Ä–µ–∂–∏–º. –¢–µ—Å—Ç–∏—Ç—å –ü—Ä–∞–π–º–æ–º –Ω–∞–¥–æ –ø–∞–º—è—Ç—å –≤ —Ä–µ–∂–∏–º–µ Large FFT. Prime Smallest FFT –∂–º–µ—Ç —Å –ø—Ä–æ—Ü–∞ –≤—Å–µ —Å–æ–∫–∏. –ò–¥–µ–∞–ª—å–Ω–æ —É—Ç–∏–ª–∏–∑–∏—Ä—É–µ—Ç –∫–æ–Ω–≤–µ–π–µ—Ä. –î–∞–∂–µ –≤ —Å—Ç–æ–∫–µ –Ω–µ–∫–æ—Ç–æ—Ä—ã–µ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä—ã –º–æ–≥—É—Ç –Ω–µ—Å—Ç–∞–±–∏–ª—å–Ω–æ —Ä–∞–±–æ—Ç–∞—Ç—å. –ò –Ω–∞ –∫–æ–π —á–µ—Ä—Ç —Ç–∞–∫–æ–π —Ç–µ—Å—Ç ? –ù–∞–ø—Ä–∏–º–µ—Ä –≤–æ –≤—Ä–µ–º–µ–Ω–∞ Haswell-E, Broadwell-E - Smallest FFT —É–±–∏–≤–∞–ª–∏ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä. –î–∞. –ü—Ä—è–º –≤–æ—Ç –Ω–∞—Å–º–µ—Ä—Ç—å. –ó–∞—â–∏—Ç–∞ –Ω–µ —É—Å–ø–µ–≤–∞–ª–∞ —Å—Ä–∞–±–∞—Ç—ã–≤–∞—Ç—å. –ò —ç—Ç–æ –≤ —Å—Ç–æ–∫–µ. –¢–µ—Å—Ç–∏—Ç—å –≥—Ä–µ–ª–∫–∞–º–∏ —Å –∏–¥–µ–∞–ª—å–Ω–æ–π –æ–ø—Ç–∏–º–∏–∑–∞—Ü–∏–µ–π —Ç–∏–ø–∞ LinX Linpack, OCCT+AVX, Prime95 Small FFT —ç—Ç–æ —Ç—É–ø–æ—Å—Ç—å. –°–µ–π—á–∞—Å —Å–∏–∂—É –±–µ–∑ —Å–≤–µ—Ç–∞. –ü—Ä–∏–º–µ—Ä–Ω–æ —Ç–∞–∫ —Å–∫–∞–∂—É (-0.1V) : Corona 9 - –ò–Ω—Ç–µ—Ä—å–µ—Ä –ª–µ–≥–∫–∏–π -¬Ýhttps://i.imgur.com/dp4fHl4.jpg ¬Ý(225–≤—Ç) Corona 9 - –≠–∫—Å—Ç–µ—Ä—å–µ—Ä —Ç—è–∂–µ–ª—ã–π -¬Ýhttps://i.imgur.com/AvfW6I6.jpg ¬Ý(200–≤—Ç) Corona 1.3 Benchmark - ~230–≤—Ç. Cinebench R23 - ~260–≤—Ç. (–ë–µ–∑ –ê–Ω–¥–µ—Ä–≤–æ–ª—å—Ç–∞ 330–≤—Ç) –ö—Å—Ç–∞—Ç–∏ —è –±–æ—è–ª—Å—è –≤—Å–ø–ª–µ—Å–∫–æ–≤ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä—ã –ø—Ä–∏ –î–µ–Ω–æ–π–∑–µ—Ä–µ –≤ –ö–æ—Ä–æ–Ω–µ. –ù–æ –Ω–∞–æ–±–æ—Ä–æ—Ç —É –º–µ–Ω—è –ø—Ä–æ—Ü –ø–æ—á–µ–º—É —Ç–æ –æ—Å—Ç—ã–≤–∞–µ—Ç –∏ —Å–±—Ä–∞—Å—ã–≤–∞–µ—Ç –ø–æ—Ç—Ä–µ–±–ª–µ–Ω–∏–µ. –ú–æ–∂–µ—Ç –∫–∞–∫–∞—è —Ç–æ –∑–∞—â–∏—Ç–∞ —Å—Ä–∞–±–∞—Ç—ã–≤–∞–µ—Ç –∏–ª–∏ –≤ Corona 9 –µ—Å—Ç—å –∫–∞–∫–æ–π —Ç–æ –ø—Ä–µ—Å–µ—Ç –ø–æ–¥ —Å–æ–≤—Ä–µ–º–µ–Ω–Ω—ã–µ –ø—Ä–æ—Ü—ã —Å –±–æ–ª–µ–µ —â–∞–¥—è—â–∏–º –¥–µ–Ω–æ–π–∑–µ—Ä–æ–º, –Ω–µ –∑–Ω–∞—é. 5950–• —É –º–µ–Ω—è –Ω–∞–æ–±–æ—Ä–æ—Ç –Ω–∞ 7+ –≥—Ä–∞–¥—É—Å–æ–≤ —Ç–µ–ø–ª–µ–µ—Ç –ø—Ä–∏ –¥–µ–Ω–æ–π–∑–µ—Ä–µ, –≤ —Ç–æ–º –∂–µ —Ä–µ–Ω–¥–µ—Ä–µ. Prime95 Smallest FFT –¥–∞–∂–µ —Å –∞–Ω–¥–µ—Ä–≤–æ–ª—å—Ç–æ–º –≤—ã–∂–∏—Ä–∞–µ—Ç 330–≤—Ç. –ù–∞ –∫–æ–π —á–µ—Ä—Ç –∏–º —Ç–µ—Å—Ç–∏—Ç—å —Å—Ç–∞–±–∏–ª—å–Ω–æ—Å—Ç—å –µ—Å–ª–∏ –≤ —Ä–µ–∞–ª—å–Ω–æ–π —Ä–∞–±–æ—Ç–µ –≤–∞–º —Ç–∞–∫–∏—Ö —Å—Ü–µ–Ω–∞—Ä–∏–µ–≤ –Ω–∏–∫–æ–≥–¥–∞ –Ω–µ –≤—Å—Ç—Ä–µ—Ç–∏—Ç—å—Å—è. –ù—É –∏–ª–∏ —è –ø—Ä–æ—Å—Ç–æ –ù–ï –∑–Ω–∞—é –ø—Ä–æ —Ç–∞–∫–∏–µ —Å—Ü–µ–Ω–∞—Ä–∏–∏ —Ä–∞–±–æ—Ç—ã. –ï—Å–ª–∏ —É –≤–∞—Å —Ç–∞–∫–æ–≥–æ –ø–ª–∞–Ω–∞ –¥–ª–∏—Ç–µ–ª—å–Ω—ã–µ –Ω–∞–≥—Ä—É–∑–∫–∏, —Ç–æ –ø—Ä–∏–¥–µ—Ç—Å—è —Ç–æ–≥–¥–∞ –≤–∞–º —É—Å—Ç–∞–Ω–∞–≤–ª–∏–≤–∞—Ç—å Intel XTU –∏ –±–æ–ª–µ–µ —Ç–æ–Ω–∫–æ –Ω–∞—Å—Ç—Ä–∞–∏–≤–∞—Ç—å –ø—Ä–æ—Ü -¬Ýhttps://www.intel.ru/content/www/ru/ru/download/17881/intel-extreme-tuning-utility-intel-xtu.html ¬Ý(—Ç–∞–º –º–æ–∂–Ω–æ –ø—Ä–æ—Å—Ç–æ –±–∞—Ö–Ω—É—Ç—å –ª–∏–º–∏—Ç, –≤ 235–≤—Ç –ø–æ–≤–µ—Ä—Ö –û—Ñ—Ñ—Å–µ—Ç–∞). –î–∞ –∏ –æ—Ñ—Ñ—Å–µ—Ç —Ç–∞–º –∂–µ –º–æ–∂–Ω–æ –Ω–∞—Å—Ç—Ä–∞–∏–≤–∞—Ç—å. –ó–∞—Ç–µ–º –ø–µ—Ä–µ–Ω–µ—Å—Ç–∏ –≤ –ë–∏–æ—Å. P.S. –ö–∞–ø–µ—Ü –Ω–µ—É–¥–æ–±–Ω–æ –ø–µ—á–∞—Ç–∞—Ç—å —Å —Ç–µ–ª–µ—Ñ–æ–Ω–∞/ –í–µ—Å—å –¥–µ–Ω—å –±–µ–∑ —Å–≤—è–∑–∏ –±—ã–ª. –°–µ–π—á–∞—Å –≤–∏–¥–∞—Ç—å –≤—ã—à–∫–∞–º —Å–≤–µ—Ç –¥–∞–ª–∏. |

|

–ù–∞ —Å–∞–π—Ç–µ c 16.10.2017

–°–æ–æ–±—â–µ–Ω–∏–π: 682

| –¶–∏—Ç–∞—Ç–∞ Earanak: –¶–∏—Ç–∞—Ç–∞ rainmangrizzli: –Ý–∞–∑–Ω—ã–µ —Ç–∞–º –°–∏–Ω–µ–±–µ–Ω—á–∏ –Ω–µ—Ç —Å–º—ã—Å–ª–∞ –∑–∞–ø—É—Å–∫–∞—Ç—å - —ç—Ç–æ –∏ –Ω–∞–≥—Ä—É–∑–∫–∞ —Å–ª–∞–±–∞—è, –∏ —á—Ç–æ —Ç–∞–º –≤–æ–æ–±—â–µ –æ—à–∏–±–∫–æ–π —Ç–æ –º–æ–∂–µ—Ç –±—ã—Ç—å? –í –±–∏—Ç–µ –æ—à–∏–±–∫–∞ - –Ω—É –ø—Ä–∏–≤–µ–¥–µ—Ç –∫ —á—É—Ç—å –¥—Ä—É–≥–æ–º—É –æ—Ç—Ç–µ–Ω–∫—É –ø–∏–∫—Å–µ–ª—è, –∫–∞–∫ —Ç–∞–º –æ—à–∏–±–∫—É –æ–ø—Ä–µ–¥–µ–ª–∏—Ç—å? –í –æ–±—â–µ–º, –ø–æ–∫–∞ —á—Ç–æ —Å—Ç—Ä–∞—Ç–µ–≥–∏—è —Ç–µ—Å—Ç–∏—Ä–æ–≤–∞–Ω–∏—è –¥–ª—è –º–µ–Ω—è –Ω–µ –ø–æ–Ω—è—Ç–Ω–∞—è. –î–µ–ª–∞—Ç—å –æ—Ñ—Å–µ—Ç—ã –µ—Å–ª–∏ - –∞ –∫–∞–∫ –ø–æ—Ç–æ–º –ø—Ä–æ–≤–µ—Ä–∏—Ç—å —Ç–æ –≤—Å–µ —ç—Ç–æ —Å —Ç–∞–∫–æ–π –≤–æ—Ç –¥–æ–ª–±–µ–∂–∫–æ–π –≤ —Å–æ—Ç–Ω—é –≥—Ä–∞–¥—É—Å–æ–≤? –ï—Å–ª–∏ –ø—Ä–æ—Ü –Ω–µ—Å—Ç–∞–±–∏–ª–µ–Ω –≤ CBR23 - –ª–∏–±–æ —Ä–µ–Ω–¥–µ—Ä –≤—ã–ª–µ—Ç–∏—Ç. –õ–∏–±–æ –∫–æ–º–ø –∑–∞–≤–∏—Å–Ω–µ—Ç. –õ–∏–±–æ —É–π–¥–µ—Ç –≤ —Ä–µ–±—É—Ç. –õ–∏–±–æ –≤—ã–ª–µ—Ç–∏—Ç –°–∏–Ω–∏–π —ç–∫—Ä–∞–Ω "clock_watchdog_timeout". CBR23 –≤ —Ä–µ–∂–∏–º–µ —Å—Ç—Ä–µ—Å—Å —Ç–µ—Å—Ç–∞ 30-–º–∏–Ω—É—Ç–Ω–æ–≥–æ - –±–æ–ª–µ–µ —á–µ–º –¥–æ—Å—Ç–∞—Ç–æ—á–Ω–æ –ø—Ä–∏ –∞–Ω–¥–µ—Ä–≤–æ–ª—å—Ç–µ. –°–Ω–∞—á–∞–ª–∞ –ø—Ä–æ–±—É–µ—Ç–µ -0.1V –∞–¥–∞–ø—Ç–∏–≤–Ω—ã–π –æ—Ñ—Ñ—Å–µ—Ç. –ò –Ω–∞—á–∏–Ω–∞–µ—Ç–µ —Å–ø—É—Å–∫–∞—Ç—å—Å—è –¥–æ –º–æ–º–µ–Ω—Ç–∞ –ø–æ–∫–∞ –Ω–µ –≤—ã–ª–µ—Ç–∏—Ç. –ó–∞—Ç–µ–º –ø—Ä–æ—Å—Ç–æ –Ω–∞ –¥–≤–∞ —à–∞–≥–∞ –æ–±—Ä–∞—Ç–Ω–æ –≤–æ–∑–≤—Ä–∞—â–∞–µ—Ç–µ—Å—å. –ù–∞–ø—Ä–∏–º–µ—Ä : -0.1V - –û–∫ -0.11V - –û–∫ -0.12V - –û–∫ -0.13V - –ö—Ä–∞—à. –ó–Ω–∞—á–∏—Ç –æ—Ç–∫–∞—Ç—ã–≤–∞–µ–º—Å—è –Ω–∞ -0.11V –∏ –ø—Ä–æ–≥–æ–Ω—è–µ–º –µ—â–µ —Ä–∞–∑ —Ç–µ—Å—Ç. –¢–µ—Å—Ç–∏—Ç—å –ü—Ä–∞–π–º–æ–º - —ç—Ç–æ –±—Ä–µ–¥. –¢–∞–∫–∏—Ö –Ω–∞–≥—Ä—É–∑–æ–∫ –≤ —Ä–µ–∞–ª—å–Ω–æ–π —Ä–∞–±–æ—Ç–µ –≤—ã –Ω–∏–≥–¥–µ –Ω–µ –Ω–∞–π–¥–µ—Ç–µ. –ï—Å–ª–∏ —Ä–µ—á—å –∏–¥–µ—Ç –ø—Ä–æ Smallest FFT –∏ Small FFT —Ä–µ–∂–∏–º. –¢–µ—Å—Ç–∏—Ç—å –ü—Ä–∞–π–º–æ–º –Ω–∞–¥–æ –ø–∞–º—è—Ç—å –≤ —Ä–µ–∂–∏–º–µ Large FFT. Prime Smallest FFT –∂–º–µ—Ç —Å –ø—Ä–æ—Ü–∞ –≤—Å–µ —Å–æ–∫–∏. –ò–¥–µ–∞–ª—å–Ω–æ —É—Ç–∏–ª–∏–∑–∏—Ä—É–µ—Ç –∫–æ–Ω–≤–µ–π–µ—Ä. –î–∞–∂–µ –≤ —Å—Ç–æ–∫–µ –Ω–µ–∫–æ—Ç–æ—Ä—ã–µ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä—ã –º–æ–≥—É—Ç –Ω–µ—Å—Ç–∞–±–∏–ª—å–Ω–æ —Ä–∞–±–æ—Ç–∞—Ç—å. –ò –Ω–∞ –∫–æ–π —á–µ—Ä—Ç —Ç–∞–∫–æ–π —Ç–µ—Å—Ç ? –ù–∞–ø—Ä–∏–º–µ—Ä –≤–æ –≤—Ä–µ–º–µ–Ω–∞ Haswell-E, Broadwell-E - Smallest FFT —É–±–∏–≤–∞–ª–∏ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä. –î–∞. –ü—Ä—è–º –≤–æ—Ç –Ω–∞—Å–º–µ—Ä—Ç—å. –ó–∞—â–∏—Ç–∞ –Ω–µ —É—Å–ø–µ–≤–∞–ª–∞ —Å—Ä–∞–±–∞—Ç—ã–≤–∞—Ç—å. –ò —ç—Ç–æ –≤ —Å—Ç–æ–∫–µ. —ç—Ç–æ —Ç–∞–∫ —Å–µ–±–µ –ø—Ä–æ–≤–µ—Ä–∫–∞. –°–º–æ—Ç—Ä—è –≥–¥–µ –æ—à–∏–±–∫–∞ –ª—è–∂–µ—Ç, –µ—Å–ª–∏ –Ω–∞ –∫–∞–∫–∏–µ —Ç–æ —Å–∏—Å—Ç–µ–º–Ω—ã–µ –ø—Ä–æ—Ü–µ—Å—Å –±–µ–Ω—á–∞, –¥–∞, –±—É–¥–µ—Ç –∫—Ä–∞—à, –∞ –µ—Å–ª–∏ –ø—Ä–æ—Å—Ç–æ, –∫–∞–∫ —è –∏ –ø–∏—Å–∞–ª –±–∏—Ç –±—É–¥–µ—Ç –ø—Ä–∏ –≤—ã—á–∏—Å–ª–µ–Ω–∏–∏ –∑–Ω–∞—á–µ–Ω–∏—è —Ü–≤–µ—Ç–∞ –Ω–µ —Ç–æ—Ç - —Ç–æ –æ—à–∏–±–∫–∞ –±—É–¥–µ—Ç –≤–æ–æ–±—â–µ –Ω–µ –∑–∞–º–µ—Ç–Ω–∞. –∞ –Ω—É–∂–Ω–∞ —Å—Ç—Ä–æ–≥–∞—è –ø—Ä–æ–≤–µ—Ä–∫–∞, —Å–æ —Å–≤–µ—Ä–∫–æ–π –∫–æ—Ä—Ä–µ–∫—Ç–Ω–æ—Å—Ç–∏ –≤—ã—á–∏—Å–ª–µ–Ω–∏–π –ø–æ —Ö–µ—à–∞–º, –∏ –≤—Å—è–∫–æ–º—É —Ç–∞–∫–æ–º—É. –ò–Ω–∞—á–µ –º–æ–∂–Ω–æ –¥—É–º–∞—Ç—å —á—Ç–æ –≤—Å–µ –æ–∫, —Ç.–∫. —Å–∏–Ω–µ–±–µ–Ω—á –Ω–µ –≤—ã–ª–µ—Ç–µ–ª,¬Ý –∞ –Ω–∞ —Å–∞–º–æ–º –¥–µ–ª–µ –Ω–∏—Ö—Ä–µ–Ω–∞ –Ω–µ –æ–∫, –∏ –ø–æ–ª—É—á–∏—Ç—å –ø–æ—Ç–æ–º –∑–∞–ø–∏—Å—å –Ω–µ –≤–µ—Ä–Ω—ã—Ö –∑–Ω–∞—á–µ–Ω–∏–π –≤ —Ö–æ–¥–µ —Ä–∞–±–æ—Ç—ã –∫–∞–∫–æ–≥–æ –Ω–∏–±—É–¥—å –¥—Ä–∞–π–≤–µ—Ä–∞ —Å–∏—Å—Ç–µ–º—ã, –∏ –∫–∞—à—É –Ω–∞ –∂–µ—Å—Ç–∫–æ–º –¥–∏—Å–∫–µ –Ω–∞ —Ä–∞–±–æ—á–µ–º –ø—Ä–æ–µ–∫—Ç–µ –∫–∞–∫ –∏—Ç–æ–≥. –ü—Ä–æ —Ç–æ —á—Ç–æ –ø—Ä–∞–π–º –≤ —Å—Ç–æ–∫–µ —É–±–∏–≤–∞–µ—Ç –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä - –∑–Ω–∞—á–∏—Ç —Ö—Ä–µ–Ω–æ–≤—ã–µ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä—ã –±—ã–ª–∏. –£ –º–µ–Ω—è –Ω–∞ –∞–º–¥ 1950, 3950, 5950 - –ø—Ä–∞–π–º –Ω–∏—á–µ–≥–æ –Ω–µ —É–±–∏–≤–∞–ª, –≤—ã–≤–∞–ª–∏–≤–∞–ª—Å—è —Å –æ—à–∏–±–∫–æ–π, –µ—Å–ª–∏ —á—Ç–æ—Ç–æ –±—ã–ª–æ –Ω–µ —Ç–æ —Å –Ω–∞—Å—Ç—Ä–æ–π–∫–æ–π –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä–∞, –∏ —Ç–æ–ª—å–∫–æ.¬Ý |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –•–æ—Å–ø–∞–¥–µ... –Ø –±—ã –µ—â–µ –ø–æ–Ω—è–ª —Ç–µ—Å—Ç–∏—Ç—å Prime Large FFT –Ω–∞ –æ—à–∏–±–∫–∏ –ø–æ –ø–∞–º—è—Ç–∏, –Ω—É –ª–∞–¥–Ω–æ... –ü–æ—Ö–æ–∂–µ —ç—Ç–æ '–æ—Å–æ–±—ã–π —Å–ª—É—á–∞–π', –ø—Ä–æ–µ—Ö–∞–ª–∏. –ï—Å–ª–∏ —É –≤–∞—Å —Ç–∞–∫–æ–µ –≤–∏–¥–µ–Ω—å–µ —ç—Ç–æ–≥–æ –ø—Ä–æ—Ü–µ—Å—Å–∞ - –¢–æ–≥–¥–∞ –Ω–µ –¥–µ–ª–∞–π—Ç–µ –∞–Ω–¥–µ—Ä–≤–æ–ª—å—Ç —á–µ—Ä–µ–∑ –û—Ñ—Ñ—Å–µ—Ç –∞ –ø—Ä–æ—Å—Ç–æ —É–∂–º–∏—Ç–µ –ª–∏–º–∏—Ç –¥–æ 235–≤—Ç. –¢–æ–≥–¥–∞ –±—É–¥–µ—Ç —Ç–∞–º –≤—Å–µ –µ—â–µ –≥–æ—Ä—è—á–æ –Ω–æ –±–µ–∑ —Ç—Ä–æ—Ç—Ç–ª–∏–Ω–≥–∞, –µ—Å–ª–∏ –≤–æ–¥—è–Ω–∫–∞ –Ω–æ—Ä–º. –ü—Ä–æ–≤–µ—Ä—å—Ç–µ —á—Ç–æ –≤ –ë–∏–æ—Å–µ –≤–∫–ª—é—á–µ–Ω IA CEP, –∏ –≤—Å–µ. –ù–µ –ø–∞—Ä—å—Ç–µ—Å—å. –ó–∞—â–∏—Ç–∞ –æ—Ç –Ω–µ—Ö–≤–∞—Ç–∫–∏ –Ω–∞–ø—Ä—è–∂–µ–Ω–∏—è —Ä–∞–±–æ—Ç–∞–µ—Ç –±—ã—Å—Ç—Ä–µ–µ —á–µ–º —á–∞—Å—Ç–æ—Ç–∞ –ø–∏—Ç–∞–ª—å–Ω–∏–∫–∞. –£ –ê–ú–î –≤ —ç—Ç–æ–º –ø–ª–∞–Ω–µ —á—É—Ç—å –∏–Ω–æ–π –ø–æ–¥—Ö–æ–¥ —Å —Å—Ç—Ä–µ—Ç—á–∏–Ω–≥–æ–º —á–∞—Å—Ç–æ—Ç –ø—Ä–∏ –Ω–µ—Ö–≤–∞—Ç–∫–µ –Ω–∞–ø—Ä—è–∂–µ–Ω–∏—è, –Ω–æ —Å—É—Ç—å —Ç–∞ –∂–µ –≥—Ä—É–±–æ –≥–æ–≤–æ—Ä—è. –¢–æ –µ—Å—Ç—å –µ—Å–ª–∏ –∂–∞—Ç—å –ª–∏–º–∏—Ç—ã –ø–æ –ø–æ—Ç—Ä–µ–±–ª–µ–Ω–∏—é —Ç–æ –ø—Ä–æ—Ü –±—É–¥–µ—Ç –≤—Å–µ–≥–¥–∞ —É—Å–ø–µ–≤–∞—Ç—å —Å–æ—Ö—Ä–∞–Ω—è—Ç—å —Å—Ç–∞–±–∏–ª—å–Ω–æ—Å—Ç—å –ø—Ä–∏ –Ω–∞–≥—Ä—É–∑–∫–µ. –ê–Ω–¥–µ—Ä–≤–æ–ª—å—Ç —á–µ—Ä–µ–∑ –û—Ñ—Ñ—Å–µ—Ç –ø—Ä–æ—Å—Ç–æ –¥–∞–µ—Ç —á—É—Ç—å –ª—É—á—à–µ —Ä–µ–∑—É–ª—å—Ç–∞—Ç—ã —á–µ–º —É–∂–∏–º –ª–∏–º–∏—Ç–∞. –ö—Å—Ç–∞—Ç–∏... –¢–µ—Å—Ç–∏—Ç—å –æ—Ç–¥–µ–ª—å–Ω—ã–µ —è–¥—Ä–∞ –ø—Ä–æ—Ü–∞ –≤ Prime95 Smallest FFT - —É–¥–æ–±–Ω–æ. –ê–Ω–∞–ª–æ–≥ CoreCycler. –ß—Ç–æ –±—ã –ø–æ–Ω—è—Ç—å –Ω–∞—Å–∫–æ–ª—å–∫–æ —É–¥–∞—á–Ω–æ–µ –∫–∞–∂–¥–æ–µ —è–¥—Ä–æ. –í Intel XTU –ø–æ—Ç–æ–º –º–æ–∂–Ω–æ –¥–∞–∂–µ –æ—Ñ—Ñ—Å–µ—Ç –æ—Ç–Ω–æ—Å–∏—Ç–µ–ª—å–Ω–æ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä –∫–æ–Ω–∫—Ä–µ—Ç–Ω–æ–≥–æ —è–¥—Ä–∞ –Ω–∞—Å—Ç—Ä–æ–∏—Ç—å. –¢–æ –µ—Å—Ç—å –≤—ã–±—Ä–∞—Ç—å –≥–æ—Ä—è—á–∏–µ —è–¥—Ä–∞ –∏ —Å–Ω–∏–∑–∏—Ç—å –∏–º –º–Ω–æ–∂–∏—Ç–µ–ª—å. –ê —Å–∞–º—ã–º —Ö–æ–ª–æ–¥–Ω—ã–º –Ω–∞–æ–±–æ—Ä–æ—Ç –ø—Ä–∏–ø–æ–¥–Ω—è—Ç—å. –ù—É —ç—Ç–æ —É–∂–µ –µ—Å–ª–∏ –Ω–∞–¥–æ –¥–æ–∏—Ç—å –∫–∞–∂–¥—ã–π % —Å —á–∞—Å—Ç–æ—Ç. |

|

–ù–∞ —Å–∞–π—Ç–µ c 16.10.2017

–°–æ–æ–±—â–µ–Ω–∏–π: 682

| –¶–∏—Ç–∞—Ç–∞ Earanak: –•–æ—Å–ø–∞–¥–µ... –Ø –±—ã –µ—â–µ –ø–æ–Ω—è–ª —Ç–µ—Å—Ç–∏—Ç—å Prime Large FFT –Ω–∞ –æ—à–∏–±–∫–∏ –ø–æ –ø–∞–º—è—Ç–∏, –Ω—É –ª–∞–¥–Ω–æ... –ü–æ—Ö–æ–∂–µ —ç—Ç–æ '–æ—Å–æ–±—ã–π —Å–ª—É—á–∞–π', –ø—Ä–æ–µ—Ö–∞–ª–∏. –ï—Å–ª–∏ —É –≤–∞—Å —Ç–∞–∫–æ–µ –≤–∏–¥–µ–Ω—å–µ —ç—Ç–æ–≥–æ –ø—Ä–æ—Ü–µ—Å—Å–∞ - –¢–æ–≥–¥–∞ –Ω–µ –¥–µ–ª–∞–π—Ç–µ –∞–Ω–¥–µ—Ä–≤–æ–ª—å—Ç —á–µ—Ä–µ–∑ –û—Ñ—Ñ—Å–µ—Ç –∞ –ø—Ä–æ—Å—Ç–æ —É–∂–º–∏—Ç–µ –ª–∏–º–∏—Ç –¥–æ 235–≤—Ç. –¢–æ–≥–¥–∞ –±—É–¥–µ—Ç —Ç–∞–º –≤—Å–µ –µ—â–µ –≥–æ—Ä—è—á–æ –Ω–æ –±–µ–∑ —Ç—Ä–æ—Ç—Ç–ª–∏–Ω–≥–∞, –µ—Å–ª–∏ –≤–æ–¥—è–Ω–∫–∞ –Ω–æ—Ä–º. –ü—Ä–æ–≤–µ—Ä—å—Ç–µ —á—Ç–æ –≤ –ë–∏–æ—Å–µ –≤–∫–ª—é—á–µ–Ω IA CEP, –∏ –≤—Å–µ. –ù–µ –ø–∞—Ä—å—Ç–µ—Å—å. –ó–∞—â–∏—Ç–∞ –æ—Ç –Ω–µ—Ö–≤–∞—Ç–∫–∏ –Ω–∞–ø—Ä—è–∂–µ–Ω–∏—è —Ä–∞–±–æ—Ç–∞–µ—Ç –±—ã—Å—Ç—Ä–µ–µ —á–µ–º —á–∞—Å—Ç–æ—Ç–∞ –ø–∏—Ç–∞–ª—å–Ω–∏–∫–∞. –£ –ê–ú–î –≤ —ç—Ç–æ–º –ø–ª–∞–Ω–µ —á—É—Ç—å –∏–Ω–æ–π –ø–æ–¥—Ö–æ–¥ —Å —Å—Ç—Ä–µ—Ç—á–∏–Ω–≥–æ–º —á–∞—Å—Ç–æ—Ç –ø—Ä–∏ –Ω–µ—Ö–≤–∞—Ç–∫–µ –Ω–∞–ø—Ä—è–∂–µ–Ω–∏—è, –Ω–æ —Å—É—Ç—å —Ç–∞ –∂–µ –≥—Ä—É–±–æ –≥–æ–≤–æ—Ä—è. –¢–æ –µ—Å—Ç—å –µ—Å–ª–∏ –∂–∞—Ç—å –ª–∏–º–∏—Ç—ã –ø–æ –ø–æ—Ç—Ä–µ–±–ª–µ–Ω–∏—é —Ç–æ –ø—Ä–æ—Ü –±—É–¥–µ—Ç –≤—Å–µ–≥–¥–∞ —É—Å–ø–µ–≤–∞—Ç—å —Å–æ—Ö—Ä–∞–Ω—è—Ç—å —Å—Ç–∞–±–∏–ª—å–Ω–æ—Å—Ç—å –ø—Ä–∏ –Ω–∞–≥—Ä—É–∑–∫–µ. –ê–Ω–¥–µ—Ä–≤–æ–ª—å—Ç —á–µ—Ä–µ–∑ –û—Ñ—Ñ—Å–µ—Ç –ø—Ä–æ—Å—Ç–æ –¥–∞–µ—Ç —á—É—Ç—å –ª—É—á—à–µ —Ä–µ–∑—É–ª—å—Ç–∞—Ç—ã —á–µ–º —É–∂–∏–º –ª–∏–º–∏—Ç–∞. –ö—Å—Ç–∞—Ç–∏... –¢–µ—Å—Ç–∏—Ç—å –æ—Ç–¥–µ–ª—å–Ω—ã–µ —è–¥—Ä–∞ –ø—Ä–æ—Ü–∞ –≤ Prime95 Smallest FFT - —É–¥–æ–±–Ω–æ. –ê–Ω–∞–ª–æ–≥ CoreCycler. –ß—Ç–æ –±—ã –ø–æ–Ω—è—Ç—å –Ω–∞—Å–∫–æ–ª—å–∫–æ —É–¥–∞—á–Ω–æ–µ –∫–∞–∂–¥–æ–µ —è–¥—Ä–æ. –í Intel XTU –ø–æ—Ç–æ–º –º–æ–∂–Ω–æ –¥–∞–∂–µ –æ—Ñ—Ñ—Å–µ—Ç –æ—Ç–Ω–æ—Å–∏—Ç–µ–ª—å–Ω–æ —Ç–µ–º–ø–µ—Ä–∞—Ç—É—Ä –∫–æ–Ω–∫—Ä–µ—Ç–Ω–æ–≥–æ —è–¥—Ä–∞ –Ω–∞—Å—Ç—Ä–æ–∏—Ç—å. –¢–æ –µ—Å—Ç—å –≤—ã–±—Ä–∞—Ç—å –≥–æ—Ä—è—á–∏–µ —è–¥—Ä–∞ –∏ —Å–Ω–∏–∑–∏—Ç—å –∏–º –º–Ω–æ–∂–∏—Ç–µ–ª—å. –ê —Å–∞–º—ã–º —Ö–æ–ª–æ–¥–Ω—ã–º –Ω–∞–æ–±–æ—Ä–æ—Ç –ø—Ä–∏–ø–æ–¥–Ω—è—Ç—å. –ù—É —ç—Ç–æ —É–∂–µ –µ—Å–ª–∏ –Ω–∞–¥–æ –¥–æ–∏—Ç—å –∫–∞–∂–¥—ã–π % —Å —á–∞—Å—Ç–æ—Ç. –Ω–µ, —É–∂–∏–º–∞—Ç—å –ª–∏–º–∏—Ç –Ω–µ —Ö–æ—á–µ—Ç—Å—è, —Ö–æ—á–µ—Ç—Å—è –∏–º–µ–Ω–Ω–æ –æ—Ñ—Ñ—Å–µ—Ç, –∏ 100% –¥–∞–ª–µ–µ —É–±–µ–¥–∏—Ç—å—Å—è –≤ —Å—Ç–∞–±–∏–ª—å–Ω–æ—Å—Ç–∏ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä–∞.

XTU —É –º–µ–Ω—è –Ω–µ —Ä–∞–±–æ—Ç–∞–µ—Ç - —Å—Ç–æ–∏—Ç –≥–∏–ø–µ—Ä–≤–∏–∑–æ—Ä HYPER-V.¬Ý –£ –≤–∞—Å –≤–∏–∂—É 5500 –ø–æ –≤—Å–µ–º —è–¥—Ä–∞–º? –í—ã —á—Ç–æ—Ç–æ –¥–µ–ª–∞–ª–∏ –¥–ª—è —ç—Ç–æ–≥–æ, –∏–ª–∏ –æ–Ω–æ —Å–∞–º–æ? |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –¶–∏—Ç–∞—Ç–∞ rainmangrizzli: –£ –≤–∞—Å –≤–∏–∂—É 5500 –ø–æ –≤—Å–µ–º —è–¥—Ä–∞–º? –í—ã —á—Ç–æ—Ç–æ –¥–µ–ª–∞–ª–∏ –¥–ª—è —ç—Ç–æ–≥–æ, –∏–ª–∏ –æ–Ω–æ —Å–∞–º–æ? –≠—Ç–æ —Å—Ç–æ–∫–æ–≤—ã–µ —á–∞—Å—Ç–æ—Ç—ã P-5.5Ghz + E-4.3Ghz. –û–Ω–∏ –≤ –ê–≤—Ç–æ, –Ω–∏–≥–¥–µ –Ω–µ –Ω–∞—Å—Ç—Ä–∞–∏–≤–∞–ª –∏—Ö. –ü–æ –∫—Ä–∞–π–Ω–µ–π –º–µ—Ä–µ –Ω–∞ ASUS Z790 TUF DDR4 –∏ MSI Z790 Tomahawk DDR4. ASRock Z790 PG Lightning/D4 –≤ —Å—Ç–æ–∫–µ –≤—ã–¥–∞–µ—Ç —Ç–æ–ª—å–∫–æ 4.9+3.9Ghz. –õ–∏–±–æ —Ç–∞–º –ë–∏–æ—Å –∫—Ä–∏–≤–æ–π –ª–∏–±–æ VRM –¥–æ—Ö–ª—ã–π –∏ –æ–≥—Ä–∞–Ω–∏—á–∏–≤–∞–µ—Ç –ø–∏—Ç–∞–ª–æ–≤–æ. –ù–µ –∑–Ω–∞—é. –ù–µ –±—ã–ª–æ –≤—Ä–µ–º–µ–Ω–∏ –≤–Ω–∏–∫–∞—Ç—å. –ü–ª–∞—Ç—É –ø—Ä–æ—Å—Ç–æ –ø–æ–º–µ–Ω—è–ª–∏ –Ω–∞ ASUS TUF. |

|

–ù–∞ —Å–∞–π—Ç–µ c 04.06.2010

–°–æ–æ–±—â–µ–Ω–∏–π: 3941

| –í–æ–æ–±—â–µ

–µ–≥–æ –Ω–µ –±–µ—Ä—É—Ç —á—Ç–æ –ª–∏ —Ç–∞–º ). –£ –ê–ú–î –æ—Å—Ç–∞–ª—Å—è –ø–æ—Å–ª–µ–¥–Ω–∏–π –∫–æ–∑—ã—Ä—å¬Ý‚Äî Ryzen 7000X3D V-Cache. |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –Ø –≤—Å–µ –∂–µ –ø–µ—Ä–µ–¥–∞–ª —Å—Ü–µ–Ω—É –Ω–∞ —Å–≤–æ–π —Ç–µ—Å—Ç —Å 13900KF - –æ–≥—Ä–∞–Ω–∏—á–µ–Ω–Ω–æ–º—É –∫—Ä—É–≥—É –ª—é–¥–µ–π. –ù–µ —Ö–æ—Ç–µ–ª–æ—Å—å –±—ã —Å—é–¥–∞ –µ–µ –ø—É–±–ª–∏–∫–æ–≤–∞—Ç—å. –ü—Ä–æ—Å—Ç —Ö–æ—Ç–µ–ª –º–µ—Ç–æ–¥–æ–ª–æ–≥–∏—é –ø–æ–∫–∞–∑–∞—Ç—å, –µ—Å–ª–∏ –≤–¥—Ä—É–≥ –∫–æ–º—É –∏–Ω—Ç–µ—Ä–µ—Å–Ω–æ –±—ã–ª–æ —á—Ç–æ –∫–∞–∫ –¥–µ–ª–∞–ª –∫–æ–≥–¥–∞ —Å—Ä–∞–≤–Ω–∏–≤–∞–ª 5900–• –∏ 13900KF

. https://youtu.be/Zo2Ico8Dqn0 ¬Ý –ï—Å–ª–∏ –≤–¥—Ä—É–≥ - –æ–∫–∞–∂–µ—Ç—Å—è —á—Ç–æ –∫—Ç–æ —Ç–æ —Å–º–æ–∂–µ—Ç –ø–æ–≤—Ç–æ—Ä–∏—Ç—å –≤—Å–µ —ç—Ç–æ (–∫–æ–º—É —è –ø–µ—Ä–µ–¥–∞–ª —Å—Ü–µ–Ω—É), —è –æ—Ç–ø–∏—à—É—Å—å —Å —Ä–µ–∑—É–ª—å—Ç–∞—Ç–∞–º–∏ —Ç—É—Ç. –ù–∞–¥–µ–∂–¥–∞ –Ω–∞ —ç—Ç–æ –Ω–µ–≤–µ–ª–∏–∫–∞. –¶–µ–ª–∏ –¥–µ–ª–∞—Ç—å –≤—Å–µ —ç—Ç–æ –¥–ª—è —à–∏—Ä–æ–∫–æ–≥–æ –∫—Ä—É–≥–∞ –ª—é–¥–µ–π —á—Ç–æ –±—ã –∫–∞–∂–¥—ã–π –ø–æ–≤—Ç–æ—Ä–∏—Ç—å –º–æ–≥ - –Ω–µ –±—ã–ª–æ. –î–∞... –ö—Å—Ç–∞—Ç–∏. –Ø –ø—Ä–æ–≤–µ—Ä–∏–ª –ø–æ–≤–µ—Ä—Ö–Ω–æ—Å—Ç–Ω–æ —Ä–∞–∑–≥–æ–Ω –ø–∞–º—è—Ç–∏ —Å 3200Mhz/CL16 XMP-Auto –¥–æ 3866/CL16-CR1 Gear1 —Å –ø–æ–¥–∂–∞—Ç—ã–º–∏ –≤—Ç–æ—Ä–∏—á–∫–∞–º–∏ - –î–ê–ï–¢ –ø—Ä–∏—Ä–æ—Å—Ç –æ—Ç–∑—ã–≤—á–∏–≤–æ—Å—Ç–∏ –≤ 3Ds Max, –º–µ—Å—Ç–∞–º–∏ –Ω–µ–±–æ–ª—å—à–æ–π, –º–µ—Å—Ç–∞–º–∏ –æ—â—É—Ç–∏–º—ã–π. –ü–æ–∫–∞ –±–µ–∑ —Ç–æ—á–Ω—ã—Ö —Ü–∏—Ñ—Ä. –ù–µ—Ç—É –Ω–∞ —ç—Ç–æ –≤—Ä–µ–º–µ–Ω–∏. –ù–æ –¥–∞... –í–æ—Ç –≤–∞–º –∏ "–±–µ—Å–ø–æ–ª–µ–∑–Ω—ã–π" —Ä–∞–∑–≥–æ–Ω –ø–∞–º—è—Ç–∏. –í—ã–¥–µ–ª–µ–Ω–∏–µ –æ–±—ä–µ–∫—Ç–æ–≤ —É—Å–∫–æ—Ä–∏–ª–æ—Å—å –Ω–∞ ~10%, –æ—Ç–∫—Ä—ã—Ç–∏–µ MTL –≠–¥–∏—Ç–æ—Ä–∞ –∏ –ê—Ç—Ç–∞—á –û–±—ä–µ–∫—Ç–æ–≤ ~15%, –æ—Å—Ç–∞–ª—å–Ω–æ–µ —á—Ç–æ –ø–æ–∫–∞–∑–∞–ª –≤ –≤–∏–¥–µ–æ ~0-5%. –¢–∞–∫ –∂–µ —Å—Ç–æ–∏—Ç –æ—Ç–º–µ—Ç–∏—Ç—å —á—Ç–æ –¥–µ–ª–æ –Ω–µ –≤ –ü–°–ü –∞ —Å–∫–æ—Ä–µ–µ –≤ Latency, –ø–æ–≤—Ç–æ—Ä–∏–ª —Ç–µ—Å—Ç—ã —Å –∑–∞–≤—ã—à–µ–Ω–Ω—ã–º tCWL/CL –Ω–æ —É–∂–∞—Ç—ã–º–∏ –≤—Ç–æ—Ä–∏—á–∫–∞–º–∏ (—á—Ç–æ –±—ã –ü–°–ü —Å–Ω–∏–∑–∏—Ç—å –Ω–æ –∏ —á—Ç–æ –±—ã Latency —Å–Ω–∏–∑–∏—Ç—å —Ç–æ–∂–µ), –ø–æ–ª—É—á–∏–ª –ø—Ä–∏–º–µ—Ä–Ω–æ —Ç–æ—Ç –∂–µ —Ä–µ–∑—É–ª—å—Ç–∞—Ç —á—Ç–æ –∏ —Å –±–æ–ª–µ–µ –≤—ã—Å–æ–∫–∏–º –ü–°–ü. –≠—ã... –ï—Å–ª–∏ –Ω–∏–≥–¥–µ –Ω–µ –Ω–∞–∫–æ—Å—è—á–∏–ª, –ø–æ–ª—É—á–∞–µ—Ç—Å—è —á—Ç–æ –æ—Ç –Ω–∞—Å—Ç—Ä–æ–µ–Ω–Ω–æ–π DDR4 –±—É–¥–µ—Ç –±–æ–ª—å—à–µ –ø—Ä–æ—Ñ–∏—Ç–∞ —á–µ–º –æ—Ç DDR5 –≤ –ø–ª–∞–Ω–µ –≤–∑–∞–∏–º–æ–¥–µ–π—Å—Ç–≤–∏—è —Å 3Ds Max. –ü–æ—Ç–æ–º—É —á—Ç–æ DDR5 –¥–∞–µ—Ç —Ö–æ—Ç—å –∏ –≤—ã—à–µ –ü–°–ü (–æ—Ç –∫–æ—Ç–æ—Ä–æ–≥–æ —Ç–æ–ª–∫—É –Ω–µ—Ç—É –≤ 3Ds Max –ø–æ –º–æ–∏–º –∑–∞–º–µ—Ä–∞–º) –Ω–æ –ø—Ä–∏ —ç—Ç–æ–º –∑–∞–≤—ã—à–∞–µ—Ç –∑–∞–¥–µ—Ä–∂–∫–∏ (–∫–æ—Ç–æ—Ä—ã–µ –ø–æ—Ö–æ–∂–µ –∏ –≤–ª–∏—è—é—Ç –Ω–∞¬Ý –æ—Ç–∑—ã–≤—á–∏–≤–æ—Å—Ç—å —á–∞—Å—Ç–∏ –∏–Ω—Å—Ç—Ä—É–º–µ–Ω—Ç–æ–≤ –≤ 3Ds Max). –ö —Å–æ–∂–∞–ª–µ–Ω–∏—é —É –Ω–∞—Å –≤ –£–∫—Ä–∞–∏–Ω–µ —Ç—Ä–∞–±–ª—ã —Å–µ–π—á–∞—Å —Å —ç–ª–µ–∫—Ç—Ä–∏—á–µ—Å—Ç–≤–æ–º, –∏ —è –Ω–µ –º–æ–≥—É –ø–æ –ø–æ–ª–Ω–æ–π –≤—Å–µ –∑–∞—Ç–µ—Å—Ç–∏—Ç—å. –ü–æ–¥—Å—á–∏—Ç–∞—Ç—å. –ù–µ –¥–æ —ç—Ç–æ–≥–æ, 2-4 —á–∞—Å–∞ –≤ —Å—É—Ç–∫–∏ —Å–≤–µ—Ç–∞. –ù–æ –ø—Ä–µ–¥–≤–∞—Ä–∏—Ç–µ–ª—å–Ω—ã–µ –≤—ã–≤–æ–¥—ã –¥—É–º–∞—é —è —É–∂–µ —Å–¥–µ–ª–∞–ª, –ø–æ—Ç–æ–º—É —á—Ç–æ —Ä–µ–∑—É–ª—å—Ç–∞—Ç—ã –ø–æ–≤—Ç–æ—Ä—è–µ–º—ã–µ –ø—Ä–æ—Å—Ç—ã–º –ø–µ—Ä–µ–∫–ª—é—á–µ–Ω–∏–µ–º –ø—Ä–æ—Ñ–∏–ª–µ–π –≤ –ë–∏–æ—Å–µ –∏ –ø–æ–≤—Ç–æ—Ä–æ–º –∑–∞–º–µ—Ä–æ–≤. –Ø –µ—â–µ –ª–µ—Ç —ç–¥–∞–∫ –ø—è—Ç—å –Ω–∞–∑–∞–¥ —Ç—É—Ç –Ω–∞ —Ñ–æ—Ä—É–º–µ –ø–∏—Å–∞–ª –Ω–∞ —ç—Ç—É —Ç–µ–º—É –Ω–æ –≤—Å–µ –Ω–∏–∫–∞–∫ —Ä—É–∫–∏ –Ω–µ –¥–æ—Ö–æ–¥–∏–ª–∏ —Å—Ä–∞–≤–Ω–∏—Ç—å –≤—Å–µ —ç—Ç–æ. UPD¬Ý(29-–ù–æ—è–±—Ä—è) -¬Ý–ø–æ–º–Ω—é –µ—â–µ –¥–∞–≤–Ω–µ–Ω—å–∫–æ —è –ø–∏—Å–∞–ª –ø—Ä–æ –∞–Ω–∞–ª–æ–≥ FIVR

, –∏ —á—Ç–æ –Ý–∞–ø—Ç–æ—Ä—ã –±—É–¥—É—Ç –∂—Ä–∞—Ç—å –º–µ–Ω—å—à–µ –ø–∏—Ç–∞–Ω–∏—è. –¢–æ–ª—å–∫–æ –≤–æ—Ç –∫–∞–∫ —Ç–æ –∑–∞–±—ã–ª –ø—Ä–æ —ç—Ç–æ –≤—Å–µ. –ê —Å–µ–π—á–∞—Å –≤–æ—Ç —Ç–∞–∫–∞—è –≤–æ—Ç –Ω–æ–≤–æ—Å—Ç—å -¬Ýhttps://3dnews.ru/1078087/publikatsiya-1078087 ¬Ý –¶–∏—Ç–∞—Ç–∞ - "Intel —è–∫–æ–±—ã —Ä–∞–±–æ—Ç–∞–µ—Ç –Ω–∞–¥ –æ–±–Ω–æ–≤–ª—ë–Ω–Ω—ã–º–∏ —á–∏–ø–∞–º–∏ Raptor Lake Refresh. –ü—Ä–µ–¥–ø–æ–ª–æ–∂–∏—Ç–µ–ª—å–Ω–æ –∏–º–µ–Ω–Ω–æ –æ–Ω–∏ –∑–∞ —Å—á—ë—Ç —Ñ—É–Ω–∫—Ü–∏–∏ DLVR —Å–º–æ–≥—É—Ç –ø—Ä–µ–¥–ª–æ–∂–∏—Ç—å –¥–æ 20 % –±–æ–ª–µ–µ –Ω–∏–∑–∫–æ–µ —ç–Ω–µ—Ä–≥–æ–ø–æ—Ç—Ä–µ–±–ª–µ–Ω–∏–µ –ø–æ —Å—Ä–∞–≤–Ω–µ–Ω–∏—é —Å –∞–∫—Ç—É–∞–ª—å–Ω—ã–º–∏ –º–æ–¥–µ–ª—è–º–∏ Raptor Lake." UPD (1-–î–µ–∫–∞–±—Ä—è) - –º–º–º... –ò–Ω—Ç–µ—Ä–µ—Å–Ω–µ–Ω—å–∫–æ. –î–∏–Ω–∞–º–∏—á–µ—Å–∫–∏–π —Ä–µ–∂–∏–º LLC. https://wccftech.com/msi-intros-loadline-saturation-on-z790-motherboards-maxing-out-single-multi-core-performance-on-intel-cpus/ |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –¶–∏—Ç–∞—Ç–∞ Holy3D: –ù—É–∂–Ω–∞ –Ω–æ–≤–∞—è –ø–ª–∞—Ç—Ñ–æ—Ä–º–∞ –Ω–∞ 3 –≥–æ–¥–∞. –ó–∞—á–µ–º –Ω–æ–≤–∞—è –ø–ª–∞—Ç—Ñ–æ—Ä–º–∞ –∏ –ø–æ—á–µ–º—É –∏–º–µ–Ω–Ω–æ –Ω–∞ 3 –≥–æ–¥–∞ ? –í —á–µ–º –ø—Ä–æ–±–ª–µ–º–∞ –Ω–∞ 5950–• –∏ DDR4 —Å–∏–¥–µ—Ç—å 3 –≥–æ–¥–∞ ? –ù–µ –ø–æ–π–º—É... –ë–µ—Ä–µ—Ç–µ 5950–•/7950X/13900K –∏ —Å–∏–¥–∏—Ç–µ —Å–µ–±–µ 3 –≥–æ–¥–∞. –ò–ª–∏ —É –≤–∞—Å —Ç–∞–º —Å—Ä–æ–∫ –≥–æ–¥–Ω–æ—Å—Ç–∏ –Ω–∞ –ø—Ä–æ—Ü—ã –∏—Å—Ç–µ–∫–∞–µ—Ç

¬Ý –ï—Å–ª–∏ –∏ –∏–Ω–≤–µ—Å—Ç–∏—Ä–æ–≤–∞—Ç—å –≤ DDR5, —Ç–æ –∂–¥–∞—Ç—å Hynix A-Die –≤ –Ω–∞—á–∞–ª–µ-—Å–µ—Ä–µ–¥–∏–Ω–µ —Å–ª–µ–¥—É—é—â–µ–≥–æ –≥–æ–¥–∞. –í –ø–ª–∞–Ω–µ –∫–∞—á–µ—Å—Ç–≤–∞ –∫–æ–Ω—Ç—Ä–æ–ª–ª–µ—Ä–∞ –ø–∞–º—è—Ç–∏ –º–µ–∂–¥—É Alder Lake –∏ Raptor Lake —É DDR5 —Å—É–¥—è –ø–æ –≤—Å–µ–º—É —Ä–∞–∑–Ω–∏—Ü—ã –Ω–∞–∫–∞–ø–∞–ª–æ –Ω–∞ 400–º–≥—Ü. –ò –∫–∞–∫ –æ–Ω–æ –±—É–¥–µ—Ç —É Meteor Lake –∏ Zen5 - –Ω–µ–∏–∑–≤–µ—Å—Ç–Ω–æ. –ß–∞—Å—Ç–æ—Ç–∞ XMP –ø–ª–∞—à–µ–∫ —Å–µ–π—á–∞—Å —Å–∏–ª—å–Ω–æ –æ–±–≥–æ–Ω—è–µ—Ç –≤–æ–∑–º–æ–∂–Ω–æ—Å—Ç–∏ –∫–æ–Ω—Ç—Ä–æ–ª–ª–µ—Ä–∞ –ø—Ä–∏ —Ä–∞–±–æ—Ç–µ —Å —á–µ—Ç—ã—Ä—å–º—è –ø–ª–∞—à–∫–∞–º–∏. –ú–æ–∂–µ—Ç —ç—Ç–æ –∫–∞–∫ —Ç–æ –ø—Ä–æ—Å—Ç–∏–º—É–ª–∏—Ä—É–µ—Ç AMD/Intel, –ø—Ä–æ—Ä–∞–±–æ—Ç–∞—Ç—å —ç—Ç–æ—Ç –º–æ–º–µ–Ω—Ç. –ü–æ–∫–∞ —á—Ç–æ –æ–Ω–∏ –Ω–∏—á–µ–≥–æ –ª—É—á—à–µ —á–µ–º Gear4 –∏ Uncoupled Mode –Ω–µ –ø—Ä–∏–¥—É–º–∞–ª–∏. –ò —Ç–æ... –ö–æ—Å—Ç—ã–ª—å –¥–ª—è —Ç–µ—Ö –∫–æ–º—É –≤–æ–æ–±—â–µ –ø–æ—Ñ–∏–≥ –Ω–∞ –∑–∞–¥–µ—Ä–∂–∫–∏ –ø–∞–º—è—Ç–∏, –∫–æ–º—É –Ω–∞–¥–æ –ü–°–ü –ª—é–±–æ–π —Ü–µ–Ω–æ–π. –ê –≤–æ–æ–±—â–µ... –Ø –±—ã —Å–µ–π—á–∞—Å –∏–Ω–≤–µ—Å—Ç–∏—Ä–æ–≤–∞–ª –≤ nVidia A6000 48GB

¬Ý(–Ω—É –∏–ª–∏ 3090-4090) –∏ —É—Ö–æ–¥–∏–ª –±—ã –Ω–∞ –ê–Ω—Ä–∏–∞–ª –∏–ª–∏ GPU —Ä–µ–Ω–¥–µ—Ä—ã. |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| Holy3D, –≤ —Å–º—ã—Å–ª–µ –ò–Ω—Ç–µ–ª "–Ω–µ—Ç" ? –ü–æ—á–µ–º—É –Ω–µ—Ç ? –£ –ê–ú–î –º–æ–Ω–æ–ø–æ–ª–∏—è –Ω–∞ –≤—ã–ø—É—Å–∫ —Ö–∏—Ç–æ–≤ ? –ü—Ä–æ –∏–∑–º–µ–Ω–µ–Ω–∏—è –≤ —Ç–µ—Ö–ø—Ä–æ—Ü–µ—Å—Å–µ Meteor Lake : https://www.youtube.com/watch?v=frSbMp8KQ9Q& ;t=703s –≠—Ç–æ–º—É –≤–∏–¥–µ–æ 5 –º–µ—Å—è—Ü–µ–≤ –∞ –æ—Ç–∫—Ä—ã—Ç–æ–π –¥–æ–∫—É–º–µ–Ω—Ç–∞—Ü–∏–∏ –±–æ–ª—å—à–µ –≥–æ–¥–∞. –ê –ø—Ä–æ—Ü—ã —ç—Ç–∏ –≤—ã–π–¥—É—Ç —á–µ—Ä–µ–∑ –≥–æ–¥. –î—É–º–∞—é –≤—ã –ø–æ–Ω–∏–º–∞–µ—Ç–µ —á—Ç–æ - –≤—Ä–µ–º—è –º–µ–∂–¥—É –≤—ã–ø—É—Å–∫–æ–º –∞—Ä—Ö–∏—Ç–µ–∫—Ç—É—Ä—ã –∏ –µ–µ —Ä–∞–∑—Ä–∞–±–æ—Ç–∫–æ–π –∏ —É—á–µ—Ç–æ–º –æ—à–∏–±–æ–∫ - –∑–Ω–∞—á–∏—Ç–µ–ª—å–Ω–æ –±–æ–ª—å—à–µ —á–µ–º –º–æ–∂–µ—Ç –ø–æ–∫–∞–∑–∞—Ç—å—Å—è. –£—Å–ª–æ–≤–Ω–æ –≥–æ–≤–æ—Ä—è Zen4 –Ω–∞ –±—É–º–∞–≥–µ –±—ã–ª–∏ —Å–¥–µ–ª–∞–Ω—ã –µ—â–µ 3-4 –≥–æ–¥–∞ –Ω–∞–∑–∞–¥ –∞ —É–≥—Ä–æ–∑–∞ —Å–æ —Å—Ç–æ—Ä–æ–Ω—ã –ò–Ω—Ç–µ–ª–∞ –±—ã–ª–∞ –æ—Å–æ–∑–Ω–∞–Ω–∞ –ª–∏—à—å –≤ –ø—Ä–æ—à–ª–æ–º –≥–æ–¥—É. –≠—Ç–æ —Ç–∞–∫ –Ω–µ —Ä–∞–±–æ—Ç–∞–µ—Ç —á—Ç–æ –æ–Ω–∏ –≤—ã–ø—É—Å—Ç–∏–ª–∏ –ø—Ä–æ—Ü, —á–µ—Ä–µ–∑ –≥–æ–¥ —É–∂–µ —á—Ç–æ —Ç–æ –∏—Å–ø—Ä–∞–≤–∏–ª–∏ )) –ù—É –∏–ª–∏ –≤–æ–æ–±—â–µ –æ—à–∏–±–∫–∏ (—Å–ª–∞–±—ã–µ –º–µ—Å—Ç–∞) –º–æ–≥—É—Ç —É—á–µ—Å—Ç—å –µ—â–µ –¥–æ –≤—ã–ø—É—Å–∫–∞ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä–æ–≤. –ù–æ –∏—Å–ø—Ä–∞–≤–∏—Ç—å —Ç–æ–ª—å–∫–æ —á–µ—Ä–µ–∑ –ø–∞—Ä—É –ª–µ—Ç. –ù–∞–ø—Ä–∏–º–µ—Ä —É—è–∑–≤–∏–º–æ—Å—Ç–∏ Spectre/Meltdown —É –ò–Ω—Ç–µ–ª –∏—Å–ø—Ä–∞–≤–∏–ª–∏ –Ω–∞ —Ö–∞—Ä–¥–≤–µ—Ä–Ω–æ–º —É—Ä–æ–≤–Ω–µ –ø–æ –º–æ–µ–º—É —á–µ—Ä–µ–∑ 5-6 –ª–µ—Ç —Ç–æ–ª—å–∫–æ. –ï—Å–ª–∏ —É–∂ –≤–∞–º –ø—Ä—è–º –Ω–∞—Å—Ç–æ–ª—å–∫–æ –ø—Ä–∏—Å–ø–∏—á–∏—Ç –∫–∞–∂–¥—ã–π –≥–æ–¥ –æ–±–Ω–æ–≤–ª—è—Ç—å –ø—Ä–æ—Ü—ã —Ç–æ –Ω–µ –≤–∏–∂—É –Ω–∏ –µ–¥–∏–Ω–æ–π –ø—Ä–∏—á–∏–Ω—ã –ø—Ä–æ—Å—Ç–æ –≤–∑—è—Ç—å –≤—ã–∫–∏–Ω—É—Ç—å –ø–ª–∞—Ç—É –Ω–∞ –∫–∞–∫–æ–µ –Ω–∏—Ç—å –ê–≤–∏—Ç–æ/OLX, –∏ –∫—É–ø–∏—Ç—å –Ω–æ–≤—É—é. –í —Ç–∞–∫–æ–º —Ä–∞—Å–∫–ª–∞–¥–µ –ø–æ—Ç–µ—Ä—è –ø–æ –¥–µ–Ω—å–≥–∞–º - –º–∏–∑–µ—Ä–Ω–∞—è, –ø–æ—Ç–µ—à–Ω–∞—è. –¢–∏–ø–∞ –∫—É–ø–∏–ª –ø–ª–∞—Ç—É –∑–∞ 350$ –ø–æ—Ç–æ–º –ø—Ä–æ–¥–∞–ª –∑–∞ 250$, –¥–æ–±–∞–≤–∏–ª–∏ 100$ –∏ –∫—É–ø–∏–ª –Ω–æ–≤—É—é. –¶–∏—Ç–∞—Ç–∞ Holy3D: –ü–æ—ç—Ç–æ–º—É –∏ –≤–æ–ø—Ä–æ—Å - –≤ –∫–∞–∫–æ–π –±—Ä–µ–Ω–¥ –∏–Ω–≤–µ—Å—Ç–∏—Ä–æ–≤–∞—Ç—å? –í nVidia –æ—á–µ–≤–∏–¥–Ω–æ. –ë—Ä–∞—Ç—å A6000 –∏–ª–∏ 3090-4090 –∏ —É—Ö–æ–¥–∏—Ç—å –Ω–∞ GPU-–Ý–µ–Ω–¥–µ—Ä—ã –∏–ª–∏ –Ý–µ–∞–ª—Ç–∞–π–º –≥—Ä–∞—Ñ–∏–∫—É )) –ò —á—Ç–æ –∑–Ω–∞—á–∏—Ç –≤–æ–æ–±—â–µ –∏–Ω–≤–µ—Å—Ç–∏—Ä–æ–≤–∞—Ç—å. –ë—É–¥—Ç–æ –≤—ã –ø–æ–∫—É–ø–∞–µ—Ç–µ –Ω–µ–¥–≤–∏–∂–∏–º–æ—Å—Ç—å –∫–∞–∫—É—é —Ç–æ... –¢—É—Ç –Ω–µ –Ω–∞–¥–æ –¥—É–º–∞—Ç—å –ø—Ä–æ –∏–Ω–≤–µ—Å—Ç–∏—Ü–∏–∏, —Ç—É—Ç —Å–∏—é–º–∏–Ω—É—Ç–Ω–∞—è –ø—Ä–∏–±–∞–≤–∫–∞ –∫ —Å–∫–æ—Ä–æ—Å—Ç–∏ –∫–æ—Ç–æ—Ä–∞—è –≤–∞–º –Ω–µ–æ–±—Ö–æ–¥–∏–º–∞. –ê –≤ –±—É–¥—É—â–µ–º –≤ –ª—é–±–æ–º —Å–ª—É—á–∞–µ –ø—Ä–æ–¥–∞–∂–∞ —Å—Ç–∞—Ä–æ–≥–æ –∏ –ø–æ–∫—É–ø–∫–∞ –Ω–æ–≤–æ–≥–æ –∫–æ–≥–¥–∞ –≤–∞–º —ç—Ç–æ —Å—Ç–∞–Ω–µ—Ç –Ω—É–∂–Ω–æ. –£—Å–ª–æ–≤–Ω–æ –≥–æ–≤–æ—Ä—è –µ—Å–ª–∏ –≤–¥—Ä—É–≥ Zen5 –∏ Meteor Lake –≤—ã–π–¥—É—Ç —Å—É–ø–µ—Ä –∫—Ä—É—Ç—ã–º–∏... –ê –≤–∞–º –±—É–¥–µ—Ç —Ö–≤–∞—Ç–∞—Ç—å –Ω—ã–Ω–µ—à–Ω–µ–≥–æ 5950X/7950X/13900K - —Ç–æ –Ω–∞—Ñ–∏–≥–∞ –∏—Ö –º–µ–Ω—è—Ç—å —Ç–æ. –ü—Ä–æ—Å—Ç–æ —Å–∏–¥–∏—Ç–µ —Å–µ–±–µ –¥–∞–ª—å—à–µ –¥–æ Arrow Lake, Zen6, –¥–µ–ª–æ–≤ —Ç–æ... –ë—É–¥—Ç–æ –≤–∞—Å –æ–±–≥–æ–Ω–∏—Ç –∫—Ç–æ —Ç–æ –µ—Å–ª–∏ –≤—ã –≤–æ–≤—Ä–µ–º—è –Ω–µ –æ–±–Ω–æ–≤–∏—Ç–µ—Å—å )) –ù—É –ª–∞–¥–Ω–æ... –ü–æ —ç—Ç–æ–º—É –≤–æ–ø—Ä–æ—Å—É –º–Ω–µ –Ω–µ—á–µ–≥–æ –¥–æ–±–∞–≤–∏—Ç—å. –ù–µ –∑–Ω–∞—é —á—Ç–æ —Ç—É—Ç —Å–∫–∞–∑–∞—Ç—å. –í–∫–ª—é—á–∞—Ç—å —Ç–æ–≥–¥–∞ –∂–¥—É–Ω–∞ –∏ –∂–¥–∞—Ç—å –•–∏—Ç–∞ –æ—Å—Ç–∞–µ—Ç—Å—è —Ä–∞–∑–≤–µ —á—Ç–æ. –ü–æ—Ç–æ–º—É —á—Ç–æ —Å–µ–π—á–∞—Å - –ø–∞—Ä–∏—Ç–µ—Ç. |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –°–æ—Ä—è–Ω –∑–∞ –æ—Ñ—Ñ—Ç–æ–ø Holy3D,¬Ý–ø–∞—Ä—É –Ω–µ–¥–µ–ª—å –Ω–∞–∑–∞–¥ –≤—ã—à–µ–ª UE5.1 –≤ –∫–æ—Ç–æ—Ä–æ–º –ù–∞–Ω–∏—Ç—ã –Ω–∞—É—á–∏–ª–∏—Å—å —Ä–∞–±–æ—Ç–∞—Ç—å —Å Lumen –≤ —Ä–µ–∂–∏–º–µ Two Sided Foliage, –¥—É–º–∞—é —ç—Ç–æ —É–∂–µ –≤—Å–µ –æ—á–µ–Ω—å —Å–∫–æ—Ä–æ –ø—Ä–æ–∏–∑–æ–π–¥–µ—Ç )) –ù—É –µ—Å–ª–∏ –∏–Ω—Ç–µ—Ä–µ—Å–Ω–æ –º–æ–∂–µ—Ç–µ –≥–ª—è–Ω—É—Ç—å -¬Ýhttps://youtu.be/FUGqzE6Je5c ¬Ý –Ø –Ω–∞ RTX 3080 –Ω–∞–ø–∏—Ö–∞–ª —Ç–æ–Ω–Ω—É –Ω–µ–æ–ø—Ç–∏–º–∏–∑–∏—Ä–æ–≤–∞–Ω–Ω—ã—Ö –∞—Å—Å–µ—Ç–æ–≤ –¥–µ—Ä–µ–≤—å–µ–≤ (—Å–∞–º—ã—Ö —Ç—è–∂–µ–ª—ã—Ö —á—Ç–æ –Ω–∞—à–µ–ª). –í–∑—è–ª Quixel Leaf –º–∞—Å—Ç–µ—Ä –º–∞—Ç–µ—Ä–∏–∞–ª —Å Wind-–æ–º. –ó–∞—Ñ–∏–≥–∞—á–∏–ª 500 –º–∏–ª–ª–∏–∞—Ä–¥–æ–≤ —Ç—Ä–∏—Å–æ–≤ (–Ω–µ –æ–ø–µ—á–∞—Ç–∫–∞) –≤ –≤—å—é–ø–æ—Ä—Ç–µ —á–µ—Ä–µ–∑ Foliage-Scatter –∏ –Ω–æ—Ä–º —Å High –ø—Ä–µ—Å–µ—Ç–æ–º –≤ 1440p —Ä–∞–±–æ—Ç–∞–µ—Ç —Å 40-50FPS. –í Epic –ø—Ä–µ—Å–µ—Ç–µ —É–∂–µ –Ω–µ –æ—Å–æ–±–æ –ø—Ä–∏—è—Ç–Ω–æ 20-30FPS, –æ—Å–æ–±–µ–Ω–Ω–æ –∫–æ–≥–¥–∞ –Ω–∞ –ø–æ–ª–Ω–æ–π —Å–∫–æ—Ä–æ—Å—Ç–∏ –ª–µ—Ç–∏—à—å —á–µ—Ä–µ–∑ –ª–µ—Å. –•–æ—Ç—è —ç—Ç–æ —è —è–≤–Ω–æ –≤–∑—è–ª —Å –ø–µ—Ä–µ–±–æ—Ä–æ–º )) –ù–∞–≤—Ä—è–¥ –ª–∏ –∫—Ç–æ —Ç–æ –±—É–¥–µ—Ç –≤—Å—é–¥—É –∫–∏–¥–∞—Ç—å –¥–µ—Ä–µ–≤—å—è –ø–æ 20 –ª–∏–º–æ–Ω–æ–≤ —Ç—Ä–∏—Å–æ–≤ –∑–¥–æ—Ä–æ–≤–µ–Ω–Ω—ã–µ )) –¢–∞–∫ —á—Ç–æ –≤ –ø–ª–∞–Ω–µ —á–∏—Å—Ç–æ –æ–±—ä–µ–º–∞ –≥–µ–æ–º–µ—Ç—Ä–∏–∏ –≤ –≤—å—é–ø–æ—Ä—Ç–µ - –Ω–æ—É –ø—Ä–æ–±–ª–µ–º. –°–µ–π—á–∞—Å –≤–æ—Ç –Ω–∞–¥–æ —Ç–æ–ª—å–∫–æ –æ–ø—Ä–µ–¥–µ–ª–∏—Ç—Å—è —Å –ø–æ—Ç—Ä–µ–±–ª–µ–Ω–∏–µ–º –≤–∏–¥–µ–æ–ø–∞–º—è—Ç–∏

. –ê —Ç–æ –Ω–µ–ø–æ–Ω—è—Ç–Ω–æ... –ü—É—Å—Ç–æ–π —Ä–µ–¥–∞–∫—Ç–æ—Ä –∂—Ä–µ—Ç 6–≥–± VRAM, –∑–∞–∫–∏–¥—ã–≤–∞—é —Ç–æ–Ω–Ω—ã –ú–µ–≥–∞—Å–∫–∞–Ω–æ–≤, —Ç–µ–∫—Å—Ç—É—Ä –∏ —Ç—è–∂–µ–ª—ã—Ö –æ–±—ä–µ–∫—Ç–æ–≤ –æ–Ω –Ω–∞—á–∏–Ω–∞–µ—Ç –∂—Ä–∞—Ç—å –≤—Å–µ–≥–æ –Ω–∞ 1-1.5–≥–± VRAM –±–æ–ª—å—à–µ. –ë—É–¥—Ç–æ –±–æ–ª—å—à–∞—è —á–∞—Å—Ç—å –æ–±—ä–µ–∫—Ç–æ–≤ —Å—Ç—Ä–∏–º–∏—Ç—å—Å—è —Å –∫–∞–∫–æ–≥–æ —Ç–æ –∫—ç—à–∞ –Ω–∞ –≤–∏–Ω—á–µ—Å—Ç–µ—Ä–µ... –í–æ—Ç —Å–µ–π—á–∞—Å —É –º–µ–Ω—è –Ω–µ–∑–∞–ø–ª–∞–Ω–∏—Ä–æ–≤–∞–Ω–Ω—ã–π –æ—Ç–ø—É—Å–∫. –î—É–º–∞—é –∫–∞–∫ —Ä–∞–∑ –≤ UE5.1 —á—Ç–æ —Ç–æ —Å–æ–±—Ä–∞—Ç—å —á—Ç–æ –±—ã –ø–æ–Ω—è—Ç—å –ª–∏–º–∏—Ç—ã —á–µ–≥–æ –º–æ–∂–Ω–æ —Å–¥–µ–ª–∞—Ç—å. –Ý–∞–∑—É–º–µ–µ—Ç—Å—è –Ω–µ –≤ –∏–Ω—Ç–µ—Ä–∞–∫—Ç–∏–≤–µ. |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| Holy3D, —è –∂–µ –≥–æ–≤–æ—Ä—é - –Ω–∞–¥–æ —Å–Ω–∞—á–∞–ª–∞ —Å–∞–º–æ–º—É –ø–æ–ø—Ä–æ–±–æ–≤–∞—Ç—å —Å–æ–±—Ä–∞—Ç—å —á—Ç–æ-—Ç–æ –∞ –ø–æ—Ç–æ–º –¥–µ–ª–∞—Ç—å –≤—ã–≤–æ–¥—ã. –ö–∞–∫ —è –º–æ–≥—É –æ—Ç–≤–µ—Ç–∏—Ç—å –≤–∞–º –Ω–∞ —ç—Ç–∏ –≤–æ–ø—Ä–æ—Å—ã –µ—Å–ª–∏ —è –µ—â–µ –Ω–∏—á–µ–≥–æ –Ω–µ —Å–æ–±—Ä–∞–ª –∏ –Ω–µ —Å–¥–µ–ª–∞–ª –∞ UE –≤ —Ä–∞—Å—Ç–µ–Ω–∏—è –Ω–µ–æ–ø—Ç–∏–º–∏–∑–∏—Ä–æ–≤–∞–Ω–Ω—ã–µ –Ω–∞—É—á–∏–ª—Å—è —Ç–æ–ª—å–∫–æ –ø–∞—Ä—É –Ω–µ–¥–µ–ª—å –Ω–∞–∑–∞–¥. –Ø –∂–µ –Ω–µ –í–∞–Ω–≥–∞ –∫–∞–∫–∞—è —Ç–æ... –Ø –≤–æ—Ç —Ç–æ–∂–µ —Ä–∞–±–æ—Ç–∞—é —Å –±–æ–ª—å—à–∏–º–∏ —ç–∫—Å—Ç–µ—Ä—å–µ—Ä–∞–º–∏

, —Ç–æ–ª—å–∫–æ –º–µ–Ω—è –≤–æ—Ç —ç—Ç–æ –≤–æ–æ–±—â–µ –Ω–∏—Å–∫–æ–ª—å–∫–æ –Ω–µ –æ—Å—Ç–∞–Ω–∞–≤–ª–∏–≤–∞–µ—Ç –≤ –∏–∑—É—á–µ–Ω–∏–∏ —á–µ–≥–æ —Ç–æ –Ω–æ–≤–æ–≥–æ.¬Ý–ù—É –∏ –µ—Å–ª–∏ –≤—ã —Ä–∞–±–æ—Ç–∞–µ—Ç–µ —Å –±–æ–ª—å—à–∏–º–∏ —ç–∫—Å—Ç–µ—Ä—å–µ—Ä–∞–º–∏ –∫–∞–∫ –∏ —è...–¢–æ –∫–∞–∫–∏–µ —Ç–∞–º –∏–Ω–≤–µ—Å—Ç–∏—Ü–∏–∏, –∂–µ–ª–µ–∑–æ –∂–µ —É—Å–ª–æ–≤–Ω–æ '–∫–æ–ø–µ–π–∫–∏' —Å—Ç–æ–∏—Ç –Ω–∞ —Ñ–æ–Ω–µ –∑–∞—Ä–ø–ª–∞—Ç. –ö —Ç–æ–º—É –∂–µ –≤ Unreal Engine –µ—Å—Ç—å, –≤–Ω–µ–∑–∞–ø–Ω–æ - V-Ray –∏ Path Tracing. –ù–æ –æ–ø—è—Ç—å –∂–µ - —è –Ω–µ –∏–º–µ–ª —Å –Ω–∏–º–∏ –¥–µ–ª–∞ —á—Ç–æ –±—ã –∫–∞–∫–∏–µ —Ç–æ –∏—Å—Ç–∏–Ω–Ω—ã –ø—Ä–æ–≤–æ–∑–≥–ª–∞—à–∞—Ç—å. –ü—Ä–æ—Å—Ç–æ —è —Å—á–∏—Ç–∞—é —Å–µ–π—á–∞—Å –ø–µ—Ä—Å–ø–µ–∫—Ç–∏–≤–Ω–µ–µ –≤ –≤–∏–¥—è—Ö—É "–∏–Ω–≤–µ—Å—Ç–∏—Ä–æ–≤–∞—Ç—å" —á—Ç–æ –±—ã —É–∂–µ –Ω–∞—á–∞—Ç—å –≤–∫–∞—Ç—ã–≤–∞—Ç—å—Å—è –≤ —ç—Ç–æ –¥–µ–ª–æ. IMHO. –°–æ—Ä—è–Ω –∑–∞ –æ—Ñ—Ñ—Ç–æ–ø. –ó–∞–≤—è–∑—ã–≤–∞—é. –ü–æ —Å—É—Ç–∏ –¥–æ–±–∞–≤–∏—Ç—å –º–Ω–µ –Ω–µ—á–µ–≥–æ –ø–æ –≤–æ–ø—Ä–æ—Å—É —á—Ç–æ –ª—É—á—à–µ –±—Ä–∞—Ç—å —Å–µ–π—á–∞—Å –Ω–∞ 3 –≥–æ–¥–∞. |

|

–ù–∞ —Å–∞–π—Ç–µ c 04.06.2010

–°–æ–æ–±—â–µ–Ω–∏–π: 3941

| –í —Ü–µ–ª–æ–º –≤–∏–¥–µ–æ–∫–∞—Ä—Ç—ã –∏–Ω—Ç–µ—Ä–µ—Å–Ω—ã —Ç–µ–º, —á—Ç–æ –∏—Ö —Ç–µ–º–ø—ã –ø—Ä–∏—Ä–æ—Å—Ç–∞ –ø—Ä–æ–∏–∑–≤–æ–¥–∏—Ç–µ–ª—å–Ω–æ—Å—Ç–∏ –±–æ–ª—å—à–µ —Ç–µ–º–ø–æ–≤ –ø—Ä–∏—Ä–æ—Å—Ç–∞ –ø—Ä–æ—Ü–µ—Å—Å–æ—Ä–æ–≤. –ü–ª—é—Å, —á–µ–º –∏–Ω—Ç–µ—Ä–µ—Å–µ–Ω –¥–∞–Ω–Ω—ã–π –º–æ–º–µ–Ω—Ç –∏ –Ω–∞–¥–æ–ª–≥–æ –ª–∏ –æ–Ω, –Ω–æ —Ü–µ–Ω—ã –Ω–∞ –≤–∏–¥–µ–æ–∫–∞—Ä—Ç—ã –ø–æ–∫–∞ –≤—Å—ë —á–µ–≥–æ-—Ç–æ –ø–∞–¥–∞—é—Ç –∏ –ø–∞–¥–∞—é—Ç. –ü—Ä–æ—à–ª—ã–π –∫—Ä–∏–ø—Ç–æ–±—É–º —Å—Ä–µ–∑–∞–ª –±–æ–ª—å—à—É—é —á–∞—Å—Ç—å —Ç–µ—Ö, –∫—Ç–æ —Ö–æ—Ç–µ–ª –≤–æ–π—Ç–∏ –Ω–∞ GPU. |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| –°–Ω–æ–≤–∞ —Å–æ—Ä—è–Ω –∑–∞ –æ—Ñ—Ñ—Ç–æ–ø. –ù–æ —è –æ–±—è–∑–∞–Ω –æ–± —ç—Ç–æ–º –Ω–∞–ø–∏—Å–∞—Ç—å )) –¢—É—Ç –Ω–µ—Å–∫–æ–ª—å–∫–æ —Ä–∞–∑ –æ–±—Å—É–∂–¥–∞–ª—Å—è –º–æ–º–µ–Ω—Ç —á—Ç–æ –ø–µ—Ä—Å–ø–µ–∫—Ç–∏–≤–Ω–µ–µ –≤–∫–ª–∞–¥—ã–≤–∞—Ç—å—Å—è –≤ –≤–∏–¥—è—Ö–∏ —á–µ–º –≤ –ø—Ä–æ—Ü—ã. –í–æ—Ç —Å–æ–±—Å—Ç–≤–µ–Ω–Ω–æ —è –∏ –ø—Ä–æ–≤–µ—Ä–∏–ª —á–µ –∫–∞–∫ —Ç–∞–º –≤ UE5.1... –¶–∏—Ç–∞—Ç–∞ Holy3D: Earanak, –∏–∑–≤–∏–Ω—è—é—Å—å –∑–∞ –æ—Ñ—Ñ—Ç–æ–ø. –Ω–æ –ê–Ω—Ä–∏–∞–ª —É–º–µ–µ—Ç –≤ —Ä–µ–Ω–¥–µ—Ä —Å—Ñ–µ—Ä–∏—á–µ—Å–∫–æ–π –ø–∞–Ω–æ—Ä–∞–º—ã 20–∫ –Ω–∞ 10–∫ –ø–∏–∫—Å–µ–ª–µ–π? –° —É—á–µ—Ç–æ–º –≤—Å–µ–π —Ç—è–∂–µ—Å—Ç–∏ –ª–∞–Ω–¥—à–∞—Ñ—Ç–Ω–æ–π –∞—Ä—Ö–∏—Ç–µ–∫—Ç—É—Ä—ã, —Å –¥–∏—Å–ø–ª–µ–π—Å–º–µ–Ω—Ç–æ–º —Ç—ã—Å—è—á –∫–≤–∞–¥—Ä–∞—Ç–Ω—ã—Ö –º–µ—Ç—Ä–æ–≤ —Ä–∞–∑–ª–∏—á–Ω—ã—Ö –ø–æ–≤–µ—Ä—Ö–Ω–æ—Å—Ç–µ–π —Ç–∏–ø–∞ –±—Ä—É—Å—á–∞—Ç–∫–∏, –æ–±–ª–∏—Ü–æ–≤–∫–∏ —Ñ–∞—Å–∞–¥–æ–≤? –° —ç–ª–µ–º–µ–Ω—Ç—Ä–∞—Ä–Ω—ã–º —Ç—Ä–∏–º–æ–º –≥–∞–∑–æ–Ω–∞ –≤–¥–æ–ª—å –¥–æ—Ä–æ–∂–µ–∫? –ù–µ –≤–µ—Ä—é, —á—Ç–æ –µ—Å—Ç—å —Å—Ç—É–¥–∏–∏ –∏–ª–∏ —Ñ—Ä–∏–ª–∞–Ω—Å–µ—Ä—ã, –∫–æ—Ç–æ—Ä—ã–µ –Ω–∞—É—á–∏–ª–∏—Å—å –≤—Å—ë —ç—Ç–æ —É–∫–ª–∞–¥—ã–≤–∞—Ç—å –≤ –ì–ü–£ –≤ —Ä–∞–∑—É–º–Ω—ã–µ —Å—Ä–æ–∫–∏ —Ä–∞–∑—Ä–∞–±–æ—Ç–∫–∏. –ù–∞ —Å—á–µ—Ç –°—Ñ–µ—Ä–∏—á–µ—Å–∫–∏—Ö –ø–∞–Ω–æ—Ä–∞–º –Ω–µ –∑–Ω–∞—é –ø–æ–∫–∞ —á—Ç–æ. –¢—Ä–∞–≤—É –∫–∞–∫ —è –ø–æ–Ω—è–ª –æ–±—Ä–µ–∑–∞—é—Ç —á–µ—Ä–µ–∑ –∞–Ω–∞–ª–æ–≥ CoronaDistance (—á–µ—Ä–µ–∑ Opacity –Ω–∞ –í–∏—Ä—Ç—É–∞–ª—å–Ω—ã—Ö —Ç–µ–∫—Å—Ç—É—Ä–∞—Ö, –µ—â–µ –Ω–µ —É—á–∏–ª—Å—è —ç—Ç–æ–º—É). –ê–Ω—Ä–∏–∞–ª —É–º–µ–µ—Ç —Ä–µ–Ω–¥—Ä–∏—Ç—å —Ç–∞–π–ª–∞–º–∏, —Ö–æ—Ç—å –≤ 32–∫ —Ä–∞–∑–±–∏—Ç–æ–µ –Ω–∞ 64 —Ç–∞–π–ª–∞¬Ý ¬Ý–ë—É–∫–≤–∞–ª—å–Ω–æ —Å–µ–π—á–∞—Å –≤–æ—Ç –æ–±–∫–∞—Ç—ã–≤–∞—é –µ–≥–æ –≤ –±–æ–ª—å—à—É—â–µ–º —ç–∫—Å—Ç–µ—Ä—å–µ—Ä–µ —Å –Ω–µ–æ–ø—Ç–∏–º–∏–∑–∏—Ä–æ–≤–∞–Ω–Ω—ã–º–∏ –∞—Å—Å–µ—Ç–∞–º–∏. –ò –≤–∏–¥–æ—Å –ø–æ —ç—Ç–æ–º—É –ø–æ–≤–æ–¥—É –∑–∞–ø–∏—Å–∞–ª. –ú–æ–∂–µ—Ç –≤–∞–º –±—É–¥–µ—Ç –∏–Ω—Ç–µ—Ä–µ—Å–Ω–æ (–±–æ–ª—å—à–µ –∏–Ω—Ñ—ã –≤ —Å–æ–æ–±—â–µ–Ω–∏–∏ –ø–æ —Å—Å—ã–ª–∫–µ) -¬Ýhttps://3ddd.ru/forum/thread/show/unreal_engine_5/14#post1699310 ¬Ý ¬Ý–ë—É–∫–≤–∞–ª—å–Ω–æ —Å–µ–π—á–∞—Å –≤–æ—Ç –æ–±–∫–∞—Ç—ã–≤–∞—é –µ–≥–æ –≤ –±–æ–ª—å—à—É—â–µ–º —ç–∫—Å—Ç–µ—Ä—å–µ—Ä–µ —Å –Ω–µ–æ–ø—Ç–∏–º–∏–∑–∏—Ä–æ–≤–∞–Ω–Ω—ã–º–∏ –∞—Å—Å–µ—Ç–∞–º–∏. –ò –≤–∏–¥–æ—Å –ø–æ —ç—Ç–æ–º—É –ø–æ–≤–æ–¥—É –∑–∞–ø–∏—Å–∞–ª. –ú–æ–∂–µ—Ç –≤–∞–º –±—É–¥–µ—Ç –∏–Ω—Ç–µ—Ä–µ—Å–Ω–æ (–±–æ–ª—å—à–µ –∏–Ω—Ñ—ã –≤ —Å–æ–æ–±—â–µ–Ω–∏–∏ –ø–æ —Å—Å—ã–ª–∫–µ) -¬Ýhttps://3ddd.ru/forum/thread/show/unreal_engine_5/14#post1699310 ¬Ý –¢–∞–∫ —á—Ç–æ –ê6000 –Ω–∞ 48–≥–± –ø–æ—Ö–æ–∂–µ –Ω–µ –Ω—É–∂–Ω–æ –ø–æ–∫—É–ø–∞—Ç—å )) –¢–µ–ø–µ—Ä—å –≤–æ—Ç —Å–∏–∂—É –∏ –¥—É–º–∞—é –Ω–∞ –∫–æ–π —á–µ—Ä—Ç —è –∫—É–ø–∏–ª 13900KF+5950X, –ª—É—á—à–µ –±—ã –ø—Ä–æ–¥–∞–ª –≤—Ç–æ—Ä–æ–π –∫–æ–º–ø, –∏ –≤–∑—è–ª –±—ã RTX 4090¬Ý ¬Ý–ù—É –Ω–∏—á–µ–≥–æ, –∫–∞–∫ –≤–∏–¥–Ω–æ –≤ –∫–æ–Ω—Ü–µ –≤–∏–¥–µ–æ - 3080 10GB —Ö–≤–∞—Ç–∞–µ—Ç –ø–æ –∫—Ä–∞–π–Ω–µ–π –º–µ—Ä–µ –¥–ª—è –∏–∑—É—á–µ–Ω–∏—è –∞–Ω—Ä–∏–∞–ª–∞. ¬Ý–ù—É –Ω–∏—á–µ–≥–æ, –∫–∞–∫ –≤–∏–¥–Ω–æ –≤ –∫–æ–Ω—Ü–µ –≤–∏–¥–µ–æ - 3080 10GB —Ö–≤–∞—Ç–∞–µ—Ç –ø–æ –∫—Ä–∞–π–Ω–µ–π –º–µ—Ä–µ –¥–ª—è –∏–∑—É—á–µ–Ω–∏—è –∞–Ω—Ä–∏–∞–ª–∞. –ü–æ –ø–æ–≤–æ–¥—É —Å—Ä–æ–∫–æ–≤ —Ä–∞–∑—Ä–∞–±–æ—Ç–∫–∏. –ù–∞ –¥–∞–Ω–Ω—ã–π –º–æ–º–µ–Ω—Ç —è –ø–æ—Ç—Ä–∞—Ç–∏–ª –Ω–∞ —ç—Ç—É —Å—Ü–µ–Ω—É –≤ –ê–Ω—Ä–∏–∞–ª–µ –≥–¥–µ —Ç–æ —á–∞—Å–æ–≤ 5, –ø—Ä–µ–¥–≤–∞—Ä–∏—Ç–µ–ª—å–Ω–æ –ø–æ—Å–º–æ—Ç—Ä–µ–ª –ø–∞—Ä—É —á–∞—Å–æ–≤ —É—Ä–æ–∫–æ–≤ –∫—É–¥–∞ —á—Ç–æ –∫–ª–∞—Ü–∞—Ç—å. –ò –ø–æ–≥—É–≥–ª–∏–ª –Ω–µ–º–Ω–æ–≥–æ —á—Ç–æ –∫–∞–∫ –¥–µ–ª–∞—Ç—å, –ø—Ä–∏–º–µ—Ä–Ω–æ. –ò –µ—â–µ –≥–¥–µ —Ç–æ —á–∞—Å–æ–≤ 20-25 –∑–∞–Ω—è–ª–∞ —á–∏—Å—Ç–∫–∞ —Å—Ü–µ–Ω—ã –≤ –ú–∞–∫—Å–µ (–∏–∑ –Ω–∏—Ö –Ω–∞–≤–µ—Ä–Ω–æ–µ —á–∞—Å–æ–≤ 5 —É—à–ª–æ —Ç–æ–ª—å–∫–æ –Ω–∞ –Ω–µ–π–º–∏–Ω–≥). –ï—â–µ –º–Ω–æ–≥–æ–º—É –Ω–∞–¥–æ –Ω–∞—É—á–∏—Ç—Å—è, –Ω–æ –¥—É–º–∞—é —É–∂–µ –æ—á–µ–≤–∏–¥–Ω–æ —á—Ç–æ –ø–æ—Ä–∞ –∫–æ–º—É –∏–Ω—Ç–µ—Ä–µ—Å–Ω–æ –≤–∫–∞—Ç—ã–≤–∞—Ç—å—Å—è –≤ UE5.1... –ü–æ–∫–∞ —á—Ç–æ –Ω–µ —Å—Ç–æ–ª–∫–Ω—É–ª—Å—è –Ω–∏ —Å –æ–¥–Ω–æ–π –∑–∞–¥–∞—á–µ–π –∫–æ—Ç–æ—Ä–∞—è –±—ã —Å–∂–∏—Ä–∞–ª–∞ –º–Ω–æ–≥–æ –≤—Ä–µ–º–µ–Ω–∏. –ö–æ–Ω–µ—á–Ω–æ –º–æ–∂–Ω–æ –∑–∞–±–∏—Ç—å –Ω–∞ –Ω–µ–π–º–∏–Ω–≥ –Ω–æ... –Ø –ø–µ—Ä—Ñ–µ–∫—Ü–∏–æ–Ω–∏—Å—Ç ) UPD (–ø–æ —Ç–µ–º–µ) - –•–æ—Å–ø–∞–¥–µ, –∏ –ø–æ–ª—É –≥–æ–¥–∞ –Ω–µ –ø—Ä–æ—à–ª–æ –∫–∞–∫ 3DNews –æ–ø—É–±–ª–∏–∫–æ–≤–∞–ª–∏ –æ–±–∑–æ—Ä –Ω–∞ 7950–•... https://3dnews.ru/1078275/obzor-amd-ryzen-7950x/page-1.html ¬Ý –¢–æ –µ—Å—Ç—å –æ–Ω –Ω–∞—Å—Ç–æ–ª—å–∫–æ –Ω–∏–∫–æ–º—É –Ω–µ –Ω—É–∂–µ–Ω –±—ã—Ç—å —á—Ç–æ –ª–∏ —á—Ç–æ —Ç–æ–ª—å–∫–æ —Å–µ–π—á–∞—Å –¥–æ –Ω–µ–≥–æ —Ä—É–∫–∏ –¥–æ—à–ª–∏¬Ý –ê... –ü–æ–Ω—è–ª, –ø—Ä–æ—á–∏—Ç–∞–ª –≤ –∫–æ–Ω—Ü–µ —Å—Ç–∞—Ç—å–∏ –ø–æ—á–µ–º—É —Ç–∞–∫ –≤—ã—à–ª–æ. –ï—â–µ –ª—É—á—à–µ ))) |

|

–ù–∞ —Å–∞–π—Ç–µ c 04.06.2010

–°–æ–æ–±—â–µ–Ω–∏–π: 3941

| –¶–∏—Ç–∞—Ç–∞ Earanak: –¢–µ–ø–µ—Ä—å –≤–æ—Ç —Å–∏–∂—É –∏ –¥—É–º–∞—é –Ω–∞ –∫–æ–π —á–µ—Ä—Ç —è –∫—É–ø–∏–ª 13900KF+5950X, –ª—É—á—à–µ –±—ã –ø—Ä–æ–¥–∞–ª –≤—Ç–æ—Ä–æ–π –∫–æ–º–ø, –∏ –≤–∑—è–ª –±—ã RTX 4090 )) |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

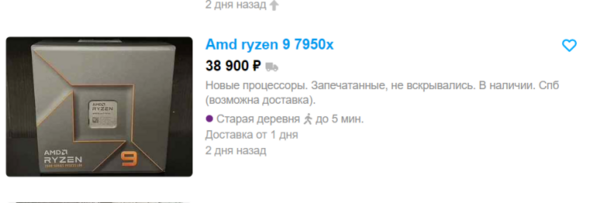

| –í–∞—É, –≤–æ—Ç —ç—Ç–æ –∫–æ–Ω–µ—á–Ω–æ 7950–• —Ä–∞—Å–ø—Ä–æ–¥–∞—é—Ç –µ—â–µ –Ω–µ —É—Å–ø–µ–≤ –æ—Ç–∫—Ä—ã—Ç—å –∫–æ—Ä–æ–±–∫—ɬÝ ¬Ý–ù–∏–∫–æ–≥–¥–∞ –µ—â–µ –Ω–µ –≤–∏–¥–µ–ª —á—Ç–æ –±—ã —Ç–∞–∫–æ–µ —Å–ª—É—á–∞–ª–æ—Å—å —Å —Ü–µ–Ω–∞–º–∏ –Ω–∞ –ø—Ä–æ—Ü –∫–æ—Ç–æ—Ä–æ–º—É –Ω–µ—Å–∫–æ–ª—å–∫–æ –º–µ—Å—è—Ü–µ–≤. –ò —ç—Ç–æ —Å—É–¥—è –ø–æ –≤—Å–µ–º—É –ø–æ–≤—Å–µ–º–µ—Å—Ç–Ω–∞—è –∏—Å—Ç–æ—Ä–∏—è )) ¬Ý–ù–∏–∫–æ–≥–¥–∞ –µ—â–µ –Ω–µ –≤–∏–¥–µ–ª —á—Ç–æ –±—ã —Ç–∞–∫–æ–µ —Å–ª—É—á–∞–ª–æ—Å—å —Å —Ü–µ–Ω–∞–º–∏ –Ω–∞ –ø—Ä–æ—Ü –∫–æ—Ç–æ—Ä–æ–º—É –Ω–µ—Å–∫–æ–ª—å–∫–æ –º–µ—Å—è—Ü–µ–≤. –ò —ç—Ç–æ —Å—É–¥—è –ø–æ –≤—Å–µ–º—É –ø–æ–≤—Å–µ–º–µ—Å—Ç–Ω–∞—è –∏—Å—Ç–æ—Ä–∏—è ))

–í –ø–æ—Å–ª–µ–¥–Ω–∏–π —Ä–∞–∑ –Ω–µ—á—Ç–æ –ø–æ–¥–æ–±–Ω–æ–µ –ø–æ–º–Ω—é –±—ã–ª–æ —Å Threadripper 1900X –∏ —Å HEDT i7-7740X )) –í—ã–≤–æ–¥—ã –≤ –æ–±–∑–æ—Ä–µ 3DNews –∫–æ–Ω–µ—á–Ω–æ –ø–µ—á–∞–ª—å–Ω—ã–µ –ø—Ä–æ –±—Ä–∞–∫–æ–≤–∞–Ω–Ω—ã–µ 7950–•, –ø—Ä–æ –∫–æ—Å—è–∫–∏ –≤ —Å–æ—Ñ—Ç–µ –∏ –±–∏–æ—Å–µ –∏ –∏–≥—Ä–∞—Ö. –ü—Ä–æ –º–µ–¥–ª–µ–Ω–Ω—ã–µ –∏ —Ç–æ–ø–æ—Ä–Ω—ã–π DDR5 –∫–æ–Ω—Ç—Ä–æ–ª–ª–µ—Ä –ø–∞–º—è—Ç–∏. –≠—Ö...¬Ý |

|

–ù–∞ —Å–∞–π—Ç–µ c 29.04.2010

–°–æ–æ–±—â–µ–Ω–∏–π: 1067

–¢–æ–ª—å—è—Ç—Ç–∏ /–°–∞–º–∞—Ä–∞/ –í–æ—Ä–æ–Ω–µ–∂

| –¶–∏—Ç–∞—Ç–∞ Earanak: –í—ã–≤–æ–¥—ã –≤ –æ–±–∑–æ—Ä–µ 3DNews –∫–æ–Ω–µ—á–Ω–æ –ø–µ—á–∞–ª—å–Ω—ã–µ –ø—Ä–æ –±—Ä–∞–∫–æ–≤–∞–Ω–Ω—ã–µ 7950–•, –ø—Ä–æ –∫–æ—Å—è–∫–∏ –≤ —Å–æ—Ñ—Ç–µ –∏ –±–∏–æ—Å–µ –∏ –∏–≥—Ä–∞—Ö. –ü—Ä–æ –º–µ–¥–ª–µ–Ω–Ω—ã–µ –∏ —Ç–æ–ø–æ—Ä–Ω—ã–π DDR5 –∫–æ–Ω—Ç—Ä–æ–ª–ª–µ—Ä –ø–∞–º—è—Ç–∏. –≠—Ö...¬Ý –¥–ª—è —Ä–∞–±–æ—á–µ–π –ª–æ—à–∞–¥–∫–∏ —Ç–æ–ø—á–∏–∫ –∑–∞ —Ü–µ–Ω—É —Ç–∞–∫—É—é... –æ–¥–Ω–∞–∫–æ —Ç–∞–∫—É—é —Ü–µ–Ω—É –≤–∏–¥–µ–ª —Ç–æ–ª—å–∫–æ –Ω–∞ –æ–∑–æ–Ω–µ –∏ —Ç–æ–ª—å–∫–æ —É –æ–¥–Ω–æ–≥–æ –ø—Ä–æ–¥–∞–≤—Ü–∞ –¶–∏—Ç–∞—Ç–∞ Earanak: –ö–æ–Ω–µ—á–Ω–æ –º–æ–∂–Ω–æ –∑–∞–±–∏—Ç—å –Ω–∞ –Ω–µ–π–º–∏–Ω–≥ –Ω–æ... –Ø –ø–µ—Ä—Ñ–µ–∫—Ü–∏–æ–Ω–∏—Å—Ç ) –¥–∞, —Ç–æ–ª—å–∫–æ –Ω—É–∂–Ω–æ —ç—Ç–æ –¥–µ–ª–æ –∏–∑–Ω–∞—á–∞–ª—å–Ω–æ –≤–≤–æ–¥–∏—Ç—å –≤ —Ä–∞–±–æ—Ç—É.. –º–Ω–æ–≥–æ –≤—Ä–µ–º–µ–Ω–∏ —ç–∫–æ–Ω–æ–º–∏—Ç. –∏–Ω—Ç–µ–µ—Ä—Å–Ω–æ –Ω–µ—Ç –ª–∏ —Å–∫—Ä–∏–ø—Ç–æ–≤ –∏ –ø–ª–∞–≥–æ–≤ —á—Ç–æ–±—ã –º–æ–∂–Ω–æ –±—ã–ª–æ –ø–µ—Ä–µ–∏–º–µ–Ω–æ–≤—ã–≤–∞—Ç—å —Å—Ä–∞–∑—É —Ü–µ–ª—ã–µ –≥—Ä—É–ø–ø—ã –æ–±—ä–µ–∫—Ç–æ–≤ —Å –ø–æ—Å—Ç—Ñ–∏–∫—Å–∞–º–∏ —Ç–∏–ø–∞ _0001... |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.11.2009

–°–æ–æ–±—â–µ–Ω–∏–π: 4863

–ú–æ—Å–∫–≤–∞

| –¶–∏—Ç–∞—Ç–∞ Earanak: –•–æ—Å–ø–∞–¥–µ, –∏ –ø–æ–ª—É –≥–æ–¥–∞ –Ω–µ –ø—Ä–æ—à–ª–æ –∫–∞–∫ 3DNews –æ–ø—É–±–ª–∏–∫–æ–≤–∞–ª–∏ –æ–±–∑–æ—Ä –Ω–∞ 7950–•. –ò –≤ –∫–∞–º–µ–Ω—Ç–∞—Ö —ç—Ç–æ–º—É –æ–±–∑–æ—Ä—É –Ω–∞–ø–∏—Ö–∞–ª–∏ –≤ –ø–∞–Ω–∞–º–∫—É.¬Ý –ß—Ç–æ, –≤ –ø—Ä–∏–Ω—É–∏–ø–µ, –Ω–µ –æ—Ç–º–µ–Ω—è–µ—Ç —Å—Ç—Ä–∞–Ω–Ω–æ—Å—Ç–∏ –ø—Ä–æ—Ü–∞ |

|

–ù–∞ —Å–∞–π—Ç–µ c 24.06.2014

–°–æ–æ–±—â–µ–Ω–∏–π: 4895

| |

|